データサイエンティストの必須知識、Python, 高校数学, 統計学, 機械学習, ディープラーニングを5時間で学びましょう!

Pythonの基礎

Pythonの基礎を学ぶために、まずは以下の概念を理解することが重要です。

変数 (Variables): 変数はデータを格納するための名前付きコンテナです。例えば、数値、テキスト、リスト、辞書などのデータを変数に格納できます。変数は後で再利用できます。

name = "John" # 文字列をnameという変数に格納

age = 30 # 整数をageという変数に格納データ型 (Data Types): Pythonはさまざまなデータ型をサポートしています。主要なデータ型には以下があります。

- 整数 (int): 正の整数や負の整数。例:

5,-10 - 浮動小数点数 (float): 小数点を含む数値。例:

3.14,0.5 - 文字列 (string): テキストデータ。例:

"Hello, World!",'Python' - リスト (list): 複数の要素を順序付けて格納。例:

[1, 2, 3],["apple", "banana", "cherry"] - 辞書 (dictionary): キーと値のペアを格納。例:

{"name": "John", "age": 30} - ブール (bool): 真 (True) または偽 (False) の値。条件式の結果として使用。例:

True,False

変数への代入 (Variable Assignment): 変数に値を代入するには、変数名に対して等号 (=) を使用します。

x = 10 # xという変数に整数10を代入

name = "Alice" # nameという変数に文字列"Alice"を代入変数の使用 (Variable Usage): 代入された変数は後で使用できます。

print(x) # 10 変数xの値を表示

print("Hello, " + name) # Hello, Alice 文字列の結合データ型の操作 (Data Type Operations): 各データ型は特定の操作をサポートします。例えば、数値の加算、文字列の結合、リストへの要素の追加などがあります。

num1 = 5

num2 = 3

result = num1 + num2 # 数値の加算

print(result) # 8 結果を表示

greeting = "Hello, "

name = "Alice"

message = greeting + name # 文字列の結合

print(message) # Hello, Alice 結果を表示

fruits = ["apple", "banana"]

fruits.append("cherry") # リストへの要素の追加

print(fruits) # ['apple', 'banana', 'cherry'] 更新されたリストを表示Pythonの基本的な概念である変数とデータ型を理解することは、プログラミングの基盤を築く重要なステップです。これらの概念を理解した後、条件分岐、ループ、関数などの高度なプログラミングトピックをマスターできます。

Pythonの基礎における条件分岐とループの使用について説明します。

条件分岐 (Conditional Statements):

条件分岐は、プログラムが特定の条件に応じて異なるアクションを実行するための制御構造です。Pythonでは主に以下の2つの条件分岐が使用されます。

if文 (if statement): 特定の条件が真 (True) の場合、指定されたコードブロックを実行します。

age = 20

if age >= 18:

print("成人です。")

# 成人です。if-else文 (if-else statement): 条件が真の場合と偽 (False) の場合、それぞれ異なるコードブロックを実行します。

age = 15

if age >= 18:

print("成人です。")

else:

print("未成年です。")

# 未成年です。if-elif-else文 (if-elif-else statement): 複数の条件をチェックし、最初に真の条件に合致したブロックを実行します。最後のelse節はどの条件にも合致しない場合に実行されます。

score = 85

if score >= 90:

print("優秀です。")

elif score >= 70:

print("普通です。")

else:

print("不合格です。")

# 普通です。ループ (Loops):

ループは、同じコードブロックを繰り返し実行するための制御構造です。Pythonでは主に以下の2つのループが使用されます。

forループ (for loop): シーケンス(リスト、タプル、文字列など)内の要素を繰り返し処理します。

fruits = ["りんご", "バナナ", "いちご"]

for fruit in fruits:

print(fruit)

# りんご

# バナナ

# いちごwhileループ (while loop): 指定した条件が真の間、繰り返し処理を続けます。

count = 0

while count < 5:

print(count)

count += 1

# 0

# 1

# 2

# 3

# 4breakとcontinue: ループ内で使用され、breakはループを終了し、continueは現在の繰り返しをスキップして次の繰り返しに進みます。

for i in range(5):

if i == 3:

break # iが3のときループ終了

print(i)

for i in range(5):

if i == 3:

continue # iが3のとき次のループへ

print(i)

# 1

# 2

# 0

# 1

# 2

# 4条件分岐とループは、プログラミングでさまざまなタスクを自動化し、データを処理するために不可欠な概念です。これらを使いこなすことで、複雑なプログラムを作成できるようになります。

Pythonの基礎における関数の定義と呼び出しについて説明します。

関数の定義 (Function Definition):

関数は、一連の処理をまとめて名前をつけ、再利用可能なブロックとして定義します。関数を定義することで、同じ処理を何度も記述せずに済み、コードのメンテナンスが容易になります。

Pythonでは関数を次のように定義します。

def greet(name):

"""指定された名前で挨拶する関数"""

print(f"こんにちは、{name}さん!")defキーワードを使って関数を開始します。- 関数名 (

greet) は自分で決めることができます。 - 関数の引数(ここでは

name)は、関数に渡す情報を指定します。 - 引数を取らない場合、

()内を空にします。 - 関数の本体はコロン (

:) の後にインデントされています。 - 関数のドキュメンテーション文字列(

""" """で囲まれた部分)は、関数の説明を提供します。

関数の呼び出し (Function Call):

関数を呼び出すことで、定義した関数の中に含まれる処理が実行されます。関数を呼び出すには、関数名に引数を渡します。

greet("Alice")

# こんにちは、Aliceさん!- 関数名 (

greet) を呼び出し、引数として"Alice"を渡しています。

戻り値 (Return Value):

関数はしばしば値を返すことがあります。これを戻り値と呼び、return ステートメントを使用して指定します。戻り値がある場合、関数の呼び出し元でその値を利用できます。

def add(a, b):

"""2つの数値を足し合わせる関数"""

result = a + b

return result

sum = add(3, 5)

print(sum)

# 8returnステートメントは関数内で計算された値を呼び出し元に返します。- 戻り値を変数 (

sum) に代入して利用できます。

関数はプログラムの構造化に役立ち、同じ処理を何度も書かずに済むため、コードの保守性と可読性を向上させます。関数をうまく活用することで、効率的なプログラミングが可能になります。

Pythonの基礎におけるモジュールのインポートと使用について説明します。

モジュールのインポート (Module Import):

Pythonでは、モジュールと呼ばれる外部のコードを利用できます。モジュールは、関数や変数を含んだPythonのスクリプトファイルです。モジュールを使用するためには、それをインポートする必要があります。

モジュールのインポートは次のように行います。

import モジュール名例えば、Pythonの標準ライブラリであるmathモジュールをインポートする場合:

import mathモジュールの使用 (Module Usage):

モジュールをインポートすると、そのモジュール内で定義されている関数や変数を使用できるようになります。モジュールの要素を使用するには、モジュール名の後にドット (.) を付けてアクセスします。

例えば、mathモジュールのsqrt関数を使用して平方根を計算する場合:

import math

x = 25

y = math.sqrt(x) # mathモジュール内のsqrt関数を使用して平方根を計算

print(y)

# 5.0モジュールの別名 (Module Alias):

モジュール名が長い場合や、同じ名前のモジュールが複数存在する場合、モジュールに別名(エイリアス)をつけることができます。これにより、短い名前でモジュールを使用できます。

別名をつけるには、asキーワードを使用します。

例えば、matplotlib.pyplotモジュールをpltとしてインポートする場合:

import matplotlib.pyplot as plt特定の要素のみインポート (Import Specific Elements):

モジュールから特定の関数や変数のみをインポートすることもできます。これにより、モジュール全体をインポートする必要がなく、必要な要素のみを使えます。

例えば、randomモジュールからrandint関数だけをインポートする場合:

from random import randintこれにより、randint関数をrandom.randintではなく、単にrandintとして使用できます。

モジュールを使うことで、他の人が作成した便利なコードを再利用できるため、Pythonの強力な機能の一つです。プログラムを効率的に書くために、適切なモジュールを見つけて活用することが大切です。

Pythonの基礎におけるエラーハンドリングと例外処理について説明します。

エラーハンドリングとは (Error Handling):

プログラムを実行している際にエラーが発生することはよくあります。エラーが発生した場合、プログラムがクラッシュすることを避けるために、エラーをキャッチして適切に処理することが重要です。これをエラーハンドリングと呼びます。

例外とは (Exceptions):

Pythonでは、エラーは例外として扱われます。例外は予期せぬ状況やエラーを示すオブジェクトです。例外が発生すると、プログラムの実行が中断され、対応するエラーメッセージが表示されます。

例外処理の基本 (Basic Exception Handling):

Pythonではtryとexceptキーワードを使用して例外処理を実装します。基本的な構文は以下の通りです。

try:

# 例外が発生する可能性のあるコード

except エラーの種類 as 変数:

# エラーが発生した場合の処理例えば、ゼロで割り算を試みるとZeroDivisionErrorという例外が発生します。この例外をキャッチして処理するコードは以下のようになります。

try:

result = 10 / 0 # ゼロで割り算

except ZeroDivisionError as e:

print("エラーが発生しました:", e)複数の例外の処理 (Handling Multiple Exceptions):

複数の異なる種類の例外をキャッチすることも可能です。例外処理は上から順番に評価され、最初にマッチした例外が処理されます。

try:

# 例外が発生する可能性のあるコード

except エラーの種類1 as 変数1:

# エラー1が発生した場合の処理

except エラーの種類2 as 変数2:

# エラー2が発生した場合の処理例えば、ゼロで割り算と値の変換エラーを処理するコードは以下のようになります。

try:

result = int("abc") / 0 # 値の変換エラーとゼロで割り算

except ValueError as e:

print("値の変換エラーが発生しました:", e)

except ZeroDivisionError as e:

print("ゼロで割り算のエラーが発生しました:", e)例外処理の最後 (Finally Block):

tryとexceptの後にfinallyブロックを追加できます。finallyブロックは例外が発生してもしなくても、最終的に実行されるコードを含む場所です。たとえば、ファイルを閉じる操作などに使用されます。

try:

# 例外が発生する可能性のあるコード

except エラーの種類 as 変数:

# エラーが発生した場合の処理

finally:

# 例外の有無にかかわらず実行される処理例えば、ファイルを開いて処理し、必ずファイルを閉じるコードは次のようになります。

try:

file = open("example.txt", "r")

content = file.read()

except FileNotFoundError as e:

print("ファイルが見つかりませんでした:", e)

finally:

file.close() # ファイルを閉じるエラーハンドリングと例外処理を適切に行うことで、プログラムの信頼性を高め、エラーが発生してもプログラムがクラッシュしないようにできます。

NumPy(Numerical Python)は、Pythonで数値計算を行うための重要なライブラリです。以下にNumPyの基本的な使用法とインストール方法を説明します。

NumPyのインストール (Installation):

NumPyを使用するには、まずライブラリをインストールする必要があります。通常、次の方法でインストールできます。

pipを使用してインストール:

pip install numpyAnacondaを使用してインストール(Anacondaを使用している場合):

conda install numpyNumPyのインポート (Importing NumPy):

NumPyをインストールしたら、Pythonプログラムで使用するために次のようにライブラリをインポートします。

import numpy as npこのようにすることで、NumPyの機能を使用できるようになります。npという別名(エイリアス)を使用することが一般的ですが、他の名前を選ぶこともできます。

NumPyの基本的な機能 (Basic NumPy Features):

NumPyは多次元配列(ndarray)を扱うための強力なツールを提供します。以下はNumPyの基本的な機能のいくつかです。

多次元配列の作成: NumPyの主要なデータ構造は多次元配列です。これらの配列を作成するには、np.array()関数を使用します。

arr = np.array([1, 2, 3, 4, 5])配列の操作: 配列内の要素へのアクセス、スライシング、変更などができます。

print(arr[0]) # 要素へのアクセス

# 1

print(arr[1:4]) # スライス

# [2 3 4]

arr[2] = 10 # 要素の変更配列の演算: NumPyを使用して、配列同士の演算(加算、減算、乗算、除算など)が簡単に行えます。

arr1 = np.array([1, 2, 3])

arr2 = np.array([4, 5, 6])

result = arr1 + arr2 # 配列同士の加算多次元配列: NumPyでは多次元配列を簡単に作成できます。

matrix = np.array([[1, 2, 3], [4, 5, 6]])統計処理: NumPyは配列内の統計的な計算(平均、合計、標準偏差など)をサポートします。

mean_value = np.mean(arr)

sum_value = np.sum(arr)これらはNumPyの基本的な機能の一部です。NumPyはデータ処理、科学計算、機械学習などの幅広い分野で使用され、数値計算を効率的に行うための必須ツールとして広く使われています。NumPyの公式ドキュメントやチュートリアルを参照すると、さらに詳細な情報を得ることができます。

NumPyは、多次元配列(通常はndarrayと呼ばれる)を操作するためのPythonライブラリで、数値計算、データ処理、科学計算などに広く使用されます。以下では、NumPy配列の基本的な作成と操作について説明します。

NumPy配列(ndarray)の作成:

リストからNumPy配列を作成する:

import numpy as np

my_list = [1, 2, 3, 4, 5]

my_array = np.array(my_list)これにより、PythonのリストからNumPy配列が作成されます。

ゼロ配列や一様な値の配列を作成する:

zeros_array = np.zeros(5) # 0で初期化された長さ5の配列

ones_array = np.ones(3) # 1で初期化された長さ3の配列

constant_array = np.full(4, 7) # 7で初期化された長さ4の配列範囲を持つ配列を作成する:

range_array = np.arange(1, 10, 2) # 1から9までの奇数を持つ配列ランダムな値を持つ配列を作成する:

random_array = np.random.rand(3, 3) # 3x3のランダムな値を持つ配列NumPy配列の操作:

要素へのアクセス:

my_array = np.array([1, 2, 3, 4, 5])

print(my_array[0]) # 1番目の要素にアクセス

# 1スライシング:

sliced_array = my_array[1:4] # インデックス1から3までの要素を取得配列の演算:

array1 = np.array([1, 2, 3])

array2 = np.array([4, 5, 6])

result = array1 + array2 # 配列同士の加算形状の変更:

original_array = np.array([1, 2, 3, 4, 5, 6])

reshaped_array = original_array.reshape(2, 3) # 2x3の形状に変更要素の追加と削除:

array = np.array([1, 2, 3])

new_array = np.append(array, 4) # 要素を末尾に追加

removed_array = np.delete(array, 1) # インデックス1の要素を削除これらはNumPy配列の基本的な作成と操作の一部です。NumPyは、数値計算の高速化やデータ処理の効率化に役立つとても強力なライブラリです。NumPyを使いこなすことで、データの操作や解析が簡単に行えるようになります。

NumPyの配列(ndarray)では、要素にアクセスするためのインデックスとスライシングを使用します。以下では、これらの基本的な操作について説明します。

配列のインデックス:

NumPy配列の要素にアクセスするには、要素のインデックスを指定します。Pythonリストと同様に、インデックスは0から始まります。

import numpy as np

my_array = np.array([10, 20, 30, 40, 50])

# インデックスを使用して要素にアクセス

element = my_array[2] # インデックス2の要素にアクセス (30)配列のスライシング:

スライシングを使用すると、配列内の連続した要素のサブセットを取得できます。

import numpy as np

my_array = np.array([10, 20, 30, 40, 50])

# スライスを使用して要素のサブセットを取得

subset = my_array[1:4] # インデックス1から3までの要素を取得 ([20, 30, 40])スライスは、開始位置と終了位置(終了位置は含まれない)を指定します。上記の例では、インデックス1から3までの要素が取得されています。

ステップ値を指定したスライシング:

さらに、スライス時にステップ値を指定することもできます。ステップ値は、要素をどれだけスキップするかを制御します。

import numpy as np

my_array = np.array([10, 20, 30, 40, 50, 60, 70, 80])

# ステップ値を指定したスライス

subset = my_array[1:7:2] # インデックス1から6までの要素を2つおきに取得 ([20, 40, 60])この例では、インデックス1から6までの要素を2つおきに取得しています。

これらの操作を駆使することで、NumPy配列内の要素を効果的に操作し、データ処理や解析ができます。

NumPyを使った配列の数学的演算は、データ処理や科学計算においてとても重要です。以下に、NumPyを使用して配列を使った基本的な数学的演算について説明します。

配列同士の基本的な演算:

加算と減算:

NumPyの配列同士を加算または減算できます。配列の要素ごとに演算が行われます。

import numpy as np

arr1 = np.array([1, 2, 3])

arr2 = np.array([4, 5, 6])

# 配列の加算

result_add = arr1 + arr2 # [5, 7, 9]

# 配列の減算

result_subtract = arr1 - arr2 # [-3, -3, -3]乗算と除算:

同様に、NumPyの配列同士を乗算または除算することもできます。

import numpy as np

arr1 = np.array([1, 2, 3])

arr2 = np.array([4, 5, 6])

# 配列の乗算

result_multiply = arr1 * arr2 # [4, 10, 18]

# 配列の除算

result_divide = arr1 / arr2 # [0.25, 0.4, 0.5]配列の数学的演算関数:

NumPyには、配列に対して数学的な操作を行うための関数も用意されています。

内積:

配列同士の内積は np.dot() 関数を使用して計算できます。

import numpy as np

arr1 = np.array([1, 2, 3])

arr2 = np.array([4, 5, 6])

# 配列の内積

result_dot = np.dot(arr1, arr2) # 32平方根や三角関数:

NumPyは、np.sqrt()(平方根)、np.sin()(正弦)、np.cos()(余弦)、np.tan()(正接)など、多くの数学関数も提供しています。

import numpy as np

arr = np.array([1, 4, 9])

# 平方根の計算

result_sqrt = np.sqrt(arr) # [1. 2. 3.]

# 正弦の計算

result_sin = np.sin(arr) # [0.84147098 -0.7568025 0.41211849]これらの基本的な数学的演算は、NumPyの強力な機能を活用して、さまざまな数値計算やデータ処理のタスクで使用できます。

NumPyを使用した配列の統計的操作は、データ解析や科学計算においてとても重要です。以下に、NumPyを使って配列の統計的操作を行う方法を説明します。

配列の統計的操作:

平均値(平均)の計算:

NumPyの np.mean() 関数を使用して、配列の平均値を計算できます。

import numpy as np

arr = np.array([1, 2, 3, 4, 5])

# 平均値の計算

mean_value = np.mean(arr) # 3.0中央値の計算:

中央値は、データの中央に位置する値を示します。NumPyの np.median() 関数を使用して中央値を計算できます。

import numpy as np

arr = np.array([1, 2, 3, 4, 5])

# 中央値の計算

median_value = np.median(arr) # 3.0分散と標準偏差の計算:

分散と標準偏差は、データのばらつき度合いを示す統計的な指標です。分散は np.var()、標準偏差は np.std() 関数を使用して計算できます。

import numpy as np

arr = np.array([1, 2, 3, 4, 5])

# 分散の計算

variance_value = np.var(arr) # 2.5

# 標準偏差の計算

std_deviation_value = np.std(arr) # 1.5811388300841898最大値と最小値の取得:

最大値と最小値は、データの範囲を示す指標です。np.max() と np.min() 関数を使用して取得できます。

import numpy as np

arr = np.array([1, 2, 3, 4, 5])

# 最大値の取得

max_value = np.max(arr) # 5

# 最小値の取得

min_value = np.min(arr) # 1これらの統計的操作は、NumPyを使用して配列データの特性を理解し、データ解析や科学的な研究に活用する際に役立ちます。

NumPyのブロードキャストは、異なる形状の配列間で演算を行う際に、自動的に形状を調整して計算を行う機能です。これにより、形状の異なる配列間で要素ごとの演算を簡単に行うことができます。以下に、NumPyのブロードキャストの基本的な考え方を説明します。

ブロードキャストの基本:

- 形状の一致:

ブロードキャストを行うためには、少なくとも片方の配列の形状が他方の配列の形状に対して「適合」している必要があります。形状の一致とは、次元ごとに対応する次元のサイズが等しいことを意味します。例えば、1次元配列と2次元配列をブロードキャストする場合、1次元の配列を2次元に「拡張」することが考えられます。 - 自動拡張:

ブロードキャストにおいて、NumPyは自動的に形状を調整して計算を実行します。形状の不一致がある場合、NumPyは適切に拡張して演算を行います。

ブロードキャストの例:

import numpy as np

# 1次元配列とスカラーの演算 (スカラーが1次元に拡張される)

arr1 = np.array([1, 2, 3, 4])

result = arr1 + 2 # [3, 4, 5, 6]

# 2次元配列と1次元配列の演算 (1次元配列が2次元に拡張される)

arr2 = np.array([[1, 2], [3, 4]])

arr3 = np.array([10, 20])

result = arr2 + arr3

# 結果:

# [[11 22]

# [13 24]]上記の例では、ブロードキャストによってスカラーと1次元配列、または1次元配列と2次元配列の間で演算が実行されました。NumPyは、配列を必要な形状に拡張して計算を行っています。

ブロードキャストは、NumPyを使って効率的なコードを書く上でとても便利であり、ループを明示的に書かずに多くの要素ごとの操作を実現します。

Matplotlibは、Pythonでグラフやプロットを作成するためのとても人気のあるライブラリです。Matplotlibを使ってグラフを描画するためには、まずMatplotlibをインストールし、必要なライブラリをインポートする必要があります。以下に、Matplotlibの基本的な使い方を説明します。

Matplotlibのインストールとインポート:

Matplotlibを使うためには、まずインストールが必要です。通常、次のコマンドを使用してMatplotlibをインストールできます。

pip install matplotlibインストールが完了したら、Pythonスクリプト内でMatplotlibをインポートします。

import matplotlib.pyplot as pltここで、pltは一般的な別名で、Matplotlibの関数やメソッドを使う際に便利です。この別名は慣習的によく使用されますが、別の名前を選んでも問題ありません。

グラフの描画:

Matplotlibを使ってグラフを描画する際には、以下のステップに従います。

- データの準備: グラフに表示するデータを用意します。

- グラフの作成:

plt.figure()を使用して新しいグラフを作成します。 - プロット: データをグラフにプロットします。例えば、

plt.plot()を使用して線グラフを描画できます。 - グラフのカスタマイズ: タイトル、軸ラベル、凡例などのカスタマイズを行います。

- 表示または保存:

plt.show()を使用してグラフを表示するか、plt.savefig()を使用して画像ファイルとして保存します。

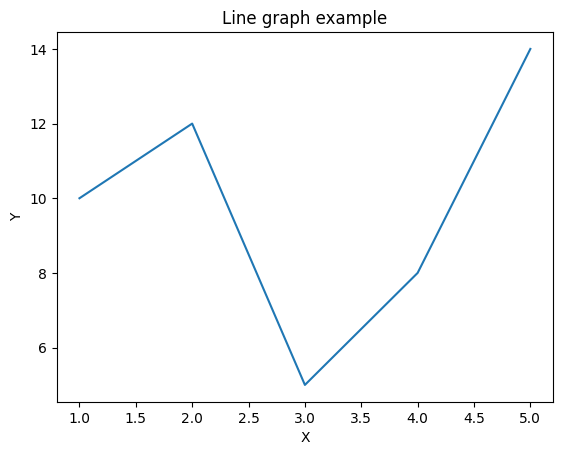

以下は、Matplotlibを使用して簡単な折れ線グラフを描画する例です。

import matplotlib.pyplot as plt

# データの準備

x = [1, 2, 3, 4, 5]

y = [10, 12, 5, 8, 14]

# グラフの作成

plt.figure()

# プロット

plt.plot(x, y)

# グラフのカスタマイズ

plt.title('Line graph example')

plt.xlabel('X')

plt.ylabel('Y')

# グラフの表示

plt.show()

このコードは、Matplotlibを使って単純な折れ線グラフを描画する例です。必要に応じて、さまざまな種類のグラフを描画したり、カスタマイズしたりできます。 Matplotlibの公式ドキュメンテーションにはさらに詳細な情報が提供されています。

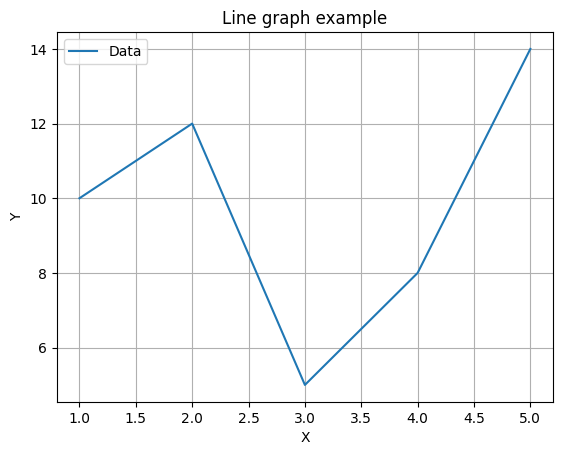

Matplotlibを使用して折れ線グラフを描画するためには、以下のステップに従います。

データを用意する: グラフに表示したいデータをPythonのリストやNumPy配列などで用意します。

Matplotlibをインポートする: MatplotlibライブラリをPythonスクリプトにインポートします。

import matplotlib.pyplot as pltデータをプロットする: plt.plot()関数を使用してデータをプロットします。この関数にX軸とY軸のデータを渡します。

x = [1, 2, 3, 4, 5] # X軸のデータ

y = [10, 12, 5, 8, 14] # Y軸のデータ

plt.plot(x, y) # プロットグラフのカスタマイズ: グラフの見た目をカスタマイズできます。タイトル、軸ラベル、凡例、線のスタイル、色などを設定できます。

plt.title('Line graph example') # グラフのタイトル

plt.xlabel('X') # X軸のラベル

plt.ylabel('Y') # Y軸のラベル

plt.legend(['データ']) # 凡例

plt.grid(True) # グリッド線の表示グラフの表示または保存: plt.show()関数を使用してグラフを表示します。または、plt.savefig()関数を使用して画像ファイルとして保存できます。

plt.show() # グラフを表示

# plt.savefig('my_plot.png') # グラフを画像ファイルとして保存(オプション)

以下は、これらのステップを組み合わせた折れ線グラフの例です。

import matplotlib.pyplot as plt

# データの用意

x = [1, 2, 3, 4, 5]

y = [10, 12, 5, 8, 14]

# グラフの作成とプロット

plt.plot(x, y)

# グラフのカスタマイズ

plt.title('Line graph example')

plt.xlabel('X')

plt.ylabel('Y')

# グラフの表示

plt.show()

このコードを実行すると、指定したデータに基づいた折れ線グラフが表示されます。必要に応じて、データやグラフのカスタマイズを調整できます。

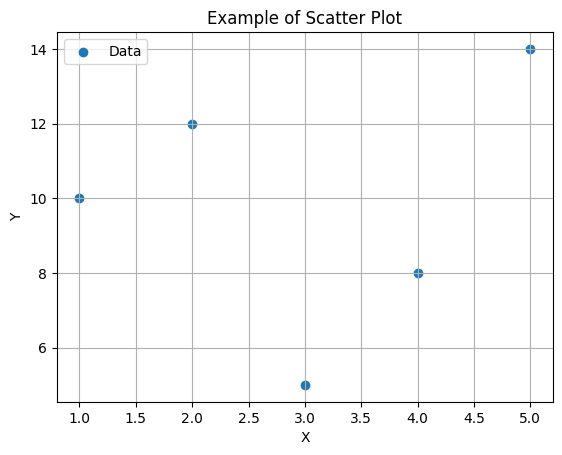

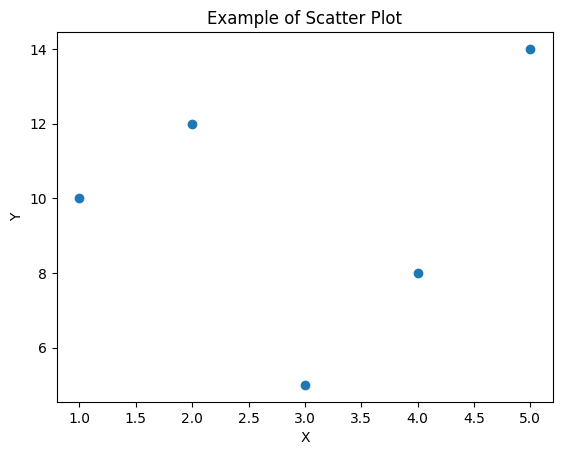

Matplotlibを使用して散布図(scatter plot)を描画するためには、以下のステップに従います。

データを用意する: グラフに表示したいデータをPythonのリストやNumPy配列などで用意します。データはX軸とY軸の値のペアとして持っておく必要があります。

Matplotlibをインポートする: MatplotlibライブラリをPythonスクリプトにインポートします。

import matplotlib.pyplot as plt散布図をプロットする: plt.scatter()関数を使用して散布図をプロットします。この関数にX軸とY軸のデータを渡します。

x = [1, 2, 3, 4, 5] # X軸のデータ

y = [10, 12, 5, 8, 14] # Y軸のデータ

plt.scatter(x, y) # 散布図のプロットグラフのカスタマイズ: グラフの見た目をカスタマイズできます。タイトル、軸ラベル、凡例、点のサイズ、色などを設定できます。

plt.title('Example of Scatter Plot') # グラフのタイトル

plt.xlabel('X') # X軸のラベル

plt.ylabel('Y') # Y軸のラベル

plt.legend(['Data']) # 凡例

plt.grid(True) # グリッド線の表示グラフの表示または保存: plt.show()関数を使用してグラフを表示します。または、plt.savefig()関数を使用して画像ファイルとして保存できます。

plt.show() # グラフを表示

# plt.savefig('my_scatter_plot.png') # グラフを画像ファイルとして保存(オプション)

以下は、これらのステップを組み合わせた散布図の例です。

import matplotlib.pyplot as plt

# データの用意

x = [1, 2, 3, 4, 5]

y = [10, 12, 5, 8, 14]

# 散布図の作成とプロット

plt.scatter(x, y)

# グラフのカスタマイズ

plt.title('Example of Scatter Plot') # グラフのタイトル

plt.xlabel('X') # X軸のラベル

plt.ylabel('Y') # Y軸のラベル

# グラフの表示

plt.show()

このコードを実行すると、指定したデータに基づいた散布図が表示されます。必要に応じて、データやグラフのカスタマイズを調整できます。

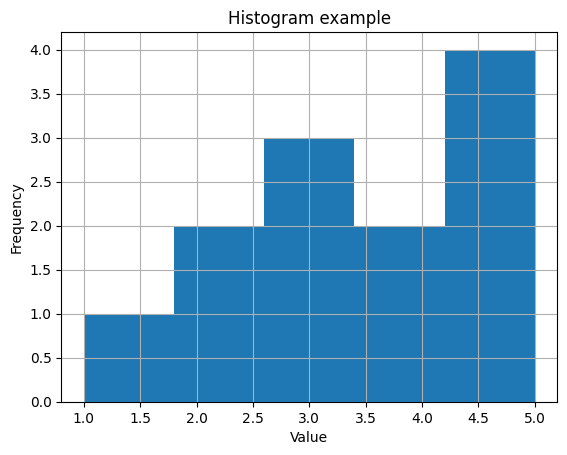

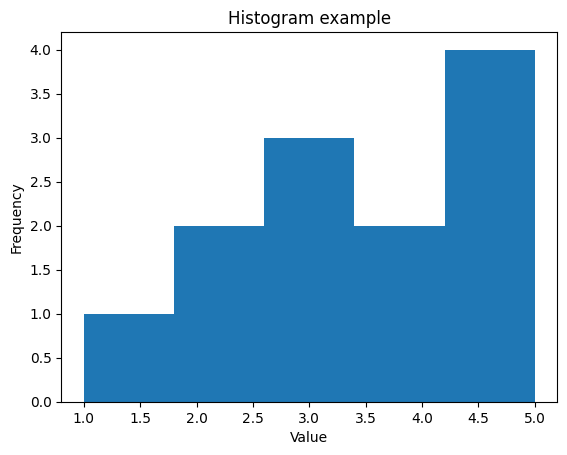

Matplotlibを使用してヒストグラムを作成するためには、以下のステップに従います。

データを用意する: ヒストグラムを作成したいデータをPythonのリストやNumPy配列などで用意します。

Matplotlibをインポートする: MatplotlibライブラリをPythonスクリプトにインポートします。

import matplotlib.pyplot as pltヒストグラムをプロットする: plt.hist()関数を使用してヒストグラムをプロットします。この関数にデータとビン(階級)の数を渡します。

data = [1, 2, 2, 3, 3, 3, 4, 4, 5, 5, 5, 5]

plt.hist(data, bins=5) # ヒストグラムのプロットグラフのカスタマイズ: グラフの見た目をカスタマイズできます。タイトル、軸ラベル、凡例、ビンの幅、色などを設定できます。

import matplotlib.pyplot as plt

data = [1, 2, 2, 3, 3, 3, 4, 4, 5, 5, 5, 5]

plt.hist(data, bins=5) # ヒストグラムのプロット

plt.title('Histogram example') # グラフのタイトル

plt.xlabel('Value') # X軸のラベル

plt.ylabel('Frequency') # Y軸のラベル

plt.grid(True) # グリッド線の表示グラフの表示または保存: plt.show()関数を使用してグラフを表示します。または、plt.savefig()関数を使用して画像ファイルとして保存できます。

plt.show() # グラフを表示

# plt.savefig('my_histogram.png') # グラフを画像ファイルとして保存(オプション)

以下は、これらのステップを組み合わせたヒストグラムの例です。

import matplotlib.pyplot as plt

# データの用意

data = [1, 2, 2, 3, 3, 3, 4, 4, 5, 5, 5, 5]

# ヒストグラムの作成とプロット

plt.hist(data, bins=5)

# グラフのカスタマイズ

plt.title('Histogram example') # グラフのタイトル

plt.xlabel('Value') # X軸のラベル

plt.ylabel('Frequency') # Y軸のラベル

# グラフの表示

plt.show()

このコードを実行すると、指定したデータからヒストグラムが生成され、グラフが表示されます。必要に応じて、データやグラフのカスタマイズを調整できます。

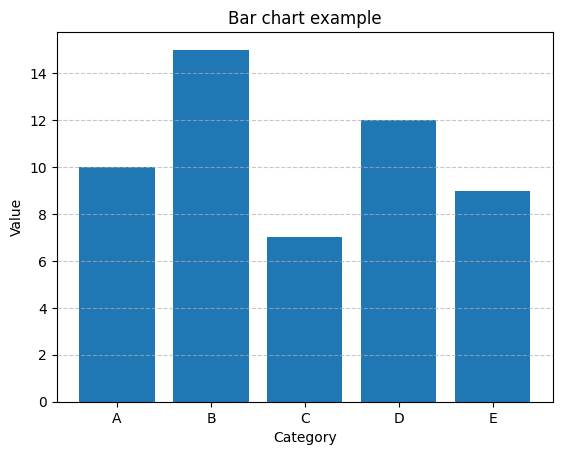

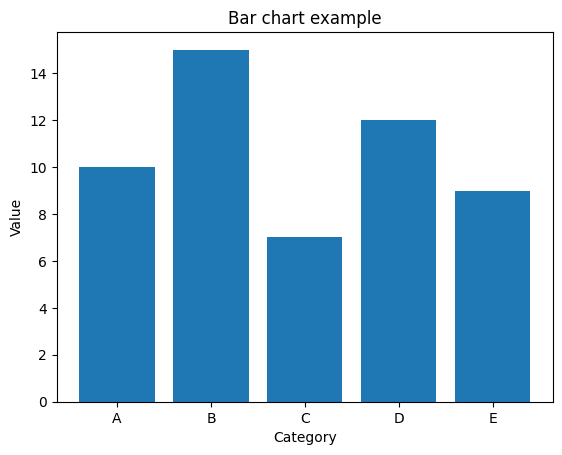

Matplotlibを使用して棒グラフ(バーチャート)を作成するためには、以下のステップに従います。

データを用意する: 棒グラフを作成したいカテゴリや項目のデータを用意します。データはリストやNumPy配列などで表現されます。

Matplotlibをインポートする: MatplotlibライブラリをPythonスクリプトにインポートします。

import matplotlib.pyplot as plt棒グラフをプロットする: plt.bar()関数を使用して棒グラフをプロットします。この関数にデータとX軸の位置を指定します。

categories = ['A', 'B', 'C', 'D', 'E'] # カテゴリや項目のリスト

values = [10, 15, 7, 12, 9] # 各カテゴリの値

plt.bar(categories, values) # 棒グラフのプロットグラフのカスタマイズ: グラフの見た目をカスタマイズできます。タイトル、軸ラベル、凡例、色、幅などを設定できます。

plt.title('Bar chart example') # グラフのタイトル

plt.xlabel('Category') # X軸のラベル

plt.ylabel('Value') # Y軸のラベル

plt.grid(axis='y', linestyle='--', alpha=0.7) # Y軸にグリッド線を表示グラフの表示または保存: plt.show()関数を使用してグラフを表示します。または、plt.savefig()関数を使用して画像ファイルとして保存できます。

plt.show() # グラフを表示

# plt.savefig('my_bar_chart.png') # グラフを画像ファイルとして保存(オプション)

以下は、これらのステップを組み合わせた棒グラフの例です。

import matplotlib.pyplot as plt

# カテゴリと値のデータ

categories = ['A', 'B', 'C', 'D', 'E']

values = [10, 15, 7, 12, 9]

# 棒グラフの作成とプロット

plt.bar(categories, values)

# グラフのカスタマイズ

plt.title('Bar chart example') # グラフのタイトル

plt.xlabel('Category') # X軸のラベル

plt.ylabel('Value') # Y軸のラベル

# グラフの表示

plt.show()

このコードを実行すると、指定したカテゴリと値から棒グラフが生成され、グラフが表示されます。必要に応じて、データやグラフのカスタマイズを調整できます。

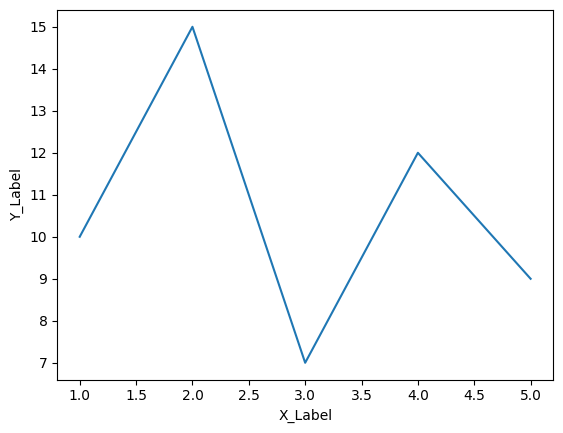

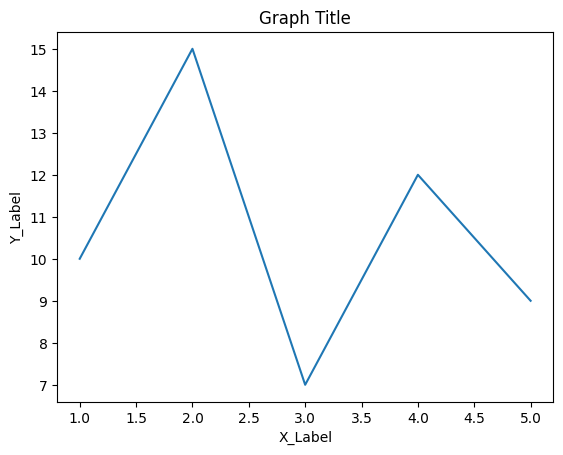

Matplotlibを使用してグラフにラベル、タイトル、凡例を追加する方法を説明します。以下の例では、折れ線グラフを使いますが、同様の方法で他の種類のグラフにも適用できます。

ラベルの追加:

ラベルは、軸に対してデータの説明や単位を提供します。

import matplotlib.pyplot as plt

x = [1, 2, 3, 4, 5]

y = [10, 15, 7, 12, 9]

plt.plot(x, y)

plt.xlabel('X_Label')

plt.ylabel('Y_Label')

上記の例では、X軸とY軸に対するラベルが追加されました。

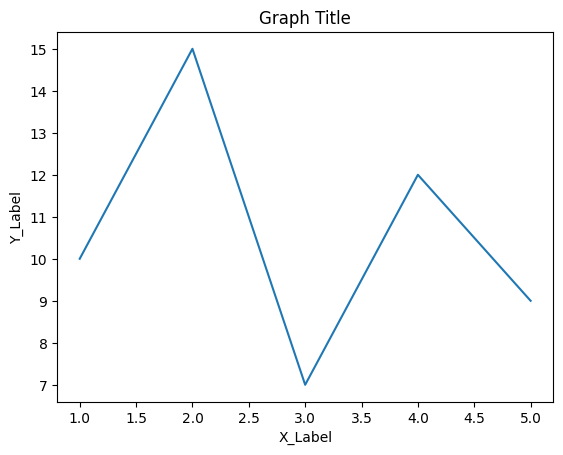

タイトルの追加:

グラフ全体に対するタイトルを追加できます。

plt.title('Graph Title')

グラフのタイトルは、plt.title()関数を使用して指定します。

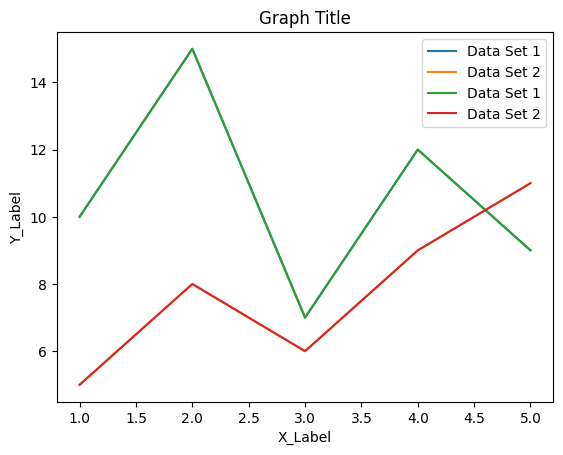

凡例の追加:

複数のデータセットがある場合、凡例はそれらのデータセットを区別するのに役立ちます。

plt.plot(x, y, label='データセット1')

plt.plot(x, [5, 8, 6, 9, 11], label='データセット2')

plt.legend()labelパラメータを使用して各データセットに名前を付け、plt.legend()関数で凡例を表示します。凡例は各データセットの名前を示し、グラフのどこに表示するかはMatplotlibによって自動的に決定されます。

以下はこれらのステップを組み合わせた例です。

import matplotlib.pyplot as plt

plt.plot(x, y, label='Data Set 1')

plt.plot(x, [5, 8, 6, 9, 11], label='Data Set 2')

plt.legend()

import matplotlib.pyplot as plt

x = [1, 2, 3, 4, 5]

y = [10, 15, 7, 12, 9]

plt.plot(x, y, label='Data Set 1')

plt.xlabel('X_Label')

plt.ylabel('Y_Label')

plt.title('Graph Title')

# もう一つのデータセット

plt.plot(x, [5, 8, 6, 9, 11], label='Data Set 2')

# 凡例を表示

plt.legend()

plt.show()

このコードを実行すると、折れ線グラフにX軸ラベル、Y軸ラベル、タイトル、凡例が追加されたグラフが表示されます。

Matplotlibを使用して作成したグラフを保存する方法を説明します。グラフを保存することは、後で再利用するため、報告書やプレゼンテーションに使用するために重要です。

Matplotlibでは、savefig()関数を使用してグラフをファイルに保存します。以下は、グラフを保存する手順です。

グラフを描画します。 まず、Matplotlibを使用してグラフを作成します。これは前の説明で説明した通りです。例えば、次のコードで折れ線グラフを描画します。

import matplotlib.pyplot as plt

x = [1, 2, 3, 4, 5]

y = [10, 15, 7, 12, 9]

plt.plot(x, y)

plt.xlabel('X_Label')

plt.ylabel('Y_Label')

plt.title('Graph Title')グラフをファイルに保存します。

savefig()関数を使用して、グラフを指定したファイル形式(通常はPNG、JPEG、PDFなど)で保存します。関数の第一引数にはファイル名を指定します。ファイル名には拡張子を含めることが重要です。

plt.savefig('グラフの保存先ファイル名.png')このコードを実行すると、現在のディレクトリに指定したファイル名でグラフが保存されます。例えば、’グラフの保存先ファイル名.png’という名前のPNGファイルが作成されます。

以下は完全な例です。

import matplotlib.pyplot as plt

x = [1, 2, 3, 4, 5]

y = [10, 15, 7, 12, 9]

plt.plot(x, y)

plt.xlabel('X_Label')

plt.ylabel('Y_Label')

plt.title('Graph Title')

# グラフをPNGファイルとして保存

plt.savefig('my_graph.png')

plt.show()

この例では、’my_graph.png’という名前のPNGファイルにグラフが保存されます。自分の用途に合わせてファイル名と保存形式を変更してください。

高校数学

位取り記数法

位取り記数法は、数を表現する方法の一つで、各桁が基数(通常は10進数または2進数)の累乗を表します。最も一般的な位取り記数法は10進法で、数字は0から9の範囲の記号で表されます。例えば、10進法での数「123」は、百の位(1)、十の位(2)、一の位(3)に分解されます。各位の値は、その位が基数の何乗であるかを示しています。

コンピュータでは、主に2進法が使用されます。2進法では、各桁が0または1の2つの値を取ります。例えば、2進法での数「1010」は、2の3乗(8)と2の1乗(2)を表します。これにより、コンピュータは電子回路のオンとオフ、またはビットの0と1で情報を表現します。

ビジネスの応用例

ビジネスの応用例としては、データベース内の大きな数字を効率的に格納するために、特定の基数に変換することがあります。たとえば、金融業界ではとても大きな金額や精密な計算を行う際に、位取り記数法を使用してデータを効率的に処理します。

Pythonコード

decimal_number = 1234

# 10進数を2進数に変換

binary_representation = bin(decimal_number)

print(f"10進数 {decimal_number} は2進数で {binary_representation} です。")

10進数 1234 は2進数で 0b10011010010 です。

基数変換

基数変換は、ある基数(進法)で表されている数を別の基数で表すプロセスです。通常、私たちは10進数を使用して数を表現しますが、コンピュータや特定のアプリケーションでは異なる基数が使用されることがあります。基数変換を行うことで、数を異なる基数で表現し直すことができます。

例えば、10進数の数を2進数や16進数に変換できます。2進数では0と1の2つの数字を使用し、16進数では0から9までの数字とAからFまでのアルファベットを使用します。これにより、同じ数を異なる基数で表現できます。

ビジネスの応用例

ビジネスの応用例としては、ハードウェア設計や低レベルのプログラミングで、データを異なる基数で処理する必要がある場合があります。また、ネットワークアドレスや色の表現など、特定のアプリケーションで異なる基数が使用されることもあります。

Pythonコード

decimal_number = 255

# 10進数を16進数に変換

hex_representation = hex(decimal_number)

print(f"10進数 {decimal_number} は16進数で {hex_representation} です。")

10進数 255 は16進数で 0xff です。

上記のPythonコードでは、10進数の数を16進数に変換しています。decimal_number変数に格納された10進数の数255は、hex()関数を使用して16進数に変換され、hex_representation変数に格納されます。その結果、10進数255は16進数で0xffと表されます。

2の補数と基数変換

2の補数は、負の整数を2進数で表現する方法です。この表現方法では、最も左のビット(最上位ビット)が符号ビットとして使用され、0は正の数を示し、1は負の数を示します。

たとえば、8ビットの2進数表現を考えてみましょう。通常、この場合、最も左のビットは符号ビットであり、0は正の数、1は負の数を示します。

- 正の整数3を2進数で表すと:00000011

- 負の整数-3を2の補数で表すと:11111101

2の補数を使用することで、正と負の数を同じ2進数表現で扱うことができます。この方法は、コンピュータ内で整数を表現する際に広く使用されています。また、2の補数を使用することで、加算と減算の操作が同じ回路で行えるため、コンピュータのハードウェア設計にも適しています。

ビジネスの応用例

コンピュータの算術演算で負の数を効率的に取り扱うために使用されます。

Pythonコード

def twos_complement(value, bits):

if value < 0:

value = (1 << bits) + value

return format(value, f'0{bits}b')

# 例: -5の8ビット2の補数を計算し、2進数表現に変換

result = twos_complement(-5, 8)

print(result)

11111011このコードでは、twos_complement 関数が2の補数を計算し、指定されたビット数の2進数表現に変換します。関数に負の値とビット数を渡すことで、負の値の2の補数を計算し、2進数文字列として返します。

実数を基数変換する

実数を基数変換するとは、実数を別の基数(通常は10進数から異なる基数)で表現することを意味します。このプロセスは、整数部と小数部を別々に変換し、それらを組み合わせて新しい基数の実数を得る方法です。

例えば、10進数から2進数への基数変換を考えてみましょう。整数部と小数部をそれぞれ2進数に変換し、最終的に結合します。

例:

- 整数部の10進数「12」を2進数に変換すると「1100」になります。

- 小数部の10進数「0.75」を2進数に変換すると「0.11」になります。

これらを組み合わせて、新しい基数(2進数)での実数「1100.11」が得られます。

ビジネスの応用例

ビジネスの応用例としては、特定の計算処理で異なる基数のデータを取り扱う必要がある場合があります。たとえば、コンピュータの内部処理では2進数が使用され、ネットワーク通信やデータ圧縮などのアプリケーションでは16進数が使用されることがあります。基数変換は、これらの異なる基数のデータを相互に変換するために使用されます。

Pythonコード

def float_to_binary(value, places=8):

integral_part = int(value)

fractional_part = value - integral_part

# 整数部の変換

integral_binary = bin(integral_part).split("b")[1]

fractional_binary = []

while places:

fractional_part *= 2

bit = int(fractional_part)

fractional_part -= bit

fractional_binary.append(str(bit))

places -= 1

return integral_binary + "." + "".join(fractional_binary)

# 例: 10.625の2進数表現(8ビット精度)

result = float_to_binary(10.625, places=8)

print(result)

1010.10100000

このコードでは、与えられた実数を整数部と小数部に分割し、それぞれを2進数に変換してから合成します。整数部は bin() 関数を使用して2進数文字列に変換し、小数部は指定された精度(ビット数)まで2進数に変換します。最終的に、整数部と小数部を連結して実数の2進数表現を得ることができます。

シフト演算で掛け算・割り算

シフト演算は、2進数での数値を左にシフト(左シフト)または右にシフト(右シフト)する操作です。これらの演算は、掛け算や割り算に相当します。

- 左シフト(<<): 左シフト演算は、数値を左に指定したビット数だけシフトします。これは、数値を2の累乗で掛ける操作として理解できます。例えば、4を2で左シフトすると、4 * 2^2 = 16 になります。

- 右シフト(>>): 右シフト演算は、数値を右に指定したビット数だけシフトします。これは、数値を2の累乗で割る操作として理解できます。例えば、4を2で右シフトすると、4 / 2^2 = 1 になります。

ビジネスの応用例

シフト演算は、高速な計算が必要なアプリケーションやリアルタイムシステムでの計算処理の最適化に使用されます。

- 組み込みシステム: 組み込みシステムやマイクロコントローラでは、リソースが限られているため、効率的な計算が必要です。シフト演算は、リソース制約のある環境での計算を高速化します。

- データ圧縮: データ圧縮アルゴリズム(例: ハフマン符号化)などでは、シフト演算がビット操作に使用され、データの圧縮および伸張が行われます。

- グラフィックスプログラミング: 3Dグラフィックスや画像処理において、シフト演算はピクセル操作や画像処理の最適化に使用されます。

- 通信プロトコル: ネットワーク通信や通信プロトコルにおいて、データのエンコードやデコードにシフト演算が使用され、高速なデータ転送が実現されます。

シフト演算は、ビットレベルの操作であり、効率的で高速な計算を可能にするため、さまざまなビジネス領域で活用されています。

Pythonコード

number = 4

# 掛け算

multiplier = 2 # 2を掛ける場合

multiplied = number << multiplier

# 割り算

divisor = 2 # 2で割る場合

divided = number >> divisor

print(f"{number}を{multiplier}で掛けると{multiplied}になります。")

print(f"{number}を{divisor}で割ると{divided}になります。")

4を2で掛けると16になります。

4を2で割ると1になります。コンピュータ特有のビット演算

ビット演算は、コンピュータにおいて整数をビット(0または1)単位で操作する演算です。主なビット演算には、以下の演算があります。

- AND演算: 対応するビットが両方とも1の場合に1を返し、それ以外の場合は0を返します。例えば、5(二進数では0101)と3(二進数では0011)のAND演算は、0001となります。

- OR演算: 対応するビットのどちらかが1の場合に1を返し、両方が0の場合は0を返します。例えば、5と3のOR演算は、0111となります。

- XOR演算: 対応するビットが異なる場合に1を返し、同じ場合は0を返します。例えば、5と3のXOR演算は、0110となります。

- NOT演算: 各ビットを反転させます。1は0に、0は1に変換されます。例えば、5のNOT演算は、1010となります。

ビット演算は、コンピュータの低レベルの操作で広く使用され、ビット単位のデータ処理に適しています。ビット演算を使用することで、データのマスク、ビット単位の制御、暗号化、ハッシュ関数の計算、データの圧縮など、さまざまなアルゴリズムが効率的に実装できます。

ビジネスの応用例

暗号化、ハッシュ関数の計算、データの圧縮などのアルゴリズムにおいて、ビット演算は効率的な計算を実現します。

- セキュリティ: 暗号化アルゴリズムやセキュリティプロトコルにおいて、ビット演算はキーマスク、データの暗号化、デジタル署名などのセキュリティ機能に使用されます。

- データ処理: ビット演算はデータのフィルタリング、変換、マスク処理に使用され、データベース、データ処理、通信プロトコルなどの分野で役立ちます。

- 組み込みシステム: マイクロコントローラや組み込みシステムでは、ビット演算が低レベルの制御やデバイス制御に使用され、リソース効率を改善させます。

Pythonコード

a = 5 # 0101 in binary

b = 3 # 0011 in binary

# AND演算

result_and = a & b

# OR演算

result_or = a | b

# XOR演算

result_xor = a ^ b

# NOT演算

result_not_a = ~a

# 結果の出力

print(f"{a} & {b} = {result_and} (AND operation)")

print(f"{a} | {b} = {result_or} (OR operation)")

print(f"{a} ^ {b} = {result_xor} (XOR operation)")

print(f"~{a} = {result_not_a} (NOT operation)")

5 & 3 = 1 (AND operation)

5 | 3 = 7 (OR operation)

5 ^ 3 = 6 (XOR operation)

~5 = -6 (NOT operation)このコードは、ビット単位のAND、OR、XOR、NOT演算を実行します。ビット演算は、整数を2進数表現として扱い、各ビットごとに演算を行います。ビット演算は、整数を2進数表現として扱い、ビットごとに操作を行うため、高度なビット制御を実現します。

コンピュータ特有の論理演算

論理演算は、コンピュータにおいて真偽値(TrueまたはFalse)を操作する演算です。主な論理演算には、以下の演算があります。

- AND演算: 両方の条件がTrueの場合に結果がTrueとなり、それ以外の場合はFalseを返します。例えば、xがTrueかつyがTrueの場合、x AND yはTrueです。

- OR演算: どちらかの条件がTrueの場合に結果がTrueとなり、両方がFalseの場合はFalseを返します。例えば、xがTrueまたはyがTrueの場合、x OR yはTrueです。

- NOT演算: 条件を反転させ、TrueはFalseに、FalseはTrueに変換します。例えば、xがTrueの場合、NOT xはFalseです。

論理演算は、条件分岐やフィルタリング、プログラムの制御構造においてとても重要です。真偽値を組み合わせて複雑な条件を評価し、プログラムの振る舞いを制御するのに役立ちます。

ビジネスの応用例

条件分岐やフィルタリング、データの検証などのプログラムの制御構造に使用されます。

- 条件分岐: プログラム内で特定の条件に基づいて異なるアクションを実行する場合、論理演算は条件式の評価に使用されます。

- データのフィルタリング: データセットから特定の条件を満たすデータを選択するために、論理演算はデータのフィルタリングに使用されます。

- セキュリティ: アクセス制御や認証システムにおいて、論理演算はユーザーの許可や認証の評価に使用されます。

Pythonコード

x = True

y = False

# AND演算

result_and = x and y

# OR演算

result_or = x or y

# NOT演算

result_not_x = not x

# 結果の出力

print(f"{x} and {y} = {result_and} (AND operation)")

print(f"{x} or {y} = {result_or} (OR operation)")

print(f"not {x} = {result_not_x} (NOT operation)")

True and False = False (AND operation)

True or False = True (OR operation)

not True = False (NOT operation)このコードは、論理演算(AND、OR、NOT)を実行します。論理演算は、ブール値(TrueまたはFalse)に対して行われ、論理的な条件を評価します。論理演算は真偽値を組み合わせて複雑な条件を評価し、プログラムの振る舞いを制御するのに役立ちます。

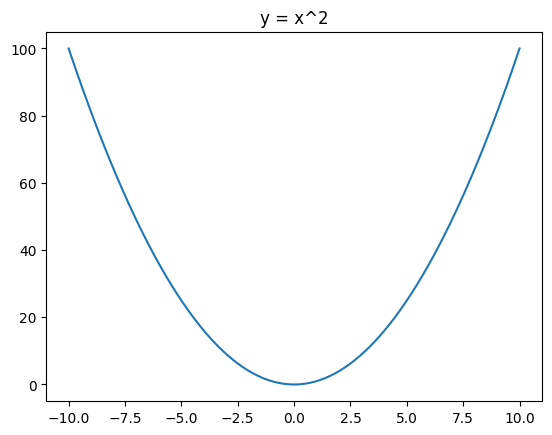

方程式で図形を描く

数学的な方程式を使用して、2次元や3次元の図形を描画できます。

ビジネスの応用例

製品の設計や建築、CG映像の制作など、多岐にわたる分野で図形の描画は利用されます。

Pythonコード

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(-10, 10, 400)

y = x**2

plt.plot(x, y)

plt.title('y = x^2')

plt.show()

このコードは関数 y = x^2 のグラフを描画し、その形状を可視化します。グラフはMatplotlibを使用して表示され、x軸とy軸に対応する数値が表示されます。

方程式からグラフを描く

方程式を元に、変数の値の変化に応じた関数の値をグラフとして表現します。

ビジネスの応用例

データ解析やトレンドの確認、科学技術計算の結果の視覚化に利用されます。

Pythonコード

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(-10, 10, 400)

y = np.sin(x)

plt.plot(x, y)

plt.title('y = sin(x)')

plt.show()

このコードは関数 y = sin(x) のグラフを描画し、正弦関数の振る舞いを可視化します。グラフはMatplotlibを使用して表示され、x軸とy軸に対応する数値が表示されます。

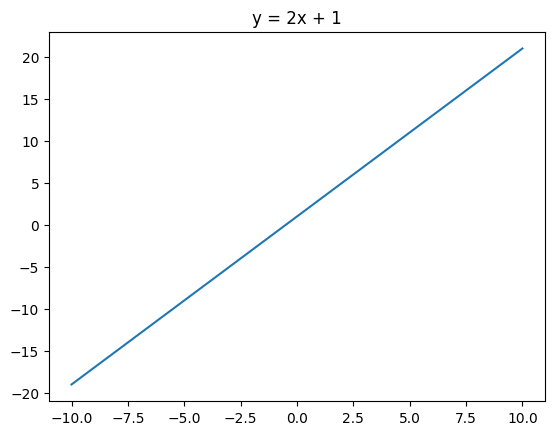

直線の方程式を描く

直線の方程式は、一次方程式\(y = mx + c\) の形で表され、これをグラフとして描画できます。

ビジネスの応用例

売上のトレンドや株価の動向などを表す際に、直線の方程式が利用されることがあります。

Pythonコード

m = 2

c = 1

x = np.linspace(-10, 10, 400)

y = m*x + c

plt.plot(x, y)

plt.title('y = 2x + 1')

plt.show()

このコードは線形関数 y = 2x + 1 のグラフを描画し、直線の傾きとy切片を示す直線を可視化します。グラフはMatplotlibを使用して表示され、x軸とy軸に対応する数値が表示されます。

比例式と三角比

比例式:

比例式は、2つの量が一定の比率で変化する関係を示す数学的な式です。この式は一般的に以下のように表現されます。

\[y = kx\]

ここで、\(y\) は1つの量、\(x\) はもう一つの量、\(k\) は比例定数です。この式は、\(x\) が変化すると\(y\) も比例して変化します。例えば、速度と時間の関係、価格と数量の関係などが比例式で表現されます。

三角比:

三角比は、三角形の辺や角度に関連する数学的な比率です。主要な三角比には以下の3つがあります。

- 正弦 (sin): 正弦は、ある角度の対向辺の長さを斜辺の長さで割った値です。正弦は次のように表現されます。 \[ \sin(\theta) = \frac{\text{対向辺の長さ}}{\text{斜辺の長さ}} \]

- 余弦 (cos): 余弦は、ある角度の隣接辺の長さを斜辺の長さで割った値です。余弦は次のように表現されます。 \[ \cos(\theta) = \frac{\text{隣接辺の長さ}}{\text{斜辺の長さ}} \]

- 接線 (tan): 接線は、ある角度の対向辺の長さを隣接辺の長さで割った値です。接線は次のように表現されます。 \[ \tan(\theta) = \frac{\text{対向辺の長さ}}{\text{隣接辺の長さ}} \]

ビジネスの応用例

建築や設計分野での三角形の形状や角度の計算、物流の最短経路計算などに使用されます。

- 建築・設計: 三角比は、建物や構造物の設計において角度や三角形の形状を計算するのに使用されます。例えば、屋根の勾配やトラス構造の計算に応用されます。

- 物流: 物流業界では、最短経路を計算する際に三角比を使用し、距離や方向の計算を行います。これにより、輸送コストを最適化できます。

Pythonコード

import math

# 与えられた角度

angle = 30 # degree

# 角度をラジアンに変換

angle_rad = math.radians(angle)

# sin、cos、tanの計算

sin_val = math.sin(angle_rad)

cos_val = math.cos(angle_rad)

tan_val = math.tan(angle_rad)

# 結果の表示

print(f"角度: {angle} 度")

print(f"sin({angle}°) = {sin_val:.2f}") # 結果を小数点以下2桁まで表示

print(f"cos({angle}°) = {cos_val:.2f}")

print(f"tan({angle}°) = {tan_val:.2f}")

角度: 30 度

sin(30°) = 0.50

cos(30°) = 0.87

tan(30°) = 0.58このコードは、与えられた角度(30度)に対して、sin、cos、tanの三角関数の値を計算し、その結果を小数点以下2桁まで表示しています。これらの三角関数は、角度と辺の長さの関係を数学的に表現するのに役立ちます。

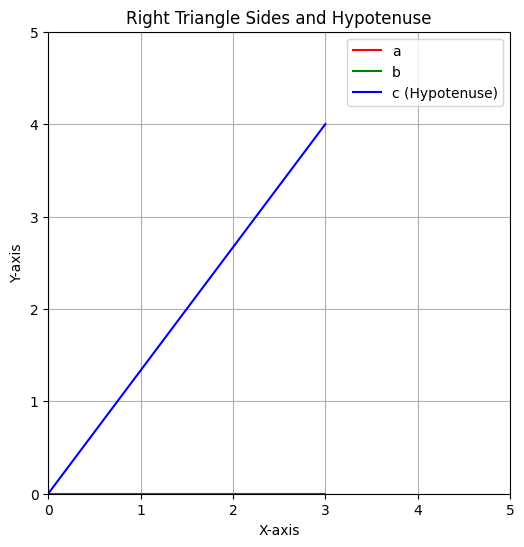

三平方の定理

三平方の定理は、直角三角形において、直角を挟む2辺の長さの2乗の和が、斜辺の長さの2乗と等しいという数学的な法則です。これは直角三角形における基本的な関係式であり、ピタゴラスの定理とも呼ばれます。具体的には、以下の式で表されます。

\[a^2 + b^2 = c^2\]

ここで、\(a\) と \(b\) は直角を挟む2つの辺の長さを表し、\(c\) は斜辺の長さを表します。

ビジネスの応用例

土地の測量や建築物の設計時に、距離や高さを計算するために使用されます。

- 土地測量: 三平方の定理は、土地測量において、不動産の境界や地形の計測に使用されます。直角三角形の原理を応用して、距離や面積を正確に計算するのに役立ちます。

- 建築設計: 建築設計プロジェクトでは、建物の設計や配置において、三平方の定理を使用して正確な寸法と位置を計算します。

Pythonコード

import math

import matplotlib.pyplot as plt

a = 3

b = 4

c = math.sqrt(a**2 + b**2)

# Graph settings

plt.figure(figsize=(6, 6))

plt.plot([0, a], [0, 0], 'r', label='a')

plt.plot([0, 0], [0, b], 'g', label='b')

plt.plot([0, a], [0, b], 'b', label='c (Hypotenuse)')

plt.xlim(0, max(a, b) + 1)

plt.ylim(0, max(a, b) + 1)

plt.gca().set_aspect('equal', adjustable='box')

plt.legend()

plt.xlabel('X-axis')

plt.ylabel('Y-axis')

plt.title('Right Triangle Sides and Hypotenuse')

plt.grid(True)

# Display the result

print(f"斜辺の長さ: {c:.2f}")

# Show the graph

plt.show()

斜辺の長さ: 5.0

上記のPythonコード例では、直角三角形の2辺 \(a\) と \(b\) の長さを与えて、三平方の定理を用いて斜辺 \(c\) の長さを計算し、それをグラフで視覚化しています。この定理は、実世界の問題において距離や寸法を求めるための重要なツールです。

ベクトルの演算

ベクトルの演算:

ベクトルは、大きさ(長さ)と向きを持つ数学的な概念です。ベクトルの演算には以下の3つの主要な操作があります。

- 加算 (Vector Addition): 2つのベクトルを足し合わせる操作です。ベクトルの各成分を対応する成分ごとに足し合わせます。

- 減算 (Vector Subtraction): 2つのベクトルを引き算する操作です。ベクトルの各成分を対応する成分ごとに引き算します。

- スカラー倍 (Scalar Multiplication): ベクトルにスカラー(実数)を掛ける操作です。ベクトルの各成分にスカラーを掛けます。

ビジネスの応用例

物理や工学の分野で、力や速度などのベクトル量を計算する際に使用されます。

- 物理学: 物体の速度、加速度、力などのベクトル量を計算するために使用されます。たとえば、自動車の速度ベクトルと風速ベクトルを合成して、風を受ける車の速度を計算することがあります。

- 工学: 構造物の応力解析や電気回路の計算など、さまざまな工学分野でベクトル演算が必要です。たとえば、橋の支持構造のベクトル力学を使用して設計することがあります。

Pythonコード

import numpy as np

vector_a = np.array([1, 2])

vector_b = np.array([3, 4])

print(vector_a + vector_b)

print(vector_a - vector_b)

print(2 * vector_a)[4 6]

[-2 -2]

[2 4]上記のPythonコード例では、2つのベクトル vector_a と vector_b を加算、減算し、スカラー倍を計算しています。これらの演算は、ベクトルを使用して物理的な量やデータを効率的に処理するためにとても役立ちます。

ベクトル方程式

ベクトル方程式は、ベクトルを使用して方程式を表現する方法です。通常、ベクトル方程式は以下の形式で表されます。

\[ \mathbf{v} = \mathbf{a} + t \cdot \mathbf{d} \]

ここで、各記号の意味は次のとおりです。

- \( \mathbf{v} \): 位置ベクトル(点を表すベクトル)

- \( \mathbf{a} \): 始点ベクトル(直線や曲線の始点を表すベクトル)

- \( t \): パラメータ(スカラー値)

- \( \mathbf{d} \): 方向ベクトル(直線や曲線の進行方向を表すベクトル)

この方程式は、\( t \) の値を変えることで、直線や曲線上の異なる点を表現できます。

ビジネスの応用例

3D モデリングやCGの制作、航空機の飛行経路の設計などに使用されます。

- 3D モデリング: 3Dオブジェクトの位置や移動を表現するためにベクトル方程式が使用されます。たとえば、アニメーションソフトウェアでキャラクターの動きを制御するのに役立ちます。

- 航空機の飛行経路設計: 航空機の飛行経路を計画する際に、出発地点から目的地点までの航空機の位置をベクトル方程式を使用して表現します。

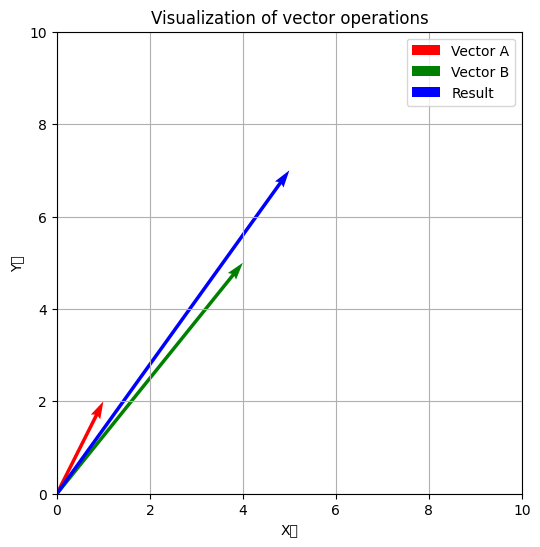

Pythonコード

import matplotlib.pyplot as plt

# ベクトルの定義

vector_a = np.array([1, 2])

vector_b = np.array([4, 5])

# プロット

plt.figure(figsize=(6, 6))

plt.quiver(0, 0, vector_a[0], vector_a[1], angles='xy', scale_units='xy', scale=1, color='r', label='Vector A')

plt.quiver(0, 0, vector_b[0], vector_b[1], angles='xy', scale_units='xy', scale=1, color='g', label='Vector B')

# ベクトルの加算結果を描画

result = vector_a + vector_b

plt.quiver(0, 0, result[0], result[1], angles='xy', scale_units='xy', scale=1, color='b', label='Result')

plt.xlim(0, 10)

plt.ylim(0, 10)

plt.xlabel('X軸')

plt.ylabel('Y軸')

plt.legend()

plt.grid(True)

plt.title('Visualization of vector operations')

plt.show()

上記のPythonコード例では、ベクトルAとベクトルBを視覚的に表現しています。これらのベクトルを加算することで、新しいベクトル(”Result”として表示)を生成し、その結果をプロットしています。ベクトル方程式は、ベクトルの位置や移動を効果的に扱うために使用されます。

ベクトルの内積

ベクトルの内積は、2つのベクトルの成分ごとの積を合計する操作です。具体的には、ベクトル \( \mathbf{a} \) とベクトル \( \mathbf{b} \) の内積は以下のように計算されます。

\[ \mathbf{a} \cdot \mathbf{b} = |\mathbf{a}| |\mathbf{b}| \cos \theta \]

ここで、各記号の意味は次のとおりです。

- \( \mathbf{a} \cdot \mathbf{b} \): ベクトル \( \mathbf{a} \) と \( \mathbf{b} \) の内積

- \( |\mathbf{a}| \): ベクトル \( \mathbf{a} \) の大きさ(ノルム)

- \( |\mathbf{b}| \): ベクトル \( \mathbf{b} \) の大きさ(ノルム)

- \( \theta \): ベクトル \( \mathbf{a} \) と \( \mathbf{b} \) のなす角(ラジアン)

ベクトルの内積は、2つのベクトルがどれだけ同じ方向に向いているかを示し、ベクトル同士の類似性や関連性を評価するのに役立ちます。内積が正の場合、ベクトルは似た方向に向いており、負の場合は逆向きに向いています。また、内積がゼロの場合、ベクトルは直交しています。

ビジネスの応用例

機械学習のアルゴリズムや、データの類似度を計算する際に使用されます。

- 機械学習: 特徴ベクトル同士の内積を計算して、類似性を評価し、クラスタリングや分類などのタスクに使用します。

- データベース検索: 文書ベクトルの内積を計算して、文書の類似性を評価し、情報検索に使用します。

Pythonコード

vector_a = np.array([1, 2])

vector_b = np.array([3, 4])

dot_product = np.dot(vector_a, vector_b)

print(dot_product)11上記のPythonコード例では、ベクトル \( \mathbf{a} \) と \( \mathbf{b} \) の内積(ドット積)を計算し、その結果を表示しています。ベクトルの内積は、ベクトル同士の関係性を数値的に捉えるための重要な操作です。

ベクトルの外積

ベクトルの外積は、2つのベクトルから新しいベクトルを生成する操作で、その結果のベクトルは元の2つのベクトルに垂直です。ベクトル \( \mathbf{a} \) と \( \mathbf{b} \) の外積を \( \mathbf{c} \) と表現すると、次のようになります。

\[ \mathbf{c} = \mathbf{a} \times \mathbf{b} \]

外積の結果のベクトル \( \mathbf{c} \) の大きさや向きは、\( \mathbf{a} \) と \( \mathbf{b} \) の間の平面に依存します。外積は、ベクトル間の「回転」や「垂直性」を評価するのに役立ちます。

ビジネスの応用例

物理学や工学の分野で、特に電磁気学や力のモーメントの計算に使用されます。

- 物理学: 電磁気学や力学の問題において、モーメントやトルクの計算に使用されます。

- 工学: 機械工学や材料工学において、応力とひずみの関係を理解し、設計を行う際に使用されます。

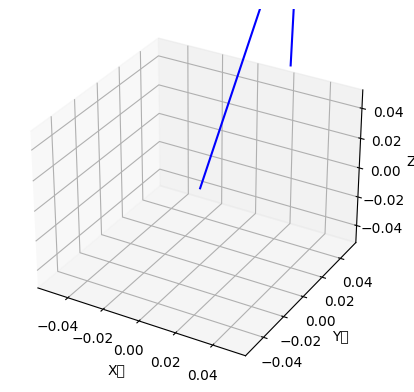

Pythonコード

import numpy as np

import matplotlib.pyplot as plt

from mpl_toolkits.mplot3d import Axes3D

vector_a = np.array([1, 2, 3])

vector_b = np.array([4, 5, 6])

cross_product = np.cross(vector_a, vector_b)

# 3Dグラフの設定

fig = plt.figure()

ax = fig.add_subplot(111, projection='3d')

# 原点から法線ベクトルを描画

ax.quiver(0, 0, 0, cross_product[0], cross_product[1], cross_product[2], color='b')

# 軸ラベル

ax.set_xlabel('X軸')

ax.set_ylabel('Y軸')

ax.set_zlabel('Z軸')

plt.show()

上記のPythonコード例では、ベクトル \( \mathbf{a} \) と \( \mathbf{b} \) の外積を計算し、その結果のベクトルを3Dグラフで表示しています。外積の結果は、元の2つのベクトルが張る平面に垂直であり、その向きや大きさは2つのベクトルの相対的な配置に依存します。外積は、ベクトルの幾何学的な特性を解析する際に重要なツールです。

行列とは?

行列は、数や数式を矩形状に配置したものです。行と列からなり、通常、数値や変数が格納されています。行列は数学の多くの分野で利用され、特に線形代数において重要な役割を果たします。

行列は以下のように表現されます。

\[ A = \begin{bmatrix}

a_{11} & a_{12} & \ldots & a_{1n} \

a_{21} & a_{22} & \ldots & a_{2n} \

\vdots & \vdots & \ddots & \vdots \

a_{m1} & a_{m2} & \ldots & a_{mn}

\end{bmatrix} \]

ここで、\( a_{ij} \) は行列内の各要素を表します。行列は行と列のインデックスによって参照され、\( m \) は行の数、\( n \) は列の数です。

ビジネスの応用例

機械学習やディープラーニングのアルゴリズムの中核に行列計算が存在します。また、金融のリスク評価や、データの圧縮、画像処理など、多岐にわたる分野で活用されます。

- 機械学習とディープラーニング: ニューラルネットワークの重み、データの表現、特徴量の変換など、多くの機械学習アルゴリズムで行列計算が使用されます。

- 金融: リスク評価モデルや資産ポートフォリオの最適化に行列計算が適用されます。

- データ分析: データセットの処理、データの圧縮、主成分分析など、データ分析の多くの手法で行列が利用されます。

Pythonコード

import numpy as np

matrix_a = np.array([[1, 2], [3, 4]])

print(matrix_a)[[1 2]

[3 4]]上記のPythonコード例では、NumPyライブラリを使用して2×2の行列 matrix_a を作成し、その内容を表示しています。行列はデータを整理し、さまざまな数学的操作を行うための強力なツールです。

行列の演算

行列の演算は、数学的な操作を行うための方法です。主に加算、減算、乗算の3つの基本的な演算があります。これらの演算は、行列の要素同士を操作する方法です。

- 加算(Summation):

行列の加算は、対応する要素同士を足し合わせる操作です。行列Aと行列Bがある場合、それぞれの要素を足し合わせた新しい行列を得ることができます。 例えば、以下のコードでは、行列Aと行列Bを加算して、sum_matrixという新しい行列を得ています。

sum_matrix = matrix_a + matrix_b結果は次のようになります。

Sum:

[[3 2]

[3 6]]- 乗算(Multiplication):

行列の乗算は、特定のルールに基づいて行われる操作で、通常の数値の乗算とは異なります。行列Aと行列Bの乗算は、行列Aの行と行列Bの列を組み合わせて新しい行列を作成します。 以下のコードでは、行列Aと行列Bを乗算して、product_matrixという新しい行列を得ています。

product_matrix = np.dot(matrix_a, matrix_b)結果は次のようになります。

Product:

[[2 4]

[6 8]]ビジネスの応用例

ビジネスの応用例としては、データベースのクエリ処理や、グラフ理論の問題、最適化問題の解法など、さまざまな場面で行列の演算が必要です。例えば、データベースクエリでは、多次元データを扱う際に行列を使用してクエリの結果を計算したり、最適化問題では行列演算を使用して最適な解を見つけたりします。

Pythonコード

matrix_b = np.array([[2, 0], [0, 2]])

sum_matrix = matrix_a + matrix_b

product_matrix = np.dot(matrix_a, matrix_b)

print("Sum:")

print(sum_matrix)

print("Product:")

print(product_matrix)Sum:

[[3 2]

[3 6]]

Product:

[[2 4]

[6 8]]Pythonコードの例では、NumPyライブラリを使用して行列演算を実行しています。行列の加算は+演算子を使用し、行列の乗算はnp.dot()関数を使用しています。このようなコードを使って、行列演算を実行できます。

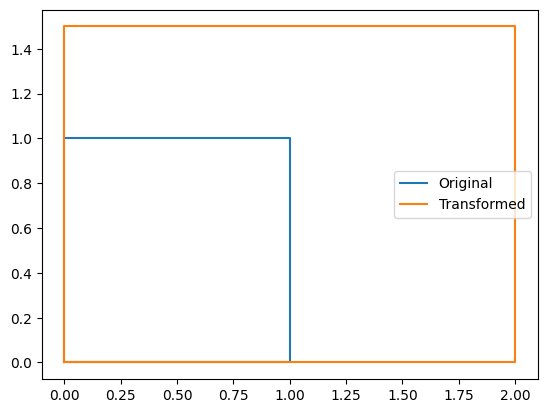

図形の一次変換

図形の一次変換は、図形を移動、回転、拡大縮小などの変換を行うことを指します。この変換は、通常行列を使用して表現されます。

- 移動、回転、拡大縮小:

- 移動(Translation): 図形を平行移動させます。つまり、図形内のすべての点を同じ距離と方向に移動させます。たとえば、図形を右に2単位、上に3単位移動させることができます。

- 回転(Rotation): 図形を中心を軸に回転させます。図形の各点が中心を中心に一定の角度だけ回転します。

- 拡大縮小(Scaling): 図形を大きくしたり小さくしたりします。各点の座標をスケールファクターによって変更します。

- 行列を用いた表現:

これらの一次変換は、行列を使用して簡潔に表現できます。行列は、図形内の各点の座標に変換を適用するのに役立ちます。行列をかけることで、一度に多くの点に対して変換を適用できます。

ビジネスの応用例

グラフィックデザインやゲーム開発、映像制作などの分野で、物体やキャラクターの位置や姿勢を調整する際に一次変換が用いられます。

- グラフィックデザイン: 画像や図形の位置を調整し、アニメーションやエフェクトを作成するために使用されます。

- ゲーム開発: ゲーム内のキャラクターやオブジェクトの動きや姿勢を制御するために使用されます。

- 映像制作: 特殊効果やアニメーションの作成に使用され、映画やアニメーションの制作において重要な役割を果たします。

Pythonコード

import matplotlib.pyplot as plt

# Original shape

x = [0, 1, 1, 0, 0]

y = [0, 0, 1, 1, 0]

plt.plot(x, y, label="Original")

# Transformation matrix

transformation = np.array([[2, 0], [0, 1.5]])

transformed = np.dot(transformation, [x, y])

plt.plot(transformed[0], transformed[1], label="Transformed")

plt.legend()

plt.show()

上記Pythonコードは、一次変換の一例です。matplotlib.pyplotを使用して、元の図形と変換後の図形をプロットしています。変換は行列transformationを使用して行われ、元の図形の座標を変換し、変換後の座標をプロットしています。このようにして、図形の一次変換を視覚的に表現できます。

集合とは?

集合とは、異なる要素が重複せず、一度だけ含まれる要素のまとまりを表す数学的な概念です。集合は、その中に含まれる要素を順序なしで持ち、要素が重複しないことが特徴です。集合は、日常的な問題解決や論理的思考において、要素のグループ化と集合間の関係を表現するのに役立ちます。

特徴:

- 重複しない要素: 集合内の要素は一度だけ含まれ、同じ要素が重複しません。たとえば、{1, 2, 3, 4, 5} は集合であり、同じ要素が複数回含まれることはありません。

- 順序なし: 集合内の要素は順序を持たず、要素の順序が変わっても同じ集合です。つまり、{1, 2, 3} と {3, 2, 1} は同じ集合です。

ビジネスの応用例

データベースの操作、特にSQLのクエリでの集合演算や、マーケティングのターゲットセグメントの選定などで集合の考え方が活用されます。

集合の考え方は、ビジネスやデータ処理のさまざまな分野で役立ちます。

- データベース操作: データベースのクエリで集合演算を使用して、データの絞り込みや結合を行います。SQLクエリにおけるJOIN操作やUNION操作などが集合演算の一例です。

- マーケティング: マーケティングでは、ターゲットセグメントの選定や顧客のセグメンテーションに集合の考え方を応用します。たとえば、特定の商品を購入した顧客の集合を特定し、それに基づいてマーケティング戦略を立案できます。

Pythonコード

set_a = {1, 2, 3, 4}

set_b = {3, 4, 5, 6}

union_set = set_a | set_b

intersection_set = set_a & set_b

print(f"Union: {union_set}")

print(f"Intersection: {intersection_set}")Union: {1, 2, 3, 4, 5, 6}

Intersection: {3, 4}上記のPythonコードでは、Pythonの集合を操作しています。

set_aとset_bという2つの集合を定義しています。union_set変数には、2つの集合の和集合(両方の集合の要素を含む集合)が格納されます。intersection_set変数には、2つの集合の積集合(両方の集合に共通する要素からなる集合)が格納されます。

コードを実行すると、和集合と積集合が計算され、それぞれの結果が表示されます。和集合には2つの集合のすべての要素が含まれ、積集合には共通する要素だけが含まれます。

Union: {1, 2, 3, 4, 5, 6}

Intersection: {3, 4}これにより、集合演算がどのように機能し、集合の要素が操作されるかが示されています。

順列と組み合わせ

順列と組み合わせは、数学的な概念で、異なるアイテムの集合から特定の要件を満たすアイテムのグループを作成する方法を計算するために使用されます。

順列(Permutations):

順列は、n個のアイテムの集合からr個のアイテムを選び、そのアイテムを異なる順番で並べる方法の数を表します。順列では順序が重要です。つまり、選んだアイテムを異なる順番で並べることで異なる順列が得られます。

例: A、B、Cという3つのアイテムから2つのアイテムを選んで順列を計算すると、 (‘A’, ‘B’)、(‘A’, ‘C’)、(‘B’, ‘A’)、(‘B’, ‘C’)、(‘C’, ‘A’)、(‘C’, ‘B’) の6つの順列が得られます。

組み合わせ(Combinations):

組み合わせは、n個のアイテムの集合からr個のアイテムを選び、順序を考慮せずにグループを作成する方法の数を表します。組み合わせでは、選んだアイテムの順序は考慮されません。つまり、同じアイテムの組み合わせが異なる順序で表示されることはありません。

例: A、B、Cという3つのアイテムから2つのアイテムを選んで組み合わせを計算すると、 (‘A’, ‘B’) と (‘A’, ‘C’)、(‘B’, ‘C’) の3つの組み合わせが得られます。

ビジネスの応用例

商品の並べ方の最適化や、マーケティングキャンペーンの組み合わせの検討、株のポートフォリオの組み合わせ選定などで順列や組み合わせの考え方が利用されます。

順列と組み合わせの考え方は、ビジネスにおいてさまざまな場面で役立ちます。

- 商品の並べ方の最適化: 商品陳列の最適な順序を決定するために順列を使用できます。特定の商品をどのような順序で陳列するかが、売上や顧客の満足度に影響を与えることがあります。

- マーケティングキャンペーンの組み合わせ: マーケティングキャンペーンの要素(広告、プロモーション、コンテンツなど)を組み合わせて最適なキャンペーン戦略を決定するために組み合わせを使用できます。

- 株のポートフォリオの組み合わせ選定: 株式投資の際に、異なる株式からポートフォリオを構築するための最適な組み合わせを計算するのに組み合わせが役立ちます。

Pythonコード

import itertools

items = ['A', 'B', 'C']

permutations = list(itertools.permutations(items, 2))

combinations = list(itertools.combinations(items, 2))

print(f"Permutations: {permutations}")

print(f"Combinations: {combinations}")Permutations: [('A', 'B'), ('A', 'C'), ('B', 'A'), ('B', 'C'), ('C', 'A'), ('C', 'B')]

Combinations: [('A', 'B'), ('A', 'C'), ('B', 'C')]上記のPythonコードでは、Pythonの itertools ライブラリを使用して順列と組み合わせを計算しています。

itemsリストには、(‘A’, ‘B’, ‘C’) という3つのアイテムが含まれています。itertools.permutations()関数を使用して、アイテムから2つの順列を計算し、permutationsリストに格納します。itertools.combinations()関数を使用して、アイテムから2つの組み合わせを計算し、combinationsリストに格納します。

コードを実行すると、計算された順列と組み合わせが表示されます。

Permutations: [('A', 'B'), ('A', 'C'), ('B', 'A'), ('B', 'C'), ('C', 'A'), ('C', 'B')]

Combinations: [('A', 'B'), ('A', 'C'), ('B', 'C')]このようにして、順列と組み合わせが計算され、異なる順序や順不同での結果が得られます。

数学的確率と統計的確率

数学的確率と統計的確率は、確率の考え方を異なる方法で表現する方法です。

数学的確率:

数学的確率は、ある事象が起こる確率を数学的に定義する方法です。これは、理論的なモデルや公式を使用して確率を計算します。たとえば、公正なサイコロを振る場合、各目の出る確率は1/6(約0.1667)です。この確率は、サイコロの各面が均等に出ることが数学的に確定的に証明されたものです。

統計的確率:

統計的確率は、実際のデータや観測に基づいて事象の確率を推定する方法です。統計的確率は、実際の試行や観測結果から確率を導き出します。たとえば、サイコロを1000回振って、3が出た回数を数えてその割合を計算することで、3が出る確率を推定します。

ビジネスの応用例

商品の売上予測、株価の動きの予測、広告のクリック確率の予測など、多岐にわたる分野で確率の考え方が活用されます。

確率の考え方はビジネスにおいて多くの分野で利用されます。

- 商品の売上予測: 過去の売上データをもとに、将来の売上を統計的確率を用いて予測します。

- 株価の動きの予測: 過去の株価データや市場動向から、将来の株価動向を統計的確率を用いて予測します。

- 広告のクリック確率の予測: ウェブ広告のクリック率を統計的確率を用いて推定し、広告キャンペーンを最適化します。

Pythonコード

# Example: Rolling a die

import random

# Mathematical probability

math_prob = 1/6

# Statistical probability (simulating 1000 rolls)

rolls = [random.randint(1, 6) for _ in range(1000)]

stat_prob = rolls.count(3) / 1000

print(f"Mathematical Probability: {math_prob}")

print(f"Statistical Probability: {stat_prob}")Mathematical Probability: 0.16666666666666666

Statistical Probability: 0.159上記のPythonコードは、数学的確率と統計的確率の比較を示す例です。

math_prob変数には、数学的確率が1/6(約0.1667)が格納されています。これは、サイコロを振ったときに3の目が出る確率です。stat_prob変数には、統計的確率が1000回のサイコロ振りの結果から計算された確率が格納されています。この確率は、3が出た回数をサイコロ振りの総回数で割ったものです。

コードを実行すると、数学的確率と統計的確率が表示され、統計的確率は数学的確率に近い値であることが示されます。

Mathematical Probability: 0.16666666666666666

Statistical Probability: 0.159この例では、サイコロを1000回振って統計的確率を推定しましたが、試行回数を増やすことでより正確な結果を得ることができます。統計的確率は、実際のデータに基づいて不確実性を扱うためにとても有用です。

積の法則と和の法則

積の法則と和の法則は、確率論において重要な法則です。

- 積の法則(Product Rule):

- 積の法則は、2つの独立な事象AとBが同時に起こる場合の方法の総数を求める法則です。独立な事象とは、一つの事象が他の事象に影響を与えないことを意味します。積の法則では、事象Aと事象Bが同時に起こる確率を計算するために、それぞれの事象の起こる方法の数を掛け合わせます。

- 例1: おにぎりとドリンク 弁当屋に行くと、3種類のおにぎり(しゃけ、たらこ、梅)と2種類のドリンク(お茶、ジュース)が売られています。ランチに1つのおにぎりと1つのドリンクを選ぶとすると、選べる組み合わせは何通りあるでしょうか? 積の法則を使うと、おにぎりの選び方3通り × ドリンクの選び方2通り = 6通りの組み合わせがあります。

- 例2: 服と靴 クローゼットには、2種類のシャツ(赤、青)と3種類の靴(スニーカー、ブーツ、サンダル)があります。今日のコーディネートとしてシャツ1枚と靴1足を選ぶ場合、何通りの組み合わせが考えられるでしょうか? 積の法則を使用すると、シャツの選び方2通り × 靴の選び方3通り = 6通りの組み合わせが考えられます。

- 和の法則(Sum Rule):

- 和の法則は、2つの排他的な事象AとBのいずれかが起こる場合の方法の総数を求める法則です。排他的な事象とは、同時には起こりえない事象のことを指します。和の法則では、事象Aまたは事象Bが起こる確率を計算するために、それぞれの事象の起こる方法の数を足し合わせます。

- 例1: 宝箱とキー 2つの部屋があり、1つ目の部屋には2つの宝箱、2つ目の部屋には3つの宝箱があります。部屋を1つ選び、その中の宝箱を1つ開けることができるとします。宝箱を1つ開ける選択肢は何通りあるでしょうか? 和の法則により、1つ目の部屋の宝箱の選び方2通り + 2つ目の部屋の宝箱の選び方3通り = 5通りの選択肢が考えられます。

- 例2: アイスクリーム アイスクリーム屋には、バニラとチョコレートの2つのフレーバーがあります。そして、その隣の別のアイスクリーム屋には、ストロベリーとマンゴーの2つのフレーバーがあります。1つの店舗から1つのフレーバーを選ぶ場合、選べるフレーバーは何通りあるでしょうか? 和の法則を使うと、最初の店のフレーバー選び方2通り + 次の店のフレーバー選び方2通り = 4通りの選択肢があります

ビジネスの応用例

製品の組み合わせの可能性や、マーケティングキャンペーンの組み合わせ選定に利用できます。

- 製品の組み合わせ: 製品Aと製品Bの組み合わせを考える際、積の法則を用いてそれぞれの製品のバリエーションを掛け合わせ、可能な製品組み合わせの総数を求めることができます。

- マーケティングキャンペーン: マーケティングキャンペーンAまたはBが成功する確率を求める際、和の法則を用いてそれぞれのキャンペーンの成功確率を足し合わせることができます。

Pythonコード

# Sample for Product Rule

colors = ['Red', 'Blue']

sizes = ['S', 'M', 'L']

combinations = [(color, size) for color in colors for size in sizes]

print("Product Rule Sample:", combinations)

# Sample for Sum Rule

red_or_s = len([comb for comb in combinations if comb[0] == 'Red' or comb[1] == 'S'])

print("Sum Rule Sample:", red_or_s)Product Rule Sample: [('Red', 'S'), ('Red', 'M'), ('Red', 'L'), ('Blue', 'S'), ('Blue', 'M'), ('Blue', 'L')]

Sum Rule Sample: 4Pythonコードは、積の法則と和の法則のサンプルを示しています。

colorsリストとsizesリストには、それぞれ色とサイズのバリエーションが含まれています。combinationsリスト内包表記を使用して、色とサイズの組み合わせを積の法則を用いて計算し、combinationsに格納されます。red_or_s変数は、和の法則を用いて、「Red」の色または「S」のサイズが選ばれる確率を計算します。これは、「Red」または「S」のいずれかが選ばれる組み合わせの数を計算しています。

コードを実行すると、積の法則と和の法則がそれぞれサンプルとして示されます。

積の法則のサンプル:

Product Rule Sample: [('Red', 'S'), ('Red', 'M'), ('Red', 'L'), ('Blue', 'S'), ('Blue', 'M'), ('Blue', 'L')]和の法則のサンプル:

Sum Rule Sample: 4これにより、積の法則ではすべての組み合わせが計算され、和の法則では排他的な結果が計算されることが示されています。

モンテカルロ法

モンテカルロ法は、乱数を使用して数値的な問題を解決する手法の一つで、確率的な問題や複雑な数学的モデルを解析するために用いられます。

- モンテカルロ法の概要:

- モンテカルロ法は、ランダムなデータ生成やシミュレーションを用いて、数学的な問題に対する近似解を求める方法です。この手法は、解析的な解法が難しい問題や高次元の問題に対して特に有用です。モンテカルロ法の基本的なアイデアは、ランダムなサンプルを生成し、これらのサンプルを用いて問題の解を近似することです。ランダム性を利用することで、確率的な問題や多次元空間での問題に対処できます。

- 例1: コイン投げで円の面積を求める

- 広い広場に大きな正方形のシートが敷かれているとします。このシートの中には、円が描かれています。円の中心は正方形の中心と一致しています。今、この円の面積を知りたいと思ったとき、モンテカルロ法を使って求める方法があります。コインをたくさん、ランダムにこの正方形のシートに投げます。そして、コインが円の中に落ちた数と、円の外に落ちた数を数えます。コインが全体で何回円の中に落ち、何回円の外に落ちたかを使って、円の面積の近似値を計算できます。

- 例2: 誕生日の問題

- あるクラスに30人の生徒がいるとします。そのクラスで2人以上の生徒が同じ誕生日を持っている確率を知りたいとします。実際には計算が複雑になりますが、モンテカルロ法を使って近似的に求めることができます。ランダムに30人分の誕生日を選び、その中で2人以上同じ誕生日を持っているかどうかを確認します。これを何千回、何万回と繰り返して、同じ誕生日を持つ生徒がいた場合の割合を計算します。この割合が、2人以上が同じ誕生日を持つ確率の近似値となります。

ビジネスの応用例

金融市場のリスク評価や、製造工程の最適化、プロジェクト管理のシミュレーションなどで利用されます。

モンテカルロ法はビジネス分野でも広く利用されます。

- 金融市場のリスク評価: 株式や債券の価格変動のモデリングやリスク評価に使用されます。将来の価格変動をシミュレーションし、ポートフォリオのリスクを評価します。

- 製造工程の最適化: 製造プロセスの効率を最適化するために使用されます。材料や機械の特性をランダムに変動させ、最適な製品設計や生産スケジュールを見つけます。

- プロジェクト管理のシミュレーション: プロジェクトの進捗やリソースの管理をシミュレーションし、プロジェクトの成功確率や遅延のリスクを評価します。

Pythonコード

import random

# Estimate pi using Monte Carlo

num_points = 10000

inside_circle = 0

for _ in range(num_points):

x, y = random.random(), random.random()

if x**2 + y**2 <= 1:

inside_circle += 1

estimated_pi = 4 * inside_circle / num_points

print("Estimated Pi:", estimated_pi)Estimated Pi: 3.1432

Pythonコードは、円周率 π の近似計算を行うモンテカルロ法のサンプルです。以下はコードの詳細な説明です。

num_points変数には、乱数生成の回数を指定します。この例では10000回の乱数生成を行います。inside_circle変数は、単位円(半径1の円)の内部に乱数が落ちる回数をカウントするための変数です。- ループを用いて、指定した回数だけ乱数

xとyを生成し、これらの乱数が単位円内に落ちるかどうかを判定します。判定はx^2 + y^2 <= 1という条件で行います。 - 内部に落ちた乱数の回数をカウントし、最終的に円周率 π の近似値を計算します。この計算は

4 * inside_circle / num_pointsで行います。

コードを実行すると、近似された円周率 π の値が表示されます。例えば、Estimated Pi: 3.1432 のような値が得られます。乱数を使用して円周率を推定することが、モンテカルロ法の一例です。

統計学

統計とは

統計は、データに関する情報を収集し、整理・解析してその結果を活用する学問・手法のことです。

統計の概要:

統計は、データを収集し、整理、要約し、そのデータから意味fulな情報を抽出するための学問です。統計は主に2つの側面から成り立っています。

- 記述統計学(Descriptive Statistics): データを要約し、グラフ化してデータの特徴や傾向を理解するための方法です。平均値、中央値、分散、標準偏差などの統計的指標が含まれます。

- 推測統計学(Inferential Statistics): サンプルデータをもとに、全体の母集団に関する推論を行う方法です。信頼区間、仮説検定、回帰分析などが含まれます。

ビジネスの応用例

市場調査、製品の品質管理、販売予測など、多くのビジネスプロセスで統計的手法が利用されます。

統計的手法はビジネスにおいて広く活用されます。

- 市場調査: 消費者の嗜好を調査し、市場セグメンテーションや新製品の評価に統計を使用します。

- 製品の品質管理: 製品の品質制御や不良品の発見に統計的プロセス制御(SPC)を用います。

- 販売予測: 過去の販売データから将来の販売量を予測するために、時系列分析や予測モデルが利用されます。

Pythonコード

import statistics

data = [2, 5, 9, 12, 13, 7, 10, 11, 12, 9, 6]

mean = statistics.mean(data)

print("Mean of Data:", mean)Mean of Data: 8.727272727272727

Pythonコードは、統計の基本的な操作の一例です。

statisticsライブラリを使用して、データセットdataの平均値(平均)を計算します。statistics.mean(data)は、与えられたデータセットdataの平均値を計算し、その結果をmean変数に格納します。print("Mean of Data:", mean)は、計算された平均値を表示します。

コードを実行すると、データセット data の平均値が表示されます。例えば、Mean of Data: 8.727272727272727 のようになります。このコードは統計的な基本操作の一つで、データの特性を理解し、意思決定や問題解決に役立てるのに役立ちます。

母集団と標本

母集団と標本は統計学で重要な概念で、データ分析や調査の際に使用されます。

母集団(Population):

母集団は、研究や分析の対象となる全体の集合を指します。これは、全ての対象やデータポイントが含まれる集合であり、調査や分析を行いたい対象全体を表します。母集団はしばしばとても大きいため、全てのデータを調査することが難しい場合があります。

標本(Sample):

標本は、母集団から選ばれる部分集合です。標本は、母集団の特性を推測するために使用されます。標本は母集団全体を代表し、母集団の特性や特定の性質について情報を提供することを目的としています。標本は母集団から無作為に選ばれることが一般的で、ランダムな選択がバイアスを避けるために重要です。

ビジネスの応用例

顧客満足度調査や品質検査などで、全体を調査するのが困難な場合に標本を取って分析します。

母集団と標本はビジネス分野でも広く活用されます。

- 顧客満足度調査: 顧客全体の意見を収集するのは難しいため、一部の顧客からなる標本を対象に調査を行い、母集団全体の満足度を推測します。

- 品質検査: 製品全量の検査が困難な場合、一部の製品を標本として選び、品質を評価し、母集団の品質を推定します。

Pythonコード

population = list(range(1000))

sample = random.sample(population, 50)

print("Sample:", sample)Sample: [337, 145, 116, 216, 601, 204, 528, 288, 476, 875, 563, 31, 737, 289, 400, 257, 130, 510, 127, 869, 543, 200, 539, 920, 422, 975, 923, 60, 123, 625, 676, 329, 426, 797, 681, 954, 556, 307, 117, 817, 760, 370, 879, 272, 320, 626, 471, 555, 508, 287]

Pythonコードは、標本の作成を示すサンプルです。

populationリストは0から999までの整数を含んでおり、これが母集団を表しています。random.sample(population, 50)は、populationからランダムに50個の要素を選んで標本を作成します。この操作により、母集団から無作為に選ばれた50個のデータポイントがsample変数に格納されます。print("Sample:", sample)は、作成された標本を表示します。

このコードは、母集団からランダムに標本を選んでデータのサブセットを作成する例です。標本は母集団の特性を推測するために使用されることがあります。

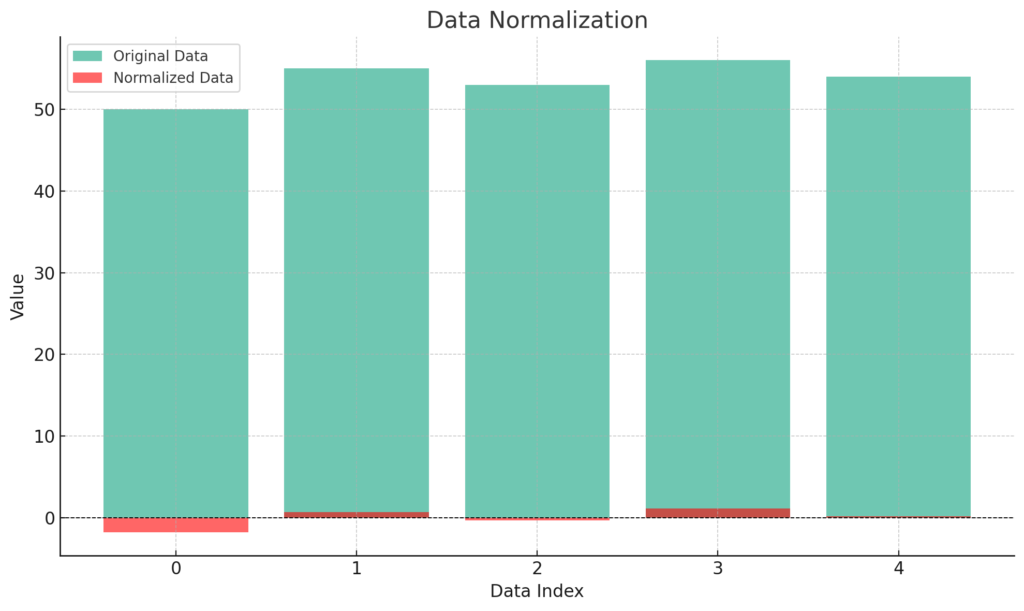

平均値、中央値、最頻値

平均値、中央値、最頻値は、データセットの特性を理解し、データの中心傾向や頻度分布を調べるための統計的な指標です。

平均値(Mean):

平均値は、データセット内のすべての数値の合計を、データの総数で割った値です。平均はデータの中心傾向を表し、データセット内の値の平均的な大きさを示します。平均は数値の合計を全体の数で均等に分配した値です。

中央値(Median):

中央値は、データを昇順に並べたときに、中央に位置する値です。つまり、データを小さい値から大きい値に並べ替えたときに、ちょうど中央に来る値です。中央値は外れ値(極端に大きいまたは小さい値)の影響を受けにくく、データの中央に位置する中心傾向の指標です。

最頻値(Mode):

最頻値は、データセット内で最も頻繁に出現する値です。つまり、データ内で最も多くの回数現れる値を指します。最頻値はデータセット内の頻度分布を表し、特にカテゴリカルデータや離散的なデータの中心傾向を示すのに役立ちます。

ビジネスの応用例

売上データの分析、顧客の購買履歴の分析、従業員の評価など、多岐にわたる分野でこれらの統計的指標が利用されます。

統計的指標はビジネス分野でも広く活用されます。

- 売上データの分析: 平均売上を計算して、売上の平均的な大きさを理解します。

- 顧客の購買履歴の分析: 中央値を使用して、顧客の購買額の中央値を把握し、顧客層を理解します。

- 従業員の評価: 最頻値を使用して、従業員の評価において最も一般的な評価値を特定します。

Pythonコード

median = statistics.median(data)

mode = statistics.mode(data)

print("Median of Data:", median)

print("Mode of Data:", mode)Median of Data: 9

Mode of Data: 9Pythonコードは、データセット data の中央値と最頻値を計算し、表示する例です。

statistics.median(data)は、データセットdataの中央値を計算し、その結果をmedian変数に格納します。statistics.mode(data)は、データセットdataの最頻値を計算し、その結果をmode変数に格納します。- 最終的に、計算された中央値と最頻値が表示されます。

このコードは、データセット内の中央値と最頻値を計算して、データセットの中心傾向と頻度分布を調べるための手法の一例です。

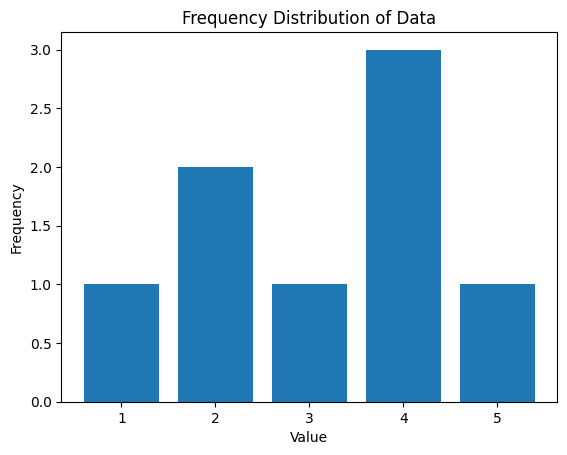

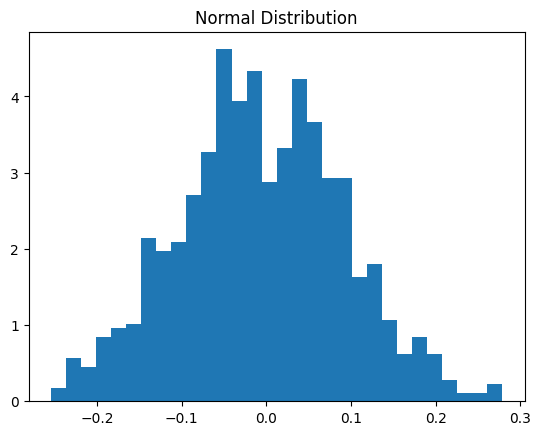

度数分布

度数分布は、データセット内の個々の値(または値の範囲)が、データ内で何回出現するかをまとめたものです。これは、データセット内の値の分布を視覚的に理解するための重要な手法です。度数分布は通常、表やヒストグラムとして表示され、データ内のパターンやトレンドを把握するのに役立ちます。

ビジネスの応用例

商品の売上ランキング、ウェブサイトのページビュー数、顧客の年齢分布など、データの分布を視覚的に理解する際に度数分布が利用されます。

度数分布はビジネス分野でも幅広く活用されます。

- 商品の売上ランキング: 商品別の売上回数を分析して、売上の主要な寄与要因を特定します。

- ウェブサイトのページビュー数: ウェブサイト上の各ページが訪問された回数を把握して、人気のあるコンテンツを特定します。

- 顧客の年齢分布: 顧客データから年齢グループ別の分布を作成し、ターゲットセグメントを特定します。

Pythonコード

import matplotlib.pyplot as plt

from collections import Counter

data = [1, 2, 2, 3, 4, 4, 4, 5]

# Calculate the frequency distribution of the data

frequency = Counter(data)

# Plot a histogram

plt.bar(frequency.keys(), frequency.values())

plt.xlabel('Value')

plt.ylabel('Frequency')

plt.title('Frequency Distribution of Data')

plt.show()

Frequency Distribution: Counter({9: 2, 12: 2, 2: 1, 5: 1, 13: 1, 7: 1, 10: 1, 11: 1, 6: 1})

Pythonコードは、データセット data の度数分布を計算し、ヒストグラムとして表示する例です。

Counter(data)は、データセットdata内の各値の出現回数を計算し、その結果を辞書のようなデータ構造で返します。このデータ構造には各値とその出現回数が含まれます。plt.bar(frequency.keys(), frequency.values())は、度数分布をバー形式のヒストグラムとしてプロットします。frequency.keys()は度数分布の各値(値の一覧)を、frequency.values()はそれぞれの値の出現回数を提供します。plt.xlabel('Value')とplt.ylabel('Frequency')は、x軸とy軸のラベルを設定します。plt.title('Frequency Distribution of Data')は、ヒストグラムのタイトルを設定します。plt.show()は、ヒストグラムを表示します。

このコードは、データセット内の値の度数分布を計算し、その結果をヒストグラムとして視覚化します。ヒストグラムを通じて、データセット内の値の分布と頻度を視覚的に理解できます。

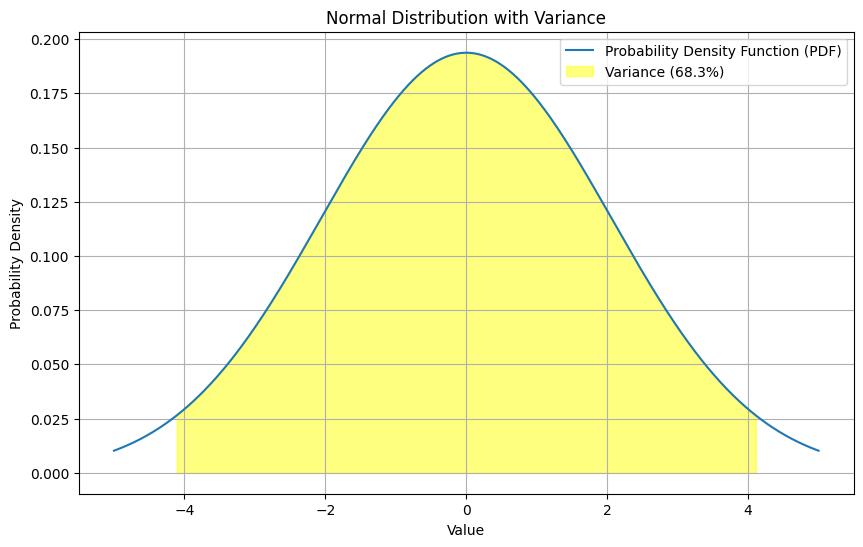

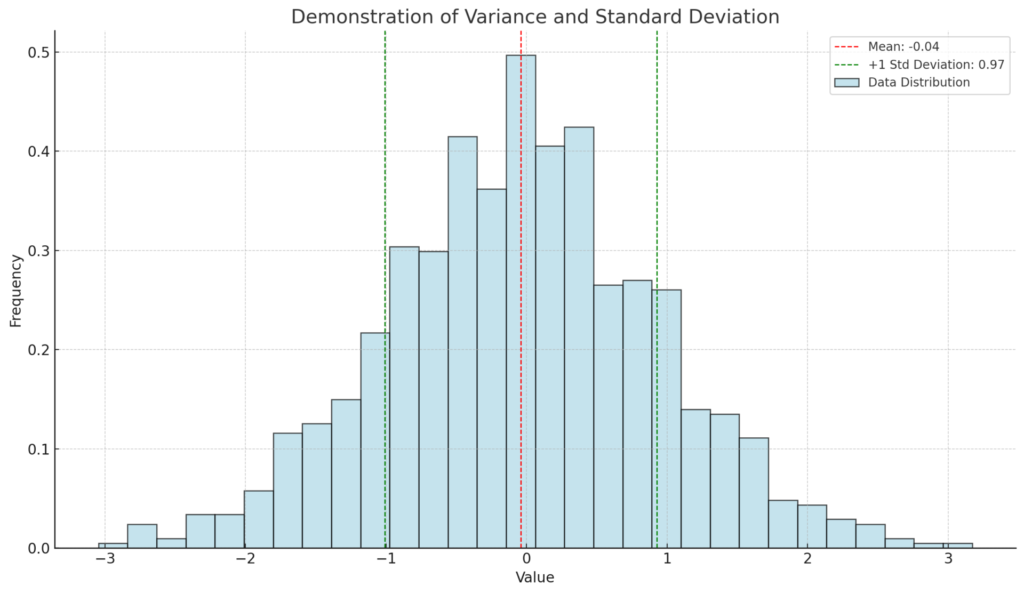

分散と標準偏差

分散と標準偏差は統計学的な概念で、データのばらつきを評価するための指標です。

- 分散(Variance):

- 分散は、データセット内の各データポイントが、その平均値からどれだけ離れているかを示す数値です。

- この離れ具合を数値化するために、各データポイントと平均値の差を計算し、それを二乗してから、それらの二乗値の平均を取ります。

- これにより、データのばらつきを表現し、平均値からの距離を二乗しているため、離れているデータポイントの影響が大きくなります。

- 標準偏差(Standard Deviation):

- 標準偏差は、分散の平方根です。分散と同様、データセット内のデータポイントが平均値からどれだけ離れているかを示しますが、分散よりも直感的な指標です。

- 分散はデータのばらつきを二乗してしまうため、そのままではデータの散らばりを直感的に理解しにくいことがあります。標準偏差はこの問題を解決し、データの散らばりをもとのデータ単位で表現します。

ビジネスの応用例

ビジネスの応用例として、製品の品質管理や販売データの分析が挙げられます。品質管理では、製品の寸法や品質評価のデータから、製品の品質がどれだけばらついているかを評価するのに分散や標準偏差が使われます。販売データの分析では、売上データの変動を理解するためにこれらの指標を活用します。

Pythonコード

import statistics

data = [2, 5, 9, 12, 13, 7, 10, 11, 12, 9, 6]

variance = statistics.variance(data)

std_dev = statistics.stdev(data)

print(variance, std_dev)11.618181818181819 3.4085454109021076Pythonコードは、与えられたデータセットの分散と標準偏差を計算しています。分散は約11.62で、標準偏差は約3.41です。これらの値は、データセット内のデータポイントが平均からどれだけ散らばっているかを示しています。

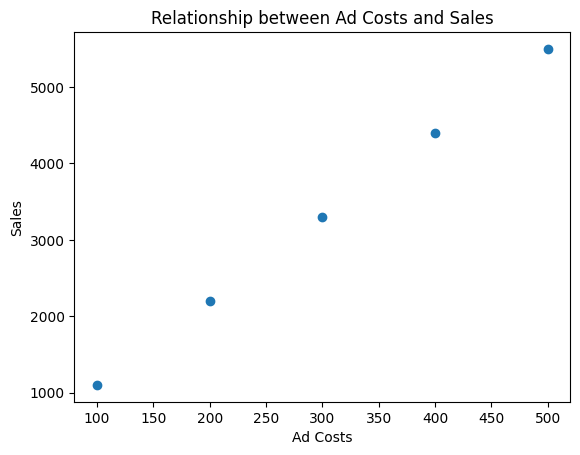

散布図

散布図は、2つの変数の関係を視覚的に表現するためのグラフです。

- 散布図(Scatter Plot):

- 散布図は、2つの異なる変数(データのセット)の間の関係を理解するのに役立つグラフです。通常、横軸(x軸)に1つの変数を、縦軸(y軸)にもう一つの変数を配置します。

- 各データポイントは、横軸の値と縦軸の値に基づいて、散布図上に点として表示されます。このような点の集まりが、2つの変数間のパターンや関係性を視覚的に示します。

ビジネスの応用例

散布図は、ビジネス分析や意思決定の多くの側面で使用されます。例えば、以下のようなケースで役立ちます。

- 製品の価格と売上の関係を調べるため:横軸に価格、縦軸に売上をプロットし、価格と売上の間のパターンを視覚的に把握します。

- 広告費とWebサイトの訪問者数の関係を確認するため:広告費を横軸に、訪問者数を縦軸にプロットし、広告費の変化が訪問者数にどのように影響するかを確認します。

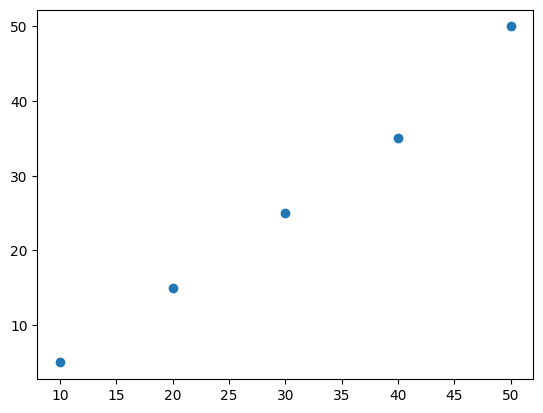

Pythonコード

import matplotlib.pyplot as plt

x = [10, 20, 30, 40, 50]

y = [5, 15, 25, 35, 50]

plt.scatter(x, y)

plt.show()

上記のPythonコードは、散布図を描くための簡単な例です。

matplotlib.pyplotライブラリを使用して、横軸(x)と縦軸(y)のデータをプロットし、plt.scatter()関数を使用して点を表示します。plt.show()を呼び出すことで、実際のグラフが表示されます。

このコードは、xとyのデータを持つ散布図を描き、xとyの間の関係を可視化するのに役立ちます。

共分散と相関係数

共分散と相関係数は、2つの変数間の関係を評価する統計的な指標です。

- 共分散(Covariance):

- 共分散は、2つの変数がどのように一緒に変動するかを示す値です。正の値は、1つの変数が増加するともう1つの変数も増加する傾向があることを示し、負の値は逆の傾向があることを示します。

- 相関係数(Correlation Coefficient):

- 相関係数は、-1から1までの範囲の値を取り、2つの変数の線形的な関係の強さと方向を示す指標です。1に近い値は強い正の相関を示し、-1に近い値は強い負の相関を示します。0は相関がないことを示します。

ビジネスの応用例

共分散と相関係数は、ビジネス分析においてとても重要です。

- 製品の価格と売上の関係性を理解する:価格と売上データの共分散または相関係数を計算し、価格変動が売上にどのように影響するかを評価します。

- 広告費と収益の関係性を評価する:広告費と収益データの共分散または相関係数を計算し、広告費の変動が収益にどの程度影響を与えているかを把握します。

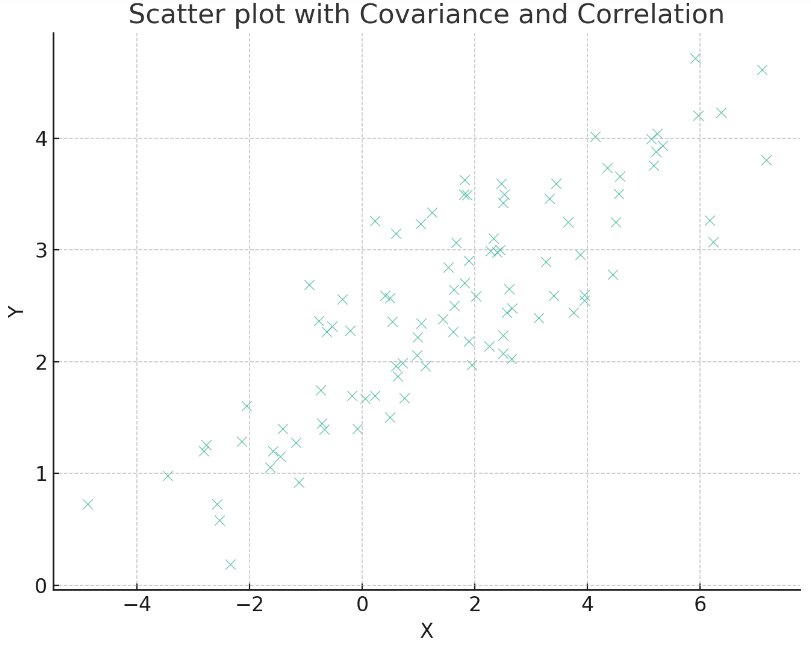

Pythonコード

import numpy as np

import matplotlib.pyplot as plt

# ランダムデータの生成

np.random.seed(0)

x = 2.5 * np.random.randn(100) + 1.5 # Array of 100 values with mean = 1.5, stddev = 2.5

res = 0.5 * np.random.randn(100) # Generate 100 residual terms

y = 2 + 0.3 * x + res # Actual values of Y

# 共分散と相関係数の計算

covariance = np.cov(x, y)[0, 1]

correlation = np.corrcoef(x, y)[0, 1]

# 散布図の作成

plt.figure(figsize=(8, 6))

plt.scatter(x, y, alpha=0.6, edgecolors="w", linewidth=0.5)

plt.title('Scatter plot with Covariance and Correlation')

plt.xlabel('X')

plt.ylabel('Y')

plt.text(0.5, 8, f'Covariance = {covariance:.2f}', fontsize=10, bbox=dict(facecolor='yellow', alpha=0.5))

plt.text(0.5, 7, f'Correlation = {correlation:.2f}', fontsize=10, bbox=dict(facecolor='lightgreen', alpha=0.5))

plt.show()

上記の散布図には、生成されたランダムデータセットがプロットされています。また、計算された共分散と相関係数がグラフ上に表示されています。

移動平均

移動平均は、時系列データの変動を平滑化するための手法です。

- 移動平均(Moving Average):

- 移動平均は、一連のデータポイントに対して、一定の期間ごとの平均値を計算する手法です。

- 時系列データはしばしばランダムな変動が含まれ、トレンドやパターンを見つけることが難しいことがあります。移動平均は、このようなランダムな変動を平滑化し、データ内のトレンドやパターンをより明確に見るのに役立ちます。

ビジネスの応用例

移動平均は、ビジネス分析や予測のさまざまな側面で使用されます。

- 株価の分析:株価チャートに移動平均線を描き、株価のトレンドを確認しやすくします。例えば、50日移動平均や200日移動平均などが一般的です。

- 売上データのトレンド分析:月ごとの売上データに移動平均を適用することで、季節的な変動やトレンドを特定し、将来の売上を予測するのに役立ちます。

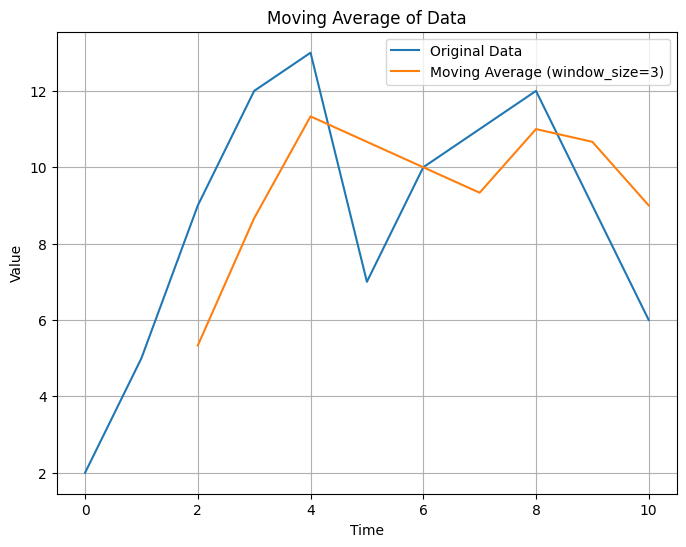

Pythonコード

import matplotlib.pyplot as plt

def moving_average(data, window_size):

return [sum(data[i:i+window_size])/window_size for i in range(len(data) - window_size + 1)]

data = [2, 5, 9, 12, 13, 7, 10, 11, 12, 9, 6]

window_size = 3

ma_data = moving_average(data, window_size)

# Create a plot

plt.figure(figsize=(8, 6))

plt.plot(data, label='Original Data')

plt.plot(range(window_size - 1, len(data)), ma_data, label=f'Moving Average (window_size={window_size})')

plt.xlabel('Time')

plt.ylabel('Value')

plt.title('Moving Average of Data')

plt.legend()

plt.grid(True)

plt.show()

[5.333333333333333, 8.666666666666666, 11.333333333333334, 10.666666666666666, 10.0, 9.333333333333334, 11.0, 10.666666666666666, 9.0]

- Pythonコードは、指定したウィンドウサイズ(

window_size)を使ってデータの移動平均を計算し、元のデータと移動平均値の両方を同じグラフ上にプロットする例です。 moving_average関数は、データ内の各ウィンドウにおける平均値を計算します。ウィンドウはデータ内をスライドして移動し、期間ごとの平均値を求めます。- グラフは元のデータと移動平均値を比較し、データ内の変動を平滑化した結果を視覚化します。

- 与えられたデータセットとウィンドウサイズに基づいて、移動平均が計算されます。

- 移動平均の値

[5.33, 8.67, 11.33, 10.67, 10.0, 9.33, 11.0, 10.67, 9.0]は、ウィンドウサイズが3の場合の各期間ごとの平均値です。 - これらの平均値は、元のデータと一緒にグラフにプロットされ、データの変動のトレンドを視覚的に示しています。

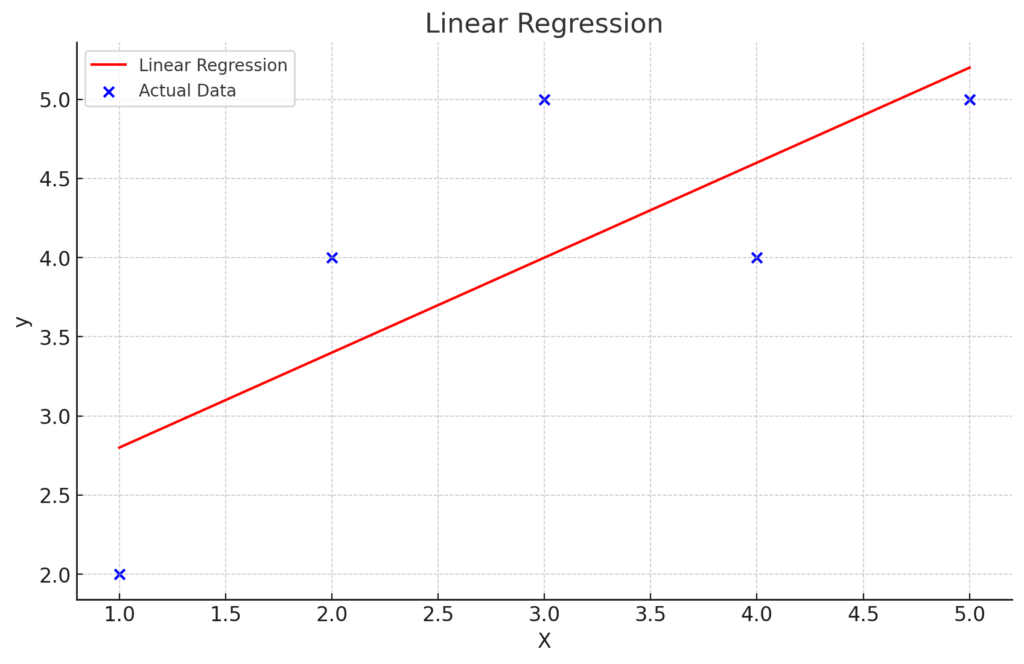

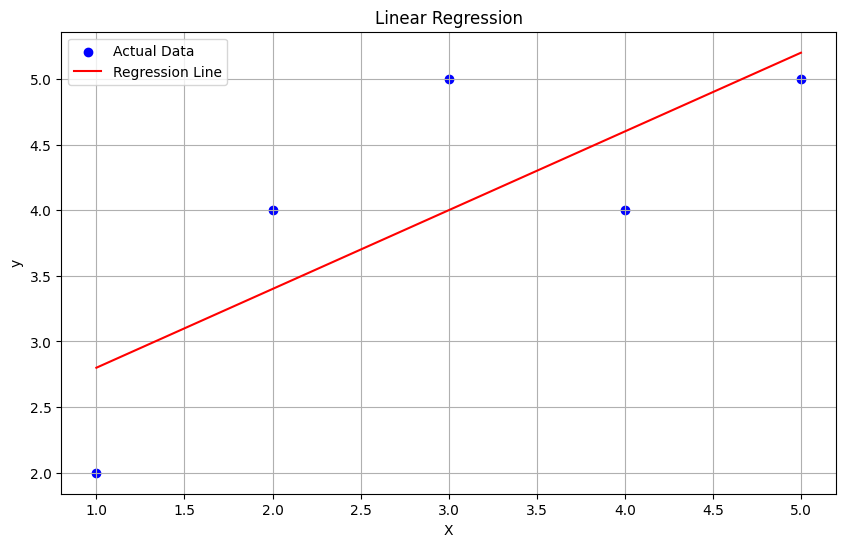

回帰直線

回帰直線は、データの散布図において、2つの変数間の関係を最もよく表現する直線です。

- 回帰直線(Regression Line):

- 回帰直線は、散布図上のデータポイントに合った直線で、2つの変数間の関係を要約したものです。この直線は、データポイントの中心的なトレンドやパターンを示します。

- 回帰直線は通常、単回帰(1つの説明変数が目的変数に影響を与える場合)または重回帰(複数の説明変数が目的変数に影響を与える場合)の分析に使用されます。

ビジネスの応用例

回帰直線は、ビジネス分析と予測の多くの側面で使用されます。

- 価格設定戦略:製品の価格と売上データから回帰直線を計算し、価格と売上の関係を理解し、適切な価格設定戦略を立てるのに役立ちます。

- 広告費と収益:広告費と収益データから回帰直線を求め、広告費の変動が収益にどの程度影響を与えるかを評価します。

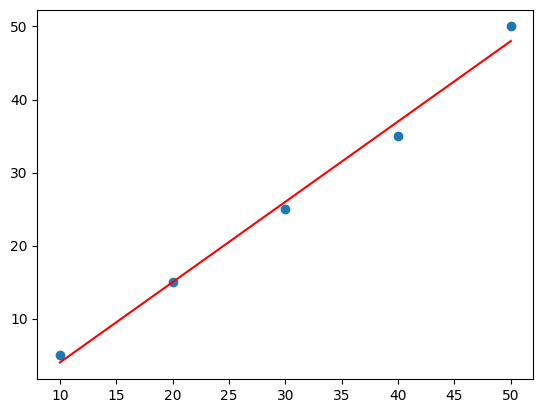

Pythonコード

from scipy.stats import linregress

x = [10, 20, 30, 40, 50]

y = [5, 15, 25, 35, 50]

slope, intercept, _, _, _ = linregress(x, y)

regression_line = [slope*xi + intercept for xi in x]

plt.scatter(x, y)

plt.plot(x, regression_line, color="red")

plt.show()

Pythonコードは、scipy.stats ライブラリの linregress 関数を使用して、与えられたデータポイントに対する回帰直線を計算し、それをグラフ上に表示する例です。

linregress関数は、与えられたデータに対する回帰直線の傾き(slope)、切片(intercept)などの統計的な情報を提供します。- 散布図上にデータポイントを表示し、回帰直線(赤い直線)を描画して、データのパターンと回帰直線を比較できるようにしています。

このコードを実行することで、データの散布図に対する回帰直線を見ることができ、2つの変数間の関係を視覚的に理解できます。

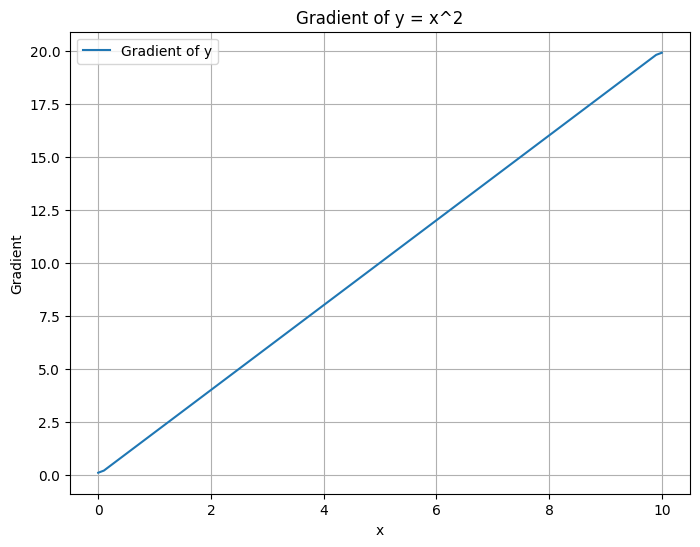

微分の変化率

微分の変化率は、関数のある点における変化率を示すもので、その点における関数の勾配(傾き)として表現されます。

- 微分の変化率(Derivative):

- 微分は、数学的な概念で、ある関数における変化の速さや傾きを表します。特定の点における微分は、その点における接線の傾きを示します。接線は、関数のグラフとその点で接する直線です。

- 微分の変化率は、ある点から微小な変化が発生した場合に、関数の値がどれだけ変化するかを示します。変化率が正の場合、関数の値は増加します。変化率が負の場合、関数の値は減少します。

ビジネスの応用例

微分の概念は、ビジネス分析において以下のような応用があります。

- 成長率の評価:製品の生産量や売上データなどの時系列データに対して微分を適用することで、各期間における成長率や減少率を計算できます。これにより、製品の成長の速さや減少の程度を把握できます。

- 最適化:最大利益を追求するために、収益関数やコスト関数の微分を使用して、最適な戦略を見つけることがあります。

Pythonコード

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(0, 10, 100)

y = x**2

dy = np.gradient(y, x)

# Create a plot

plt.figure(figsize=(8, 6))

plt.plot(x, dy, label='Gradient of y')

plt.xlabel('x')

plt.ylabel('Gradient')

plt.title('Gradient of y = x^2')

plt.legend()

plt.grid(True)

plt.show()

[ 0.1010101 0.2020202 0.4040404 0.60606061 0.80808081 1.01010101

1.21212121 1.41414141 1.61616162 1.81818182 2.02020202 2.22222222

2.42424242 2.62626263 2.82828283 3.03030303 3.23232323 3.43434343

3.63636364 3.83838384 4.04040404 4.24242424 4.44444444 4.64646465

4.84848485 5.05050505 5.25252525 5.45454545 5.65656566 5.85858586

6.06060606 6.26262626 6.46464646 6.66666667 6.86868687 7.07070707

7.27272727 7.47474747 7.67676768 7.87878788 8.08080808 8.28282828

8.48484848 8.68686869 8.88888889 9.09090909 9.29292929 9.49494949

9.6969697 9.8989899 10.1010101 10.3030303 10.50505051 10.70707071

10.90909091 11.11111111 11.31313131 11.51515152 11.71717172 11.91919192

12.12121212 12.32323232 12.52525253 12.72727273 12.92929293 13.13131313

13.33333333 13.53535354 13.73737374 13.93939394 14.14141414 14.34343434

14.54545455 14.74747475 14.94949495 15.15151515 15.35353535 15.55555556

15.75757576 15.95959596 16.16161616 16.36363636 16.56565657 16.76767677

16.96969697 17.17171717 17.37373737 17.57575758 17.77777778 17.97979798

18.18181818 18.38383838 18.58585859 18.78787879 18.98989899 19.19191919

19.39393939 19.5959596 19.7979798 19.8989899 ]

Pythonコードは、NumPyおよびMatplotlibライブラリを使用して、特定の関数 y = x^2 の微分の変化率を計算し、グラフ上にプロットする例です。

np.linspace(0, 10, 100)を使用して、xの範囲を0から10まで100の等間隔の点で生成します。y = x^2の関数を表すためにy = x**2を使用します。np.gradient()関数を使用して、xに対するyの勾配(変化率)を計算します。- グラフ上にxに対する勾配をプロットして、関数

y = x^2の各点における変化率を可視化します。

このコードを実行することで、関数の微分による変化率がxの範囲内でどのように変化するかを理解できます。

微分係数

微分係数は、関数のある点での微分(導関数)の値を指します。これは、その点での関数の変化の速さを示す数値です。

- 微分係数:

- 微分係数は、関数の特定の点における変化率を表します。具体的には、その点における接線の傾きを示します。

- 関数がある点で急峻に上昇している場合、微分係数は正の値となり、関数が下降している場合は負の値となります。

- 微分係数がゼロの場合、関数はその点で水平です。

ビジネスの応用例

微分係数は、ビジネス分析において価値があります。

- 価格弾力性の評価:製品の価格変動が売上に与える影響を理解するために、価格の微小な変化に対する売上の変化率を知る必要があります。微分係数を使用して、価格弾力性を評価できます。

Pythonコード

from sympy import symbols, diff

x = symbols('x')

f = x**2

diff_coefficient = diff(f, x)2*x

- Pythonコードは、Sympyライブラリを使用して、関数

f = x^2の微分係数を計算する例です。 symbols('x')を使用して、変数xを宣言します。f = x**2で関数を表します。diff(f, x)関数を使用して、関数fを変数xに関して微分し、その微分係数を計算します。- 結果として、微分係数

2*xが得られます。これはxの値に依存する関数で、その点での微分係数を示します。

このコードを実行することで、関数 f = x^2 の微分係数が 2*x であることがわかります。したがって、関数の各点における変化率は 2*x によって表されます。

微分する

「微分する」とは、与えられた関数を微分して新しい関数、つまり導関数(後述)を得る操作を指します。

- 微分する:

- 微分は、関数がある点での変化率を計算する操作です。特に、ある点での接線の傾きを求めることで、その点での関数の振る舞いを理解できます。

- 関数を微分することにより、元の関数から導関数を得ることができます。導関数は、関数の各点における変化率を表す新しい関数です。

- 微分にはさまざまなルールがあり、微分したい関数の形に応じて適用されます。

ビジネスの応用例

微分はビジネス分析や最適化の際にとても重要です。

- 最小値を見つける:コスト関数や収益関数など、ビジネス上の問題で最適な解を見つけるために微分を使用します。最小値(または最大値)は導関数がゼロになる点で見つけることができます。これは、例えば生産コストを最小化するための最適な生産数量を見つける際に役立ちます。

Pythonコード

from sympy import symbols, diff

x = symbols('x')

f = x**3 - 3*x**2 + 2*x

df = diff(f, x)

print(df)3*x**2 - 6*x + 2上記のPythonコードは、Sympyライブラリを使用して、関数 f = x^3 - 3*x^2 + 2*x の微分を計算し、その導関数を表示する例です。

symbols('x')を使用して、変数xを宣言します。f = x**3 - 3*x**2 + 2*xで関数を表します。diff(f, x)関数を使用して、関数fを変数xに関して微分し、その導関数を計算します。- 結果として、導関数

3*x**2 - 6*x + 2が得られます。これは、元の関数の各点における変化率を表す導関数です。

このコードを実行することで、関数 f = x^3 - 3*x^2 + 2*x の導関数が 3*x**2 - 6*x + 2 であることがわかります。したがって、この導関数は元の関数の各点における変化率を表しています。

導関数とは

導関数とは、元の関数を微分して得られる新しい関数を指します。導関数は、元の関数がある点での変化率を表現し、その点での関数の振る舞いを理解するのに役立ちます。

- 導関数:

- 導関数は、与えられた関数を微分した結果得られる新しい関数です。導関数は、元の関数がある点での変化の速さを表します。

- 導関数の値はその点における接線の傾きを示し、その点での関数の上昇または下降の速さを定量化します。

ビジネスの応用例

導関数はビジネス分析においてさまざまな応用があります。

- 需要予測モデルの最適化:製品の需要予測モデルの精度を向上させるために、コスト関数の導関数を使用してモデルのパラメータを調整することがあります。導関数を最小化することにより、モデルの予測精度を最適化できます。

Pythonコード

from sympy import symbols, diff

x = symbols('x')

f = x**2 - 4*x + 4

df = diff(f, x)2*x - 4上記のPythonコードは、Sympyライブラリを使用して、関数 f = x^2 - 4*x + 4 の導関数を計算し、その導関数を表示する例です。

symbols('x')を使用して、変数xを宣言します。f = x**2 - 4*x + 4で関数を表します。diff(f, x)関数を使用して、関数fを変数xに関して微分し、その導関数を計算します。- 結果として、導関数

2*x - 4が得られます。これは、元の関数の各点における変化率を表す導関数です。

このコードを実行することで、関数 f = x^2 - 4*x + 4 の導関数が 2*x - 4 であることがわかります。したがって、この導関数は元の関数の各点における変化率を示しています。

微分の公式

微分の公式は、特定の関数の形に対する微分操作の結果を表す数学的な公式です。異なる種類の関数に対する微分操作を簡略化し、効率的に計算するためのツールです。

- 微分の公式は、特定の関数形に対する微分操作を示す数式です。これにより、関数がどのように変化するかを簡単に計算できます。

- 例えば、\( ax^n \) 形式の関数の微分は、\( anx^{n-1} \) という公式になります。ここで、\( a \) は定数で、\( n \) は指数です。

- 他にも、三角関数、指数関数、対数関数などに対する微分公式が存在し、各関数の特性に合わせて微分を行う際に役立ちます。

ビジネスの応用例

微分の公式は、ビジネス分析において以下のような応用があります。

- コスト関数の最適化:製品の生産コストを表すコスト関数を最小化するために微分を使用する場合、微分の公式を活用してコスト関数の導関数を計算し、最小値を求めることができます。これにより、最適な生産数量や価格を決定できます。

Pythonコード

from sympy import symbols, diff

x = symbols('x')

f = 3*x**4 - 5*x**3 + 2*x**2

df = diff(f, x)12*x**3 - 15*x**2 + 4*x上記のPythonコードは、Sympyライブラリを使用して、関数 f = 3*x**4 - 5*x**3 + 2*x**2 の微分を計算し、その導関数を表示する例です。

symbols('x')を使用して、変数xを宣言します。f = 3*x**4 - 5*x**3 + 2*x**2で関数を表します。diff(f, x)関数を使用して、関数fを変数xに関して微分し、その導関数を計算します。- 結果として、導関数

12*x**3 - 15*x**2 + 4*xが得られます。これは、元の関数の各点における変化率を表す導関数です。

このコードを実行することで、関数 f = 3*x**4 - 5*x**3 + 2*x**2 の導関数が 12*x**3 - 15*x**2 + 4*x であることがわかります

極小と極大

極小点と極大点は、関数の振る舞いにおける重要な特別な点を指します。

- 極小点と極大点:

- 極小点:関数がある点において、その近傍で最も小さい値を持つ点を極小点と呼びます。極小点では、関数がその点を中心に上昇から下降に転じます。

- 極大点:関数がある点において、その近傍で最も大きい値を持つ点を極大点と呼びます。極大点では、関数がその点を中心に下降から上昇に転じます。

ビジネスの応用例

極小点と極大点はビジネス分析において以下のような応用があります。

- 最適化:製品のコスト、売上、利益などの関数を最適化するために、関数の極小点や極大点を求めることがあります。例えば、最適な生産数量や価格を見つけるために使用できます。

Pythonコード

from sympy import symbols, diff, solve

x = symbols('x')

f = x**3 - 3*x**2 + 2*x

df = diff(f, x)

critical_points = solve(df, x)[1 - sqrt(3)/3, sqrt(3)/3 + 1]上記のPythonコードは、Sympyライブラリを使用して、関数 f = x**3 - 3*x**2 + 2*x の極小点と極大点を計算する例です。

symbols('x')を使用して、変数xを宣言します。f = x**3 - 3*x**2 + 2*xで関数を表します。diff(f, x)関数を使用して、関数fを変数xに関して微分し、その導関数を計算します。solve(df, x)を使用して、導関数がゼロとなる点を見つけます。これらの点が関数の極小点と極大点です。- 結果として、極小点が

[1 - sqrt(3)/3, sqrt(3)/3 + 1]として得られます。

このコードを実行することで、関数 f = x**3 - 3*x**2 + 2*x の極小点と極大点が求められます。これらの点は、関数が最小または最大となる場所を示します。

積分とは

積分は、数学的な手法の一つで、関数の下での面積や空間内の体積を計算するために使用されます。不定積分と定積分の2つの主要な種類があります。

- 積分は、関数が与えられた領域でどれだけの面積を占めるか、または空間内でどれだけの体積を持つかを計算する数学的な操作です。

- 不定積分(indefinite integral)は、関数の原始関数(antiderivative)を求める操作で、導関数が与えられた関数になるような関数を見つけることを意味します。不定積分は通常 \( \int \) と表記されます。

- 定積分(definite integral)は、特定の区間で関数の下での面積や体積を計算するために使用されます。定積分は通常 \(\int_a^b\) と表記され、区間 \([a, b]\) 内での積分値を示します。

ビジネスの応用例

積分はビジネス分析において以下のような応用があります。

- 生産量の計算:製品の生産速度が時間に対してどのように変化するかを知っている場合、積分を使用してある時間間隔内での生産量を計算できます。これにより、製品の在庫管理や生産計画を最適化できます。

Pythonコード

import numpy as np

from scipy.integrate import quad

func = lambda x: x**2

result, _ = quad(func, 0, 1)0.33333333333333337上記のPythonコードは、Scipyライブラリを使用して、関数 \(f(x) = x^2\) の不定積分を計算し、区間 \([0, 1]\) での定積分値を示す例です。

quad関数を使用して不定積分を計算し、結果として積分値が得られます。- 結果として、積分値は約 \(0.333\) です。

このコードを実行することで、関数 \(f(x) = x^2\) の不定積分と定積分が計算され、区間 \([0, 1]\) での積分値が示されます。この値は、関数 \(f(x)\) の区間 \([0, 1]\) 内での面積を表します。

積分する

積分は、関数の特定の区間における面積を計算したり、関数の原始関数(後述)を求めたりする数学的操作を指します。

- 積分するとは、与えられた関数をある区間で積分することです。これにより、関数のグラフの特定の区間での面積や、その関数に関連付けられた原始関数を求めることができます。

ビジネスの応用例

- エネルギー消費の計算:エネルギー消費の時間変化がわかっている場合、その期間内の総エネルギー消費を計算するために積分を使用できます。たとえば、特定の期間における総エネルギー消費量を求めることができます。これは、エネルギー効率の改善や予算の立案に役立ちます。

Pythonコード

from scipy.integrate import quad

func = lambda x: 3*x**2 + 2*x

result, _ = quad(func, 0, 2)

print("積分結果:", result)積分結果: 12.0上記のPythonコードは、Scipyライブラリを使用して、関数 \(f(x) = 3x^2 + 2x\) の不定積分を計算し、区間 \([0, 2]\) での定積分値を求める例です。

quad関数を使用して、関数funcの積分を計算し、結果として積分値がresultに格納されます。- 結果として、積分値は特定の区間 \([0, 2]\) 内での関数の面積を表します。この場合、関数 \(f(x)\) の区間 \([0, 2]\) での面積が計算されます。

このコードを実行することで、関数 \(f(x) = 3x^2 + 2x\) の区間 \([0, 2]\) での積分値が計算され、その区間での面積が示されます。

定積分・不定積分

定積分と不定積分は、積分の2つの主要な種類であり、それぞれ異なる目的に使用されます。

- 定積分は、関数の特定の区間における面積を計算するための数学的な操作です。特定の範囲内で関数がどれだけの面積を占めているかを示します。数学的には、\(\int_a^b f(x) \, dx\) と表記され、関数 \(f(x)\) を範囲 \([a, b]\) で積分することを示します。

- 不定積分は、関数の原始関数(antiderivative)を求める操作です。不定積分を行うと、導関数が与えられた関数になるような関数を見つけることができます。不定積分は通常、\\(\int f(x) \, dx\\) と表記されます。

ビジネスの応用例

- 定積分:商品の販売速度の時間変化が分かっている場合、特定の期間での総販売数を計算するために定積分を使用できます。例えば、特定の月の総売上を求めるために使用できます。

- 不定積分:商品の販売速度の関数を知っている場合、販売速度から販売数を計算するために不定積分を使用できます。これにより、時間の経過に伴う販売数の変化を予測できます。

Pythonコード

from scipy.integrate import quad

from scipy.integrate import quad, solve_ivp

# 定積分

func = lambda x: 2*x + 1

result, _ = quad(func, 0, 3)

print(result)

# 不定積分(原始関数を近似的に求める)

def model(t, y): return 2*t + 1

sol = solve_ivp(model, [0, 3], [0])

print(sol)12.0

message: The solver successfully reached the end of the integration interval.

success: True

status: 0

t: [ 0.000e+00 1.000e-04 1.100e-03 1.110e-02 1.111e-01

1.111e+00 3.000e+00]

y: [[ 0.000e+00 1.000e-04 1.101e-03 1.122e-02 1.234e-01

2.346e+00 1.200e+01]]

sol: None

t_events: None

y_events: None

nfev: 38

njev: 0

nlu: 0上記のPythonコードは、Scipyライブラリを使用して、定積分と不定積分の計算例です。

- 定積分の例では、関数 \(f(x) = 2x + 1\) を範囲 \([0, 3]\) で積分し、結果として面積が

resultに格納されます。この場合、結果は12.0です。 - 不定積分の例では、関数 \(f(t) = 2t + 1\) の原始関数を近似的に求めるために

solve_ivp関数を使用しています。これにより、関数 \(f(t)\) の原始関数が得られ、時間に対する変化を示します。

このコードを実行することで、定積分と不定積分の基本的な概念が示され、ビジネスにおける応用例が説明されています。

原始関数

- 原始関数は、ある関数 \(f(x)\) を不定積分することによって得られる関数です。不定積分を行うことで、元の関数に対して微分操作を逆にしたような操作を行います。

- 数学的には、\(F(x)\) が関数 \(f(x)\) の原始関数であるとき、次のように表現されます。\[F(x) = \int f(x) \, dx\]

ビジネスの応用例

原始関数は、コスト関数の変化を知っている場合に、ある期間の総コストを求めるために使用されます。たとえば、特定の生産プロセスのコスト関数が与えられた場合、原始関数を使用して生産の総コストを計算できます。

Pythonコード

from sympy import symbols, integrate

x = symbols('x')

func = 2*x + 1

primitive_func = integrate(func, x)

print(primitive_func)x**2 + x上記のPythonコードは、SymPyライブラリを使用して、関数 \(f(x) = 2x + 1\) の原始関数を計算し、その結果を示しています。

integrate関数を使用して、関数funcの不定積分を計算し、結果として原始関数primitive_funcが得られます。この場合、原始関数は \(x^2 + x\) です。

このコードを実行することで、関数 \(f(x) = 2x + 1\) の原始関数が計算され、それがどのように得られるかが示されます。原始関数は、不定積分の結果として得られるものであり、微分操作を逆にできることが特徴です。

積分定数Cとは

積分定数Cは、不定積分の結果に追加される定数です。

- 積分定数C: 積分定数Cは、不定積分を計算した際に現れる定数です。不定積分は、関数を積分する過程で特定の区間を指定せずに行われるため、不確定性が残ります。そのため、不定積分の結果には積分定数Cが含まれ、具体的な値が指定されていないため、Cは任意の実数を取ることができます。

ビジネスの応用例

積分定数Cは、物理学、工学、経済学などのさまざまな分野で使用されます。特に初期条件や境界条件を満たすための調整要因として役立ちます。たとえば、物理学の運動方程式を解く際に、初期速度や初期位置を表す積分定数Cが必要です。経済学の場合、積分定数Cは初期資本や初期需要などを示すのに使われることがあります。

Pythonコード

from sympy import symbols, integrate

x, C = symbols('x C')

primitive_func = integrate(2*x, x) + C

print(primitive_func)C + x**2上記のPythonコードは、積分定数Cが不定積分の結果に含まれることを示す例です。具体的には、不定積分を計算する際にCを追加しています。このCは、不定積分の結果において、特定の初期条件や境界条件に応じて調整される値であることを示しています。

積分定数Cは、数学的な計算や物理的なモデリングにおいて、問題の特性や初期条件に合わせて調整される重要な要素です。

微分・積分

微分と積分は、数学の基本的な概念です。

- 微分: 微分は、関数の局所的な変化率を調査する手法です。具体的には、関数の各点での勾配(傾き)を計算し、その点における関数の振る舞いを理解します。微分を用いることで、関数がどのように急峻に上昇または下降しているか、極小値や極大値を見つけることができます。

- 積分: 積分は、関数の区間における面積や、関数の原始関数を求める手法です。特定の区間で関数が囲む面積を計算できるため、積分は領域の面積や累積量を求めるのに役立ちます。また、微分の逆操作としても知られており、微分によって得られた関数を元の関数に戻すことができます。

ビジネスの応用例

微分と積分は、ビジネスにおいても広く使用されます。たとえば、製品の販売速度を微分により求めることで、ある瞬間における販売の速さを知ることができます。そして、この結果を積分することで、ある期間の総販売量を計算できます。このように、微分と積分は販売データの分析や需要予測などのビジネスにおける重要なツールとして使用されます。

Pythonコード

from sympy import symbols, diff, integrate

x = symbols('x')

func = x**2

diff_func = diff(func, x)

integrated_func = integrate(diff_func, x)

print(integrated_func)x**2上記のPythonコードは、関数 x**2 を微分してから積分する例です。まず、diff(func, x) を使用して関数の微分を計算し、次にintegrate(diff_func, x) を使用して微分の逆操作である積分を行います。最終的に、元の関数 x**2 が再び得られます。

微分と積分は数学と科学の基盤であり、多くの分野で応用されています。ビジネス分野では、データの解析や最適化などに役立つ重要な数学的ツールとして利用されています。

微分と積分の関係

- 微分と積分は、関数に対する2つの基本的な操作です。微分は関数の導関数(変化率)を求め、積分は関数の不定積分(面積または原始関数)を求めます。

- これら2つの操作は逆の関係にあります。つまり、関数を微分して導関数を得た後、その導関数を積分すると、元の関数が得られます(定数を除く)。

ビジネスの応用例

微分を使用して製品の販売速度を求めた場合、その結果を積分することで、ある期間の総販売量を計算できます。たとえば、日々の販売速度から月間の総販売量を計算できます。

Pythonコード

from sympy import symbols, diff, integrate

x = symbols('x')

func = x**2

diff_func = diff(func, x)

integrated_func = integrate(diff_func, x)

print(integrated_func)x**2上記のPythonコードは、SymPyライブラリを使用して、関数 \(f(x) = x^2\) を微分してから積分する例です。

- まず、関数

funcを微分し、その結果をdiff_funcに格納します。この場合、導関数は \(2x\) です。 - 次に、導関数

diff_funcを積分し、その結果をintegrated_funcに格納します。この積分により、元の関数 \(x^2\) が復元されます。

このコードを実行することで、微分と積分の関係が示され、微分した後に積分を行うことで元の関数を再構築できることがわかります。

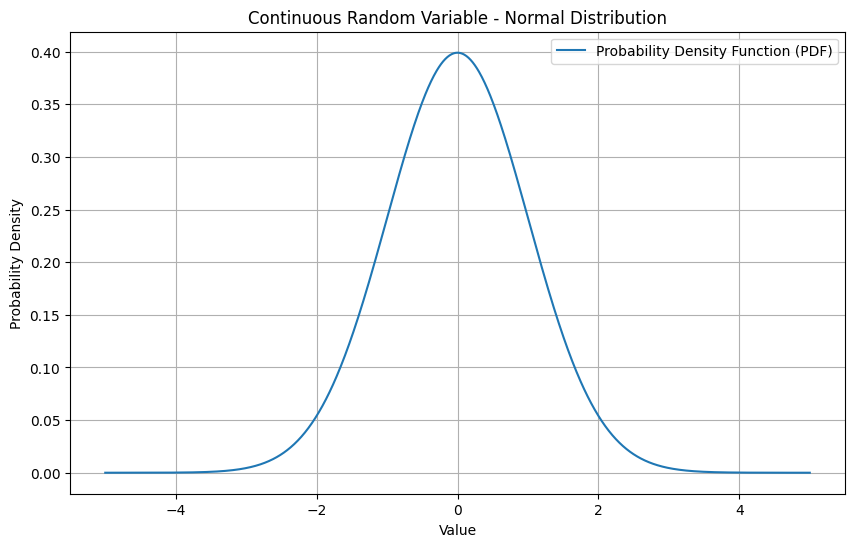

期待値と分散

期待値と分散は統計学と確率論の基本的な概念です。

- 期待値: 期待値は、確率変数の平均値を示します。確率変数は、ランダムな値を取る変数であり、その平均値はその確率変数が取り得る値の重みつき平均です。期待値は、確率分布を考慮して、各値をその確率で重みづけた平均です。例えば、サイコロを振る場合、1から6の値が等しい確率で出る場合、期待値は (1+2+3+4+5+6)/6 = 3.5 となります。

- 分散: 分散は、確率変数がどれだけばらついているかを示す尺度です。分散が小さいほど、確率変数の値は平均値に近く、分散が大きいほど、値は平均から離れた範囲に分布します。分散は、各値と平均値の差の二乗を計算し、その平均を取ることで求められます。分散がゼロの場合、確率変数は一定の値しか取らないことを示し、分散が大きい場合、値は広い範囲に分布しています。

ビジネスの応用例

期待値と分散は、ビジネスにおいても重要な役割を果たします。商品の売上予測を例に取ると、過去の売上データの期待値を計算することで、平均的な売上を把握できます。また、分散を調べることで、売上のばらつきやリスクを評価できます。これにより、将来の売上の予測と、その予測の信頼性を評価するのに役立ちます。

Pythonコード

import numpy as np

data = [10, 20, 30, 40, 50]

mean = np.mean(data)

variance = np.var(data)

print(variance)200.0上記のPythonコードは、与えられたデータセットの分散を計算する例です。データセット [10, 20, 30, 40, 50] の分散は 200.0 です。この値は、データポイントが平均値からどれだけばらついているかを示しています。

期待値と分散は、統計的な分析や意思決定において、データの特性やリスクの評価に役立つ重要な統計量です。

2つの確率変数

確率変数とは、ランダムな結果を持つ変数です。2つの確率変数がある場合、それぞれの確率変数が異なる出来事や値に関連している可能性があります。これらの確率変数の関係性や相互作用を調査することは、データ分析や統計学の重要な要素です。

ビジネスの応用例

ビジネスでは、2つの異なる製品の売上データを分析することがよくあります。たとえば、AとBという2つの製品がある場合、Aの売上が増加すると、Bの売上にどのような影響があるかを調査します。このような分析は、戦略的な意思決定に役立ちます。例えば、AとBが競合関係にある場合、Aの売上が上がるとBの売上が減少する可能性があるかもしれません。逆に、AとBが補完関係にある場合、Aの売上増加がBの売上増加につながるかもしれません。したがって、2つの確率変数の関係を理解することは、製品戦略や市場戦略においてとても重要です。

2つの確率変数の相互作用を調査するために、統計モデルやデータ分析手法を使用することが一般的です。これにより、ビジネスの意思決定者は、異なる要因間の関係性を理解し、適切な戦略を策定するのに役立つ情報を得ることができます。

Pythonコード

# No specific code for this, as it's a general concept.独立と共分散

2つの確率変数が独立の場合、一方の変数の変化がもう一方の変数の変化に影響を与えません。共分散は、2つの変数の関係性の強さを示します。

- 独立性: 2つの確率変数が独立している場合、一方の変数の値が変化しても、もう一方の変数には影響を与えません。言い換えれば、一方の変数の値がわかっても、もう一方の変数の予測に役立つ情報は得られません。例えば、コインを2回投げる場合、1回目の結果が表か裏かは、2回目の結果に影響を与えません。これらの事象は独立しています。

- 共分散: 共分散は、2つの変数の関係性や一緒に変動する度合いを示す統計的な尺度です。正の共分散は、2つの変数が一緒に変動することを示し、負の共分散は、1つの変数が増加するともう一方が減少することを示します。共分散の絶対値が大きいほど、変数間の関係が強いことを示し、絶対値が小さいほど関係が弱いことを示します。ただし、共分散の単位は変数の単位の積であり、単位に依存するため、絶対値自体には意味がありません。

ビジネスの応用例

ビジネスの分野では、2つの変数(例: 製品Aの売上と製品Bの売上)の共分散を計算して、これらの変数の関係性を評価します。共分散が正の場合、製品Aの売上が増加すると、製品Bの売上も増加する可能性があります。逆に、共分散が負の場合、製品Aの売上増加が製品Bの売上減少につながる可能性があります。共分散を計算することで、製品戦略や販売戦略を最適化する際に、2つの変数間の関係を理解し、意思決定をサポートできます。

Pythonコード

import numpy as np

sales_A = [10, 20, 30, 40, 50]

sales_B = [5, 15, 25, 35, 45]

covariance = np.cov(sales_A, sales_B)[0, 1]

print(covariance)250.0上記のPythonコードは、2つの製品の売上データから共分散を計算する例です。np.cov() 関数を使用して、sales_A と sales_B の共分散を計算し、結果は 250.0 です。この値は、売上データ間の関係性を示します。

共分散とグラフの関係

共分散は、2つの変数間の関係性を示す統計的な尺度です。共分散が正の場合、2つの変数は同じ方向に動く傾向があり、つまり一方の変数が増加するともう一方も増加する傾向があります。逆に、共分散が負の場合、2つの変数は逆の方向に動く傾向があり、一方の変数が増加するともう一方は減少する傾向があります。

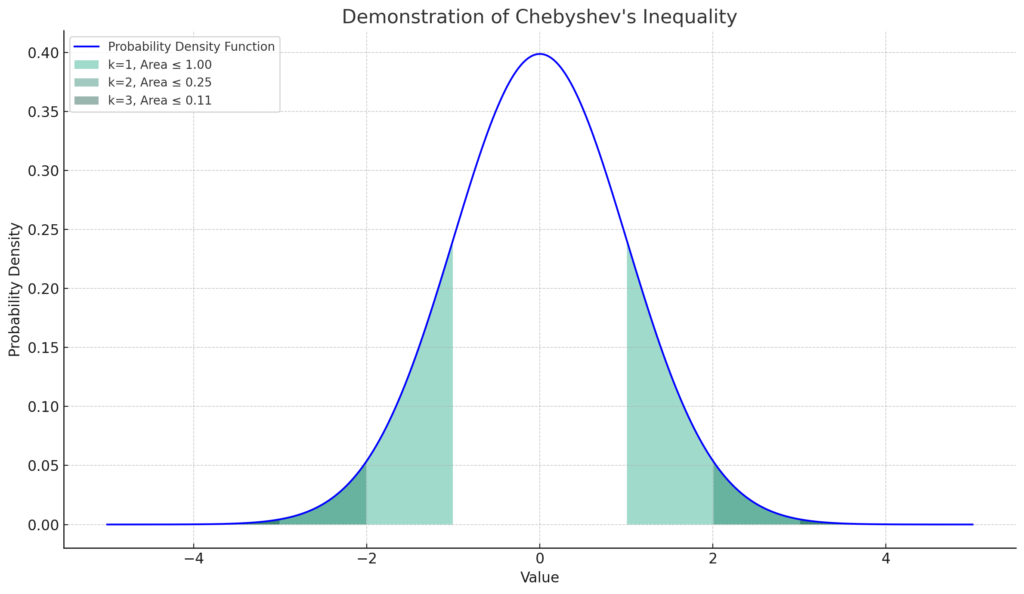

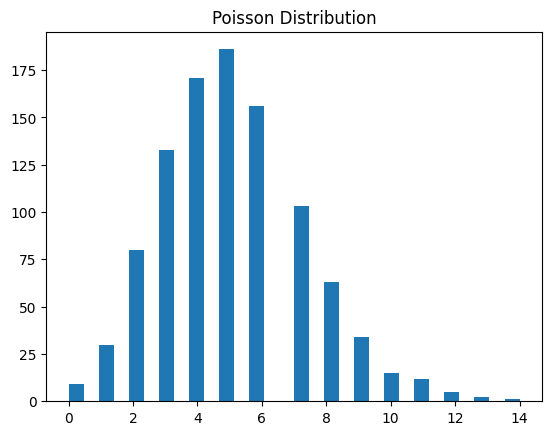

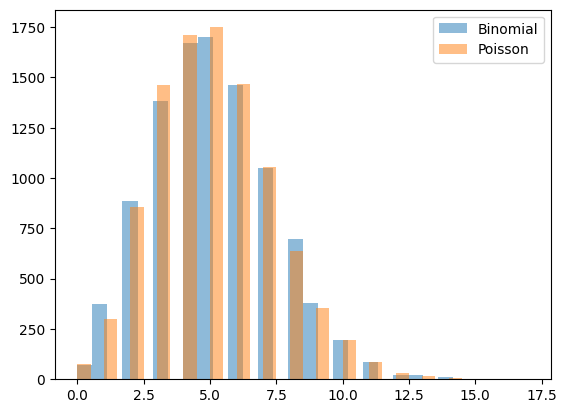

ビジネスの応用例