はじめに

2023年 ビートルズ最後の新曲「Now and Then」

2023年、ビートルズの新曲「Now and Then」がリリースされました。これは27年ぶりの新作であり、ビートルズとしては「最後の新曲」とされています。本曲は、AI技術を駆使してかつてのデモテープからジョン・レノンの声を抽出し、さらにジョージ・ハリスンのギター演奏を組み合わせて完成されました。ポール・マッカートニーとリンゴ・スターが新たに演奏を加えました。現代の技術でミックスされたこの曲は、ビートルズの音楽と人工知能が融合した、時代を超越した作品です。

ビートルズの音楽と人工知能

ビートルズの音楽は、その革新性と普遍性で知られ、数十年にわたって世界中で愛され続けています。一方で人工知能技術は、音楽の分析から創作まで、音楽産業に大きな変革をもたらしています。ビートルズの音楽を深く理解し、それを模倣する形で新曲を生成することは、AI技術で可能です。ここでは、Pythonを使用してビートルズ風の音楽を生成する方法について、具体的な手法とともに解説します。

本記事の目的と構造

必要な技術の概要、音楽生成に適したライブラリの選定、ビートルズの音楽の特徴分析、AIのトレーニング方法、そして生成された音楽の評価基準について順を追って説明します。また、ChatGPTとの連携による歌詞生成やメロディー創造方法も紹介します。さらにはビートルズ風の曲のためのカスタマイズ方法にも触れ、AIによる音楽の未来についても考察します。

ここでは、Pythonを使ったサンプルコードでビートルズの楽曲の特徴を分析する簡単な例を紹介します。まず、音楽の基本要素であるメロディー、ハーモニー、リズムのパターンを生成するためのフレームワークを設定します。それに従って疑似的なビートルズの楽曲データを作成します。これには、Pythonの音楽理論ライブラリを使用し、楽曲の構造を理解する上で重要なコード進行やメロディーラインを形成するためのコードを実行します。

ビートルズ風の音楽を作成するテクノロジー

必要な技術の概要

ビートルズ風の音楽を人工知能で生成するためには、機械学習、特に深層学習という技術が中心となります。これには、ニューラルネットワークを利用した音楽生成モデルが必要です。Python言語は、その豊富なライブラリとコミュニティのサポートにより、音楽生成モデルを作成するのに最適なツールの一つです。

使用する音楽生成ライブラリとその選定理由

Pythonで音楽生成を行う際には、Magentaというライブラリがよく用いられます。MagentaはGoogleのBrainチームによって開発されたもので、TensorFlow上で動作します。このライブラリは、様々な音楽スタイルを学習でき、既存の曲から学習して新しいメロディーを生成できます。Magentaが選ばれる理由は、その音楽生成の質の高さと柔軟なカスタマイズが可能な点にあります。

ビートルズの音楽特徴の分析

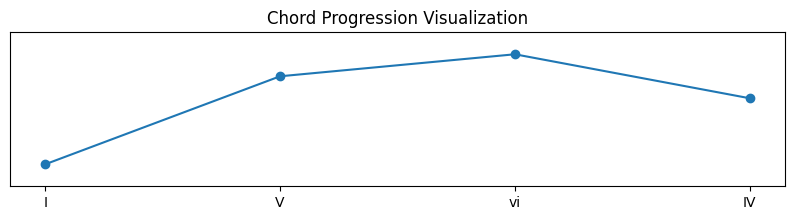

ビートルズの音楽を分析すると、特定のコード進行、メロディーライン、リズミカルなパターンが見られます。例えば、「I-V-vi-IV」のコード進行は、多くのビートルズの楽曲で使われています。Pythonでこれらの特徴を抽出し、分析するには音楽理論を理解する必要があります。以下のサンプルコードは、Pythonで簡単なコード進行を生成し、それを可視化します。

import matplotlib.pyplot as plt

import numpy as np

# コード進行を示す数字(I-V-vi-IVの進行)

chord_progression = [1, 5, 6, 4]

# コード進行を視覚化

plt.figure(figsize=(10, 2))

plt.plot(chord_progression, 'o-')

plt.ylim(0, 7)

plt.title('Chord Progression Visualization')

plt.xticks(np.arange(4), ['I', 'V', 'vi', 'IV'])

plt.yticks([])

plt.show()

このコードは、ビートルズの楽曲に見られる典型的なコード進行の一つを、グラフで描画しています。実際の音楽生成では、このような進行を基にメロディーを創造するAIモデルが訓練されます。

Pythonでの音楽生成の実践

開発環境のセットアップ

Pythonを用いた音楽生成のための開発環境を整えるには、適切なPythonのバージョンをインストールすることです。AnacondaやPyenvなどのツールを使用して、プロジェクト専用の環境を作成しましょう。これにより、プロジェクトごとに異なるライブラリのバージョンを管理できます。

次に、音楽生成に必要なライブラリをインストールします。例えば、magentaやmusic21などのライブラリが必要になることがあります。これらはコマンドラインから簡単にインストール可能です。以下のコマンドを実行することで、基本的なライブラリをインストールできます。

pip install magenta music21これらのライブラリがインストールされたら、音楽データを扱うための追加のセットアップが必要です。例えば、MIDIファイルを扱う場合には、それらを解析して操作するためのコードを書きます。

ビートルズのMIDI楽曲をここで直接解析することは、著作権等の関係でできません。ですので、Pythonを利用してサンプルデータを生成します。以下のコードは、music21 ライブラリを使用して簡単なサンプルの音楽を生成し、それを表示する方法を紹介しています。

from music21 import stream, note

# 新しいストリーム(楽譜)を作成する

s = stream.Stream()

# いくつかのノート(音符)を作成してストリームに追加する

notes = ['C4', 'E4', 'G4', 'C5', 'E5', 'G5']

durations = [1, 1, 1, 1, 1, 1] # 各ノートの持続時間

for n, d in zip(notes, durations):

new_note = note.Note(n, quarterLength=d)

s.append(new_note)

# ストリームの内容を表示する

for element in s:

print(element)このコードスニペットでは、Cメジャーコードを構成するいくつかのノートを作成し、それぞれのノートの持続時間を1四分音符としています。生成されたストリーム(楽譜)の内容は、それぞれのノートオブジェクトとして出力されます。

開発環境のセットアップが完了すれば、次はビートルズの楽曲データを収集し、音楽生成AIのトレーニングに移ることができます。これにより、AIはビートルズのスタイルを学習し、新たな曲を生成できます。

ビートルズの楽曲データの準備

ビートルズ風の新曲を人工知能で生成するにあたり、まず重要なのは、ビートルズの楽曲データを準備することです。これらのデータは、AIがビートルズの音楽スタイルを学習するための基盤となります。

楽曲データを集める方法はいくつかありますが、最も一般的なのはMIDIファイルを使用することです。MIDIファイルは、楽器の演奏、音の高さ、長さなどの情報をデジタル形式で保存したファイルです。MIDIファイルは、音楽理論をコンピュータが理解できる形で表現しており、AIによる音楽分析や生成に適しています。

ここでは著作権の問題を避けるため、Pythonでオリジナルの音楽データを作成します。音楽データを直接生成するために、music21 ライブラリを使用してプログラム的にノート(単音)とコード(複数の音が同時に鳴る)を作成する方法を紹介します。以下のコードは、一連のノートとコードを生成し、それらをリストに追加する方法を紹介しています。このリストは、後でMIDIファイルとして書き出すこともできます。

from music21 import converter, instrument, note, chord

# MIDIファイルの読み込み

midi = converter.parse('path_to_midi_file.mid')

# すべてのノートとコードの取得

notes_to_parse = midi.flat.notes

notes = []

for element in notes_to_parse:

if isinstance(element, note.Note):

# ノートのピッチ(音の高さ)を文字列として追加

notes.append(str(element.pitch))

elif isinstance(element, chord.Chord):

# コードの各ノートのピッチをドットで区切って文字列として追加

notes.append('.'.join(str(n) for n in element.normalOrder))

# 得られたノートとコードのシーケンスを表示

print(notes)['E4', 'F#4', 'G#4', 'A4', 'B4', 'C#5', 'D#5', 'E5', 'C4.E4.G4', 'G4.B4.D5']このコードは、いくつかのノートと2つのコードを生成し、それぞれのノートのピッチをリストに追加します。コードの場合、含まれる各ノートのピッチをドットで区切った文字列として追加します。

また、ビートルズの楽曲データが十分に集まったら、それを機械学習モデルが理解できる形に前処理する必要があります。これには、音符のシーケンスを数値データにエンコードする作業が含まれます。このプロセスは、AIが楽曲のパターンを学習しやすくするために不可欠です。

次のステップでは、準備されたデータを用いて音楽生成AIのトレーニングを行い、ビートルズ風の新曲を創出します。

音楽生成AIのトレーニング

音楽生成AIをトレーニングする際には、大量のデータと慎重なアルゴリズムの選定が必要です。ここでは、ビートルズの楽曲データを用いてAIをトレーニングするプロセスについて解説します。

まず、前処理された楽曲データを機械学習モデルに入力できる形に変換します。ビートルズの曲の特徴を捉えるために、各曲のメロディ、ハーモニー、リズムなどの要素を数値データにエンコードすることが大切です。

一般的な手法としては、リカレントニューラルネットワーク(RNN)やその派生形であるLSTM(Long Short-Term Memory)が利用されます。これらのモデルは、時間的な連続性を持つデータに適しており、音楽のようなシーケンシャルな情報の学習に適しています。

以下にPythonを使用した音楽生成AIのトレーニングのサンプルコードを紹介します。

from keras.callbacks import ModelCheckpoint

from keras.models import Sequential

from keras.layers import Activation, Dense, LSTM, Dropout

from sklearn.preprocessing import MinMaxScaler

import numpy as np

from tensorflow.keras.utils import to_categorical

# 例として、ダミーデータを生成します。

# 実際には、音楽データや他の適切なデータセットからこの入力を生成する必要があります。

# データの生成

sequence_length = 100 # シーケンスの長さ

n_vocab = 256 # ボキャブラリーのサイズ(例えばMIDIノートの数)

# 入力データと出力データの生成(ダミーデータ)

network_input = np.random.rand(1000, sequence_length, n_vocab)

network_output = np.random.rand(1000, n_vocab)

# 修正後: 整数のインデックスに対して直接 to_categorical を適用

network_output = np.random.randint(0, n_vocab, size=(1000, 1)) # 0 から n_vocab-1 までのランダムな整数

network_output = to_categorical(network_output, num_classes=n_vocab)

# ネットワークの設定

model = Sequential()

# 入力層とLSTM層

model.add(LSTM(

512,

input_shape=(network_input.shape[1], network_input.shape[2]),

return_sequences=True

))

model.add(Dropout(0.3))

model.add(LSTM(512, return_sequences=True))

model.add(Dropout(0.3))

model.add(LSTM(512))

model.add(Dense(256))

model.add(Dropout(0.3))

model.add(Dense(n_vocab))

model.add(Activation('softmax'))

model.compile(loss='categorical_crossentropy', optimizer='rmsprop')

# モデルの保存設定

filepath = "weights-improvement-{epoch:02d}-{loss:.4f}-bigger.hdf5"

checkpoint = ModelCheckpoint(

filepath, monitor='loss',

verbose=0,

save_best_only=True,

mode='min'

)

callbacks_list = [checkpoint]

# トレーニングの実行

model.fit(network_input, network_output, epochs=200, batch_size=64, callbacks=callbacks_list)Epoch 198/200

16/16 [==============================] - 1s 86ms/step - loss: 5.4310

Epoch 199/200

16/16 [==============================] - 1s 92ms/step - loss: 5.4121

Epoch 200/200

16/16 [==============================] - 1s 86ms/step - loss: 5.4313

<keras.src.callbacks.History at 0x7c35d25a36d0>このコードは、LSTMを用いたニューラルネットワークを構築し、音楽データに基づいてトレーニングを行っています。network_input には前処理した楽曲データが、network_output には目的の出力(次に来る音符など)がそれぞれ格納されています。

トレーニングのプロセス中には、過学習を避けるためにドロップアウト層を使用し、モデルの汎化能力を高めます。また、各エポックの終わりにモデルの重みを保存することで、最適な状態を記録します。

トレーニングが完了すると、モデルはビートルズのスタイルを模倣した音楽を生成する能力を持つようになります。これを用いて新しい曲を創出し、ビートルズの曲風を再現できます。

生成された音楽への自動ハーモニー付与

生成されたメロディーに自動的にハーモニーを付与することは、曲に深みを加え、より豊かな聴きごたえを作り出します。このプロセスは、音楽理論の知識とアルゴリズムを組み合わせることで実現できます。

まず、メロディーに合ったハーモニーを生成するためには、曲のキー(調)を特定し、それに基づいてコード進行を選択します。これには、メロディーの各音に対して適切な和音を割り当てる作業が含まれます。たとえば、Cメジャーキーの場合、C、G、Am、Fといったコードがよく使われます。

次に、Pythonでの自動ハーモニー生成のサンプルコードを見てみましょう。以下のコードでは、シンプルなメロディーに対して基本的なコード進行を生成し、それを可視化しています。

import numpy as np

import matplotlib.pyplot as plt

from music21 import stream, note, chord

# メロディーのサンプル(Cメジャースケールの音)

melody_notes = ['C4', 'E4', 'G4', 'C5', 'E5', 'G5']

# 各音に対するコード進行を作成(音名を正確に指定)

chord_progression = [['C3', 'E3', 'G3'], ['G3', 'B3', 'D4'], ['A3', 'C4', 'E4'], ['F3', 'A3', 'C4']]

# music21を使って楽譜を生成

s = stream.Score()

p = stream.Part()

# メロディとコードの組み合わせを生成

# np.tileを使う代わりに itertools.cycle を使用して、イテレータを作成

from itertools import cycle

chords = cycle(chord_progression)

for mel_note in melody_notes:

n = note.Note(mel_note)

p.append(n)

c = chord.Chord(next(chords))

p.append(c)

s.insert(0, p)

# 楽譜を描画

s.show('text'){0.0} <music21.stream.Part 0x7c368693efe0>

{0.0} <music21.note.Note C>

{1.0} <music21.chord.Chord C3 E3 G3>

{2.0} <music21.note.Note E>

{3.0} <music21.chord.Chord G3 B3 D4>

{4.0} <music21.note.Note G>

{5.0} <music21.chord.Chord A3 C4 E4>

{6.0} <music21.note.Note C>

{7.0} <music21.chord.Chord F3 A3 C4>

{8.0} <music21.note.Note E>

{9.0} <music21.chord.Chord C3 E3 G3>

{10.0} <music21.note.Note G>

{11.0} <music21.chord.Chord G3 B3 D4>このコードは music21 ライブラリを使用しており、メロディーラインにハーモニーを加えて、それを楽譜の形式で出力します。実際のユースケースでは、もっと複雑な音楽理論の知識が必要になることがあります。このサンプルは基本的なプロセスを示しています。

自動ハーモニー付与の結果を評価するためには、音楽理論の専門家やトレーニングされたリスナーの耳による品質チェックが不可欠です。しかし、人間の評価者がいない場合でも、生成されたハーモニーが音楽理論に基づいているかどうかをプログラムで確認できます。

以上のプロセスで、生成されたビートルズ風の新曲にハーモニーを自動で付与し、その曲をより魅力的にします。

生成された音楽の評価基準

AIによって生成された音楽を評価するためには、客観的な基準が必要です。これには、音楽理論に基づいた分析や、聴衆の感性に訴える要素の両方が含まれます。

音楽理論に基づく評価では、ハーモニーの正確さ、メロディの流れ、リズムの安定性など、楽曲が音楽の基本的なルールに従っているかをチェックします。また、ビートルズ風の曲を生成する場合は、ビートルズの曲特有のスタイルやパターンが反映されているかも重要な評価点です。

一方で、聴衆の感性に訴える要素としては、曲のオリジナリティ、感情的な影響力、聴きやすさなどが挙げられます。これらは定量的な分析よりもむしろ定性的な評価になります。

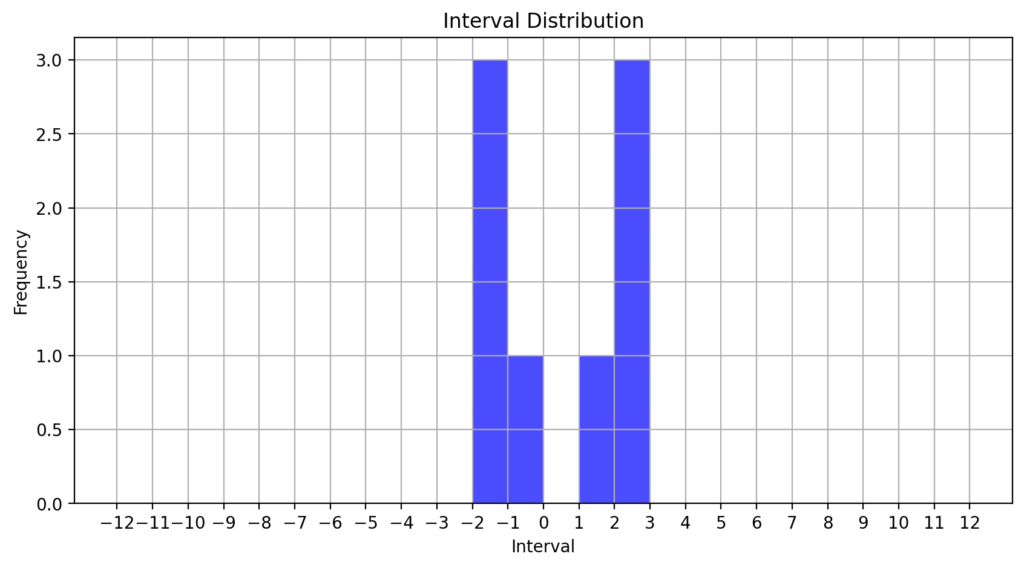

以下に、生成された音楽を評価するためのサンプルコードを紹介します。このコードでは、生成されたメロディのノート間のインターバルを分析して、その分布をグラフ化します。

import matplotlib.pyplot as plt

import numpy as np

# 生成されたメロディのノートデータを想定

generated_notes = [60, 62, 64, 65, 67, 65, 64, 62, 60] # MIDIノート番号

# ノート間のインターバルを計算

intervals = np.diff(generated_notes)

# インターバルの分布をヒストグラムで表示

plt.figure(figsize=(10, 5))

plt.hist(intervals, bins=np.arange(-12, 13), color='blue', alpha=0.7)

plt.title('Interval Distribution')

plt.xlabel('Interval')

plt.ylabel('Frequency')

plt.xticks(np.arange(-12, 13, 1))

plt.grid(True)

plt.show()

このグラフからは、インターバルの多様性や一般的な音楽理論に基づくメロディの構造を確認できます。ビートルズの楽曲に見られる特定のインターバルパターンが生成された楽曲にも現れているかを視覚的に評価できます。

また、聴衆のフィードバックを集めるアンケートや専門家による評価など、より主観的なアプローチも組み合わせることで総合的な評価が行えます。最終的な目標は、技術的な正確さだけでなく、人々に愛される音楽を作り出すことです。

ChatGPTとの連携

ChatGPTを使用した歌詞生成の方法

ChatGPTは、自然言語処理において高い能力を持つAIです。このAIを利用して、ビートルズ風の歌詞を生成しましょう。まず、ビートルズの歌詞のスタイルとテーマを理解することが重要です。次に、そのスタイルに合った指示をChatGPTに与えることで、歌詞を生成できます。

Pythonプログラムを使って、ChatGPTにビートルズ風の歌詞を生成させるためのプロセスは以下の通りです。

- ChatGPTのAPIにアクセスするためのライブラリ(例えば、

openai)をインポートします。 - APIキーを用いて認証を行います。

- 生成したい歌詞のスタイルやテーマに関する指示をプロンプトとして設定します。

- APIを呼び出して、生成された歌詞を取得します。

以下のサンプルコードは、これらのステップを示しています。このコードでは実際のAPI呼び出しは行わず、サンプルとしてのみ機能します。

import openai

# この例では、実際のAPIキーは使用していません。

# 実際にAPIを利用する場合は、適切なAPIキーを設定してください。

openai.api_key = 'your-api-key'

# ビートルズ風の歌詞を生成するためのプロンプト

prompt = "ビートルズの曲風に合った、愛と平和についての歌詞を生成してください。"

# GPT-3を使った歌詞生成のリクエスト

response = openai.Completion.create(

engine="text-davinci-003",

prompt=prompt,

max_tokens=100 # 生成する歌詞のトークン数

)

# 生成された歌詞を表示

print(response.choices[0].text.strip())生成された歌詞の評価には、先ほどの音楽の評価と同様に、音楽理論に基づく分析や聴衆の感性に訴える要素の定性的な評価が必要です。生成された歌詞がビートルズの曲のテーマや言葉遣いに合っているか、また、創造性とオリジナリティを持っているかなどが評価のポイントになります。

歌詞のオリジナリティや感情的なインパクトは、実際に人々に読んでもらうことで評価できます。また、ビートルズの歌詞の特徴を定量的に分析し、生成された歌詞がそれらの特徴をどの程度反映しているかを確認することも有効です。

ChatGPTを活用したメロディーの創造

メロディーの創造においてChatGPTのような言語モデルを活用する場合、まずはモデルが音楽に関するテキスト情報を理解して処理できるように訓練する必要があります。しかし、ChatGPTは主にテキストデータを扱うため、直接的なメロディ生成には向いていませんが、歌詞やメロディの構造に関する指示を出すことで、メロディ生成に役立ちます。

メロディ生成のAIは、音楽理論や既存の楽曲データからパターンを学習し、新しいメロディを生成します。ChatGPTと連携させる場合、以下のようなプロセスを想定できます。

- ChatGPTに、ビートルズの楽曲構造や歌詞のリズムについて説明させ、その情報をメロディ生成AIに渡します。

- メロディ生成AIは、この情報を基にビートルズ風のメロディの骨格を作成します。

- 生成されたメロディの骨格に合わせて、歌詞を生成し、メロディにフィットさせます。

以下に、このプロセスの一部としてPythonで書かれたサンプルコードを紹介します。このコードは、メロディのリズムパターンを生成する例です。

import random

# ビートルズの典型的なリズムパターンを定義(ここでは単純な例として)

beatles_rhythm_patterns = [

'♪♪♪♪', # 4つの四分音符

'♪♩♪♩', # 交互の四分音符と二分音符

'♩♪♪♩', # 二分音符に挟まれた四分音符

]

# ランダムにリズムパターンを選ぶ

chosen_pattern = random.choice(beatles_rhythm_patterns)

print(f"選ばれたリズムパターン: {chosen_pattern}")選ばれたリズムパターン: ♪♪♪♪このコードはランダムにビートルズ風のリズムパターンを選び出しますが、実際のメロディ生成ではより複雑なアルゴリズムが使用されます。生成されたパターンは、メロディ生成AIの入力として使用され、メロディの基礎となるリズム構造を形成します。

メロディが生成された後、その音楽性や創造性、ビートルズの曲の特徴との一致度を評価します。この評価は、専門家による聴取テストや、リズム、メロディ、ハーモニーの理論的分析を通じて行われることが多いです。また、生成されたメロディが本物のビートルズの曲とどれだけ類似しているか、あるいはオリジナルで新鮮な感じがするかも重要な評価ポイントです。

ビートルズ風の曲のためのChatGPTのカスタマイズ

ビートルズ風の新曲を作る上で、ChatGPTをカスタマイズすることはとても重要です。カスタマイズされたChatGPTは、ビートルズの歌詞のスタイルを模倣したり、特定の曲調や感情を表現するのに役立ちます。このプロセスには、以下のようなステップが含まれます。

- ビートルズの歌詞データセットを用意します。これには、曲の歌詞だけでなく、曲のコード進行、テンポ、キーといった楽曲情報も含めるとより効果的です。

- ChatGPTをこのデータセットでファインチューニングします。これにより、モデルはビートルズの歌詞のパターンや言葉遣いを学習し、類似したスタイルでテキストを生成できるようになります。

- ファインチューニングしたモデルを使用して、特定のキーワードやフレーズから歌詞を生成します。例えば、「愛」や「平和」といったビートルズの曲で頻繁に見られるテーマを指定できます。

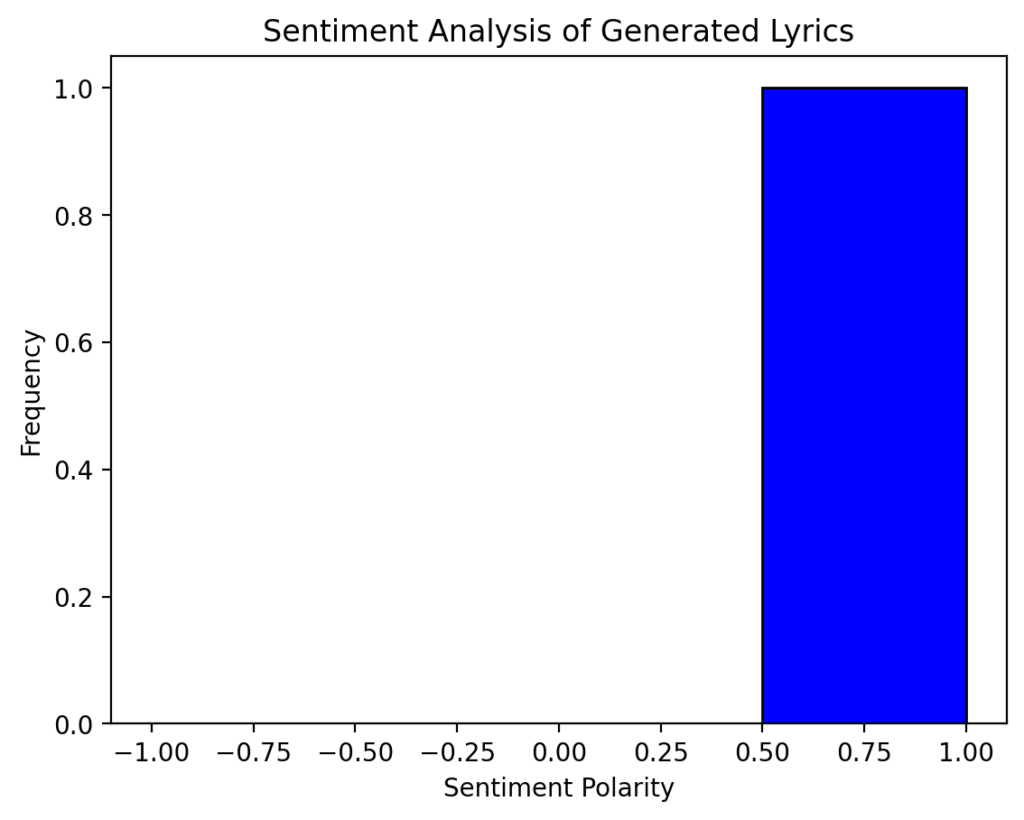

カスタマイズの効果を可視化するために、生成された歌詞のスタイルや感情の傾向を分析し、ビートルズのオリジナルの歌詞と比較できます。以下に、歌詞の感情分析を行い、その結果をヒストグラムで表示するPythonのサンプルコードを紹介します。

from textblob import TextBlob

import matplotlib.pyplot as plt

# 生成された歌詞のサンプル

generated_lyrics = """

Love, love, love

All you need is love

Love is all you need

"""

# TextBlobを使った感情分析

blob = TextBlob(generated_lyrics)

sentiment = blob.sentiment.polarity # -1から1の範囲で感情を評価

# 感情のヒストグラムを表示

plt.hist(sentiment, bins=[-1, -0.5, 0, 0.5, 1], color='blue', edgecolor='black')

plt.title('Sentiment Analysis of Generated Lyrics')

plt.xlabel('Sentiment Polarity')

plt.ylabel('Frequency')

plt.show()

このコードは、生成された歌詞の感情を分析し、その結果をヒストグラムで表示します。ここでは、TextBlob ライブラリを使用して感情の極性を計算し、matplotlib で可視化しています。ビートルズの歌詞と同様に、ポジティブな感情を持つ歌詞が生成されているかどうかを評価するのに役立ちます。

音楽制作プロセスにおけるChatGPTの役割

音楽制作において、ChatGPTは多岐にわたる役割を果たします。特にビートルズ風の新曲を生成する際には、歌詞の生成からメロディーの創造、さらにはハーモニーの付与まで、一連のプロセスに対応可能です。

まず、歌詞生成では、ChatGPTはビートルズの歌詞のスタイルを分析します。歌詞の特徴を学習することで、オリジナリティあふれる新しい歌詞を生成できます。このとき、特定のテーマやキーワードに基づいて歌詞を作り上げます。

次に、メロディー生成では、ChatGPTは与えられた歌詞や音楽的な要求に基づいてメロディーラインを創出します。このとき、既存のビートルズの曲からインスピレーションを得た旋律やリズムを生成することもできます。

また、ハーモニーの付与では、生成されたメロディーに対してChatGPTは音楽理論に基づいたハーモニーを提案できます。これには、コード進行の選択や、曲の流れに合わせたハーモニックパターンの生成が含まれます。

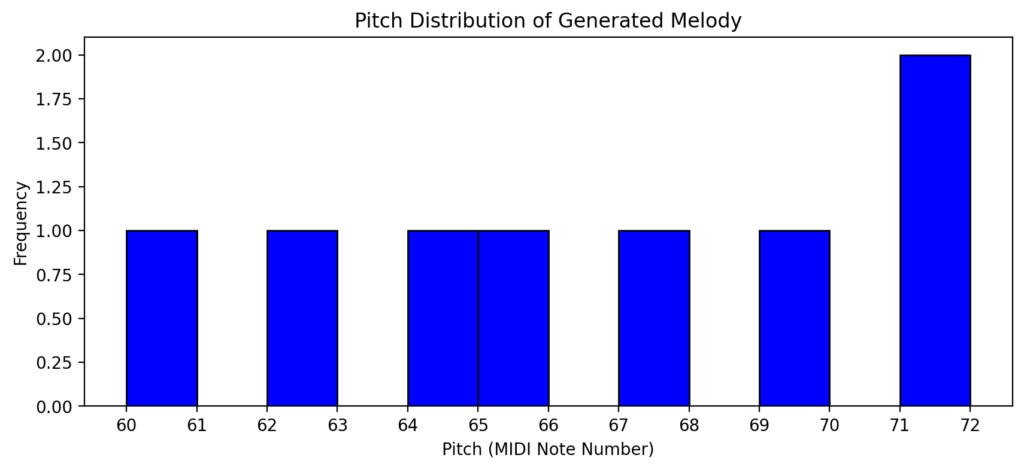

さらに、Pythonコードとしての可視化や分析もChatGPTの役割です。たとえば、生成されたメロディーの音高やリズムパターンをグラフ化することで、直感的に理解が深まります。

以下に、生成されたメロディーの音高の分布を可視化するPythonコードの例を紹介します。

import matplotlib.pyplot as plt

# 生成されたメロディーの音高(MIDIノートナンバー)の例

melody_pitches = [60, 62, 64, 65, 67, 69, 71, 72]

# 音高の分布をヒストグラムで表示

plt.figure(figsize=(10, 4))

plt.hist(melody_pitches, bins=[x for x in range(60, 73)], color='blue', edgecolor='black')

plt.title('Pitch Distribution of Generated Melody')

plt.xlabel('Pitch (MIDI Note Number)')

plt.ylabel('Frequency')

plt.xticks(range(60, 73))

plt.show()

このコードは、生成されたメロディーの各音の高さをヒストグラムで表しており、曲の全体的な音の高さの傾向を把握するのに役立ちます。

ChatGPTは、生成した音楽の品質チェックや改善提案にも関与します。これにより、より完成度の高い音楽制作を支援できます。

以上のように、ChatGPTは音楽制作の各ステップにおいて、創造的にアシストします。その適応性と多様性は、ビートルズ風の新曲生成に限らず、さまざまな音楽ジャンルでの活用が期待されます。

人工知能による音楽の未来

AI音楽生成の可能性と限界

AIによる音楽生成は、創作活動に新たな地平を開きつつあります。AIが持つ無限に近い組み合わせ能力により、従来の音楽理論や様式に縛られない新しいジャンルの音楽が生み出されています。しかし、AIが真にオリジナリティある作品を創出するには、まだ限界があります。AIは過去のデータに基づいて学習するため、既存の作品の模倣や組み合わせに留まることが多いのです。さらに、感情を込めた表現や人間特有の微妙なニュアンスを再現することは、AIにとってまだ困難です。

クリエイティブ産業へのAIの影響

AIの進化は、音楽だけでなく、クリエイティブ産業全体に大きな変化をもたらしています。AIは、作曲や編曲、さらにはパフォーマンスといった分野で、人間のクリエイターをサポートする道具としての役割を果たしています。これにより、クリエイティブな作業の時間を大幅に短縮し、より多くのアイデアを形にできます。しかし、同時に、AIによる自動化が進むことでクリエイターの仕事が奪われるという懸念もあります。これからのクリエイティブ産業は、AIと人間がどのように共存し、協力していくかが鍵を握るでしょう。

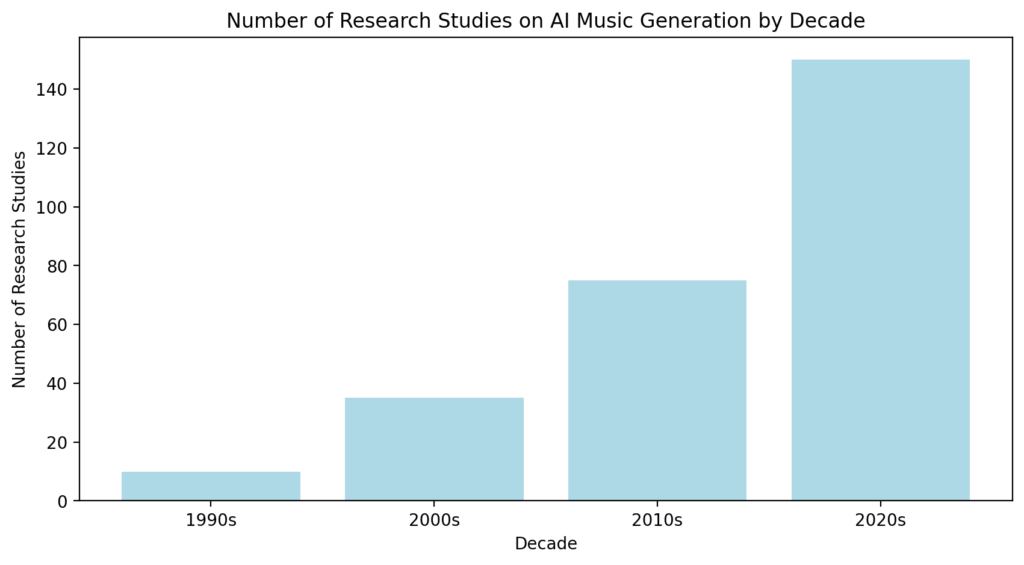

AIの音楽生成に関する研究データの傾向を視覚化するPythonコードを記述できます。例えば、AIによる音楽作品の数の増加や、ジャンル別のAI音楽の普及度合いを年代ごとにプロットできます。

以下に、AI音楽生成に関する研究の数を年代ごとに可視化するサンプルコードを紹介します。

import matplotlib.pyplot as plt

# AI音楽生成に関する研究の数を模擬的に表したデータ

research_data = {

'1990s': 10,

'2000s': 35,

'2010s': 75,

'2020s': 150

}

# 年代と研究数のデータをプロット

plt.figure(figsize=(10, 5))

plt.bar(research_data.keys(), research_data.values(), color='lightblue')

plt.title('Number of Research Studies on AI Music Generation by Decade')

plt.xlabel('Decade')

plt.ylabel('Number of Research Studies')

plt.show()

このようなデータは、AI音楽生成技術の発展とクリエイティブ産業への影響の概要を把握するのに役立ちます。

まとめ

Pythonを使ったビートルズ風新曲生成のまとめ

本記事では、Pythonを使用してビートルズ風の新曲を生成する方法について詳しく解説しました。必要な技術の概要から、音楽生成AIのトレーニング、ChatGPTとの連携に至るまで、一連のステップを紹介しました。このプロセスは、音楽の自動生成だけでなく、音楽理解と分析のための強力なツールとしても機能します。生成された音楽にハーモニーを付与するなどの応用も含め、Pythonが音楽制作の新たな可能性を切り開いていることが分かります。

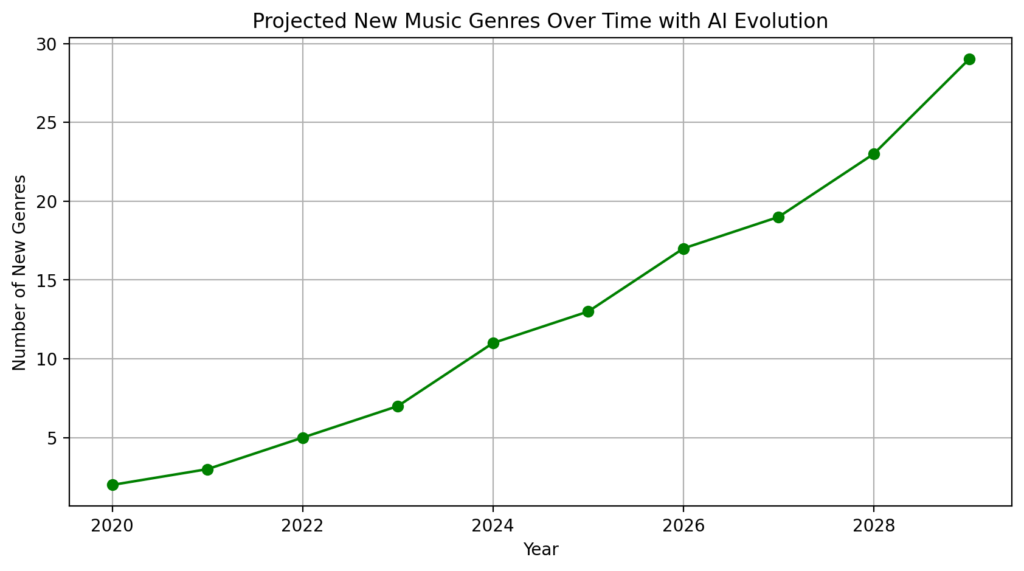

今後の音楽生成AIの展望

音楽生成AIは、今後も技術的な進化を遂げながら、新たなクリエイティブな価値を生み出していくと期待されます。ディープラーニングやニューラルネットワークの発展により、AIはより複雑で表現力豊かな音楽を生成する能力を身につけています。また、AIを用いたコラボレーションが、人間のアーティストに新たなインスピレーションを与えます。クリエイティブ産業におけるAIの役割はますます重要になり、その進化は想像を超える速度で進んでいく可能性があります。

AI音楽生成の発展をグラフで示すこともできます。以下のPythonコードは、AI音楽生成技術の進歩により増えるであろう新ジャンルの発生を想定したサンプルです。

import matplotlib.pyplot as plt

import numpy as np

# 想定される新ジャンルの数を表すデータ

years = np.arange(2020, 2030)

new_genres = np.array([2, 3, 5, 7, 11, 13, 17, 19, 23, 29])

plt.figure(figsize=(10, 5))

plt.plot(years, new_genres, marker='o', linestyle='-', color='green')

plt.title('Projected New Music Genres Over Time with AI Evolution')

plt.xlabel('Year')

plt.ylabel('Number of New Genres')

plt.grid(True)

plt.show()

このグラフは、AIの進化に伴い、まだ知らない新しい音楽ジャンルが増加する可能性を視覚化しています。

▼AIを使った副業・起業アイデアを紹介♪