AIエンジニアやプログラマーに転職して、AIメガネの開発に挑戦しましょう。

最近の技術進歩により、AIメガネは驚くべき機能を提供できるようになっています。

AIメガネの開発に使用されるIT技術や具体的なPythonコードも解説しますので、AIエンジニアやプログラマーに転職したい方には必読の内容です。

また、AIメガネの技術を応用したビジネスアイデアも紹介しますので、新しい視点や発想を得られますよ。

AIメガネ登場!

Brilliant Labsは、世界初のマルチモーダルAIアシスタントを統合した眼鏡「Frame」を発表しました。

Frameは、常時オンのAIアシスタント「Noa」を搭載し、GPT-4やStability AIなどを同時に実行できます。

視覚処理、画像生成、音声認識と翻訳などが可能です。

また、Frameは開発者向けにオープンソースモデルを採用しており、ハードウェアとソフトウェアの両方をカスタマイズ可能です。

価格は300ドルで、2024年3月に予約受付が開始されます。

記事を元に、Brilliant Labsの「Frame」メガネが持つ機能を紹介しましょう。

- AIアシスタント「Noa」の搭載:

GPT-4やStability AIなどの複数のAIシステムを同時に実行し、視覚処理、画像生成、音声認識と翻訳を行います。

ユーザーとのやり取りを通じて個性的なアシスタントに成長するAIメガネです。 - リアルタイム処理:

見たものや聞いたもの、現在の場所などのリアルワールドの入力を利用して、AIを操作できます。

本のページの要約、外国語の翻訳、ホワイトボードセッションの構築などが可能です。 - 検索エンジンとしての機能:

店舗での商品価格を確認したり、家を見てそのリスティングを特定したりできます。 - スタイリッシュなデザイン:

軽量で、普通の眼鏡と見分けがつかないデザイン。

クラシックなヴィンテージスタイルで、さまざまな色のオプションがあります。 - 高解像度ディスプレイとカメラ:

3,000ニットの明るさを持つ高解像度ディスプレイ。

前面には空間カメラ、マイク、6DoF IMUが搭載されています。 - 処方レンズの対応:

AddOpticsとの提携により、処方レンズを取り付けることが可能です。 - 開発者向けオープンソースモデル:

ハードウェアとソフトウェアの両方をカスタマイズ可能で、開発者が自由に探索できるリソースが提供されています。 - プライバシー保護:

生成された画像やビデオは保存されず、使用後に消去されます。

AIメガネの開発:利用されるIT技術

AIメガネがあれば、誰でも医者、弁護士、税理士、裁判官、大学教授、通訳者になれそうですね。

オープンソースで開発でき、個性的なアシスタントに成長するAIメガネということです。

AIメガネの開発に使用される主なIT技術は、下記のとおりです。

- プログラム言語:

Python:AIモデルの開発とデータ解析に広く使用される言語。

C++:ハードウェアとのインターフェースやパフォーマンスが重要な部分で使用される。 - AI技術:

GPT-4:自然言語処理(NLP)のための大規模言語モデル。テキスト生成や理解に使用される。

Stability AI:画像生成や加工に使用される技術。

Whisper AI:音声認識と翻訳に使用される技術。 - データベース技術:

NoSQLデータベース(例:MongoDB):柔軟なデータモデルを持ち、大量の非構造化データの管理に適している。

SQLデータベース(例:MySQL、PostgreSQL):構造化データの効率的な管理とクエリ処理に使用される。 - クラウド技術:

AWS(Amazon Web Services):AIモデルのトレーニングやデプロイメント、データストレージに使用される。

Google Cloud Platform(GCP):機械学習とデータ解析のためのサービスを提供。

Microsoft Azure:クラウドベースのAIサービスやデータストレージに利用。 - セキュリティ対策:

データ暗号化:ユーザーデータや生成されたデータの保護のために暗号化技術を使用。

アクセス制御:認証と認可を通じて、データやシステムへのアクセスを制限。

プライバシー保護:ユーザーデータのプライバシーを守るための方針と技術を実装(例:データの匿名化、使用後のデータ消去)。

AIメガネの開発には、上記のようなIT技術が利用されます。

PythonとAIでAIメガネを開発

PythonとAIで、AIメガネを開発するコードを書いてみましょう。

以下のPythonコードでは、機械学習モデルを用いて画像データを分類します。

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.decomposition import PCA

from sklearn.svm import SVC

from sklearn.metrics import classification_report, confusion_matrix

# Generate sample data

# Creating a sample dataset for image classification

np.random.seed(0)

X = np.random.rand(100, 50) # 100 samples, 50 features (simulating image data)

y = np.random.choice([0, 1], 100) # Binary target variable

# Split the data into training and testing sets

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Standardize the data

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

# Apply PCA for dimensionality reduction

pca = PCA(n_components=10)

X_train_pca = pca.fit_transform(X_train_scaled)

X_test_pca = pca.transform(X_test_scaled)

# Train a Support Vector Machine (SVM) classifier

svm = SVC(kernel='linear')

svm.fit(X_train_pca, y_train)

# Make predictions

y_pred = svm.predict(X_test_pca)

# Evaluate the model

print("Classification Report:")

print(classification_report(y_test, y_pred))

print("Confusion Matrix:")

print(confusion_matrix(y_test, y_pred))

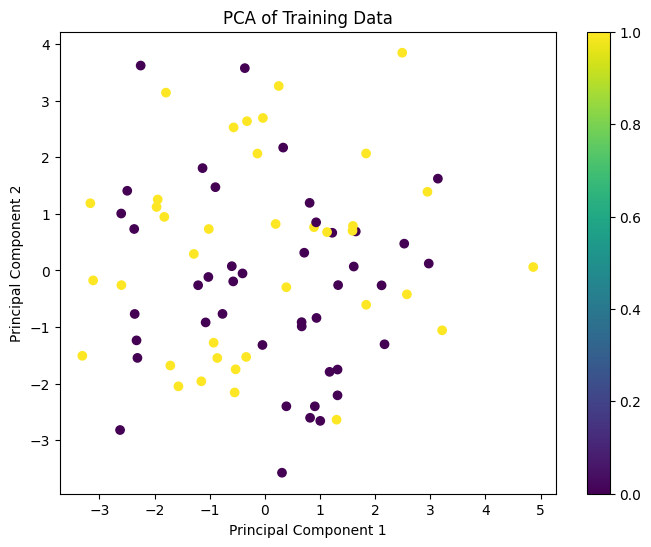

# Plot the PCA components

plt.figure(figsize=(8, 6))

plt.scatter(X_train_pca[:, 0], X_train_pca[:, 1], c=y_train, cmap='viridis')

plt.title('PCA of Training Data')

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.colorbar()

plt.show()Classification Report:

precision recall f1-score support

0 0.50 0.40 0.44 10

1 0.50 0.60 0.55 10

accuracy 0.50 20

macro avg 0.50 0.50 0.49 20

weighted avg 0.50 0.50 0.49 20

Confusion Matrix:

[[4 6]

[4 6]]

- データの生成:

np.random.seed(0):乱数生成のシードを設定し、再現性を確保。X = np.random.rand(100, 50):100サンプル、50特徴量のランダムなデータを生成(画像データをシミュレート)。y = np.random.choice([0, 1], 100):0と1の二値分類用のターゲット変数を生成。 - データの分割:

train_test_split関数を使用してデータを訓練セットとテストセットに分割。 - データの標準化:

StandardScalerを使用してデータを標準化し、各特徴量の平均を0、分散を1にする。 - PCAによる次元削減:

PCAを使用して次元を50から10に削減し、データの主成分を抽出。 - SVMモデルの訓練:

SVCを使用して線形カーネルのサポートベクターマシンを訓練データに適合。 - 予測と評価:

predictメソッドを使用してテストデータの予測を行い、classification_reportとconfusion_matrixでモデルの性能を評価。 - PCA成分のプロット:

訓練データの主成分を散布図で可視化し、各サンプルのクラスを色で区別。

AIメガネの開発:応用アイデア

AIメガネの開発について、応用アイデアを考えてみましょう。

同業種への応用アイデア

- 医療分野:

診断補助:患者の症状をリアルタイムでモニターし、異常を検知して医師にアラートを送る。

外科手術支援:手術中に必要な情報を表示し、医師の手技をサポートする。 - 教育分野:

インタラクティブ学習:学生が実際に見たり聞いたりする情報を基にリアルタイムでフィードバックを提供。

特別支援教育:視覚や聴覚に障害がある学生に対して、補助的な情報を提供。 - 製造業:

品質管理:製品の品質をリアルタイムでチェックし、不良品を即座に検出する。

作業指示:作業者が必要な指示をリアルタイムで受け取り、生産効率を向上させる。 - 物流・運輸:

ルート最適化:ドライバーが最適なルートを選択できるよう、リアルタイムでナビゲーションを提供。

荷物追跡:荷物の位置情報や状態をリアルタイムでモニターし、異常を通知。

他業種への応用アイデア

- 観光業:

ガイド機能:観光名所の情報をリアルタイムで提供し、音声ガイドや翻訳機能も追加。

安全管理:危険な場所や状況を検知し、観光客にアラートを送る。 - 小売業:

商品情報の提供:店内の商品に関する詳細情報をリアルタイムで表示し、購入を支援。

在庫管理:店内の在庫状況をモニターし、補充が必要な商品を通知。 - 建設業:

現場管理:建設現場の進捗状況や安全状況をリアルタイムでモニターし、管理者に報告。

設計支援:設計図を視覚化し、現場での設計変更をリアルタイムで確認。 - エンターテインメント業:

ライブイベントの補助:コンサートやスポーツイベントでのリアルタイム情報提供や、視覚効果の強化。

ゲーム開発:AR技術を活用し、没入感のある新しいゲーム体験を提供。

AIメガネの開発は、さまざまな分野に応用できそうですね。まさに、早い者勝ちのビジネスチャンスです。

AIメガネの開発:まとめ

AIメガネの開発について解説しました。

AIメガネの開発に必要なIT技術や、Pythonの具体的なコーディング方法を説明したので、AIエンジニアやプログラマーに転職を考えている方の参考になったと思います。

また、AIメガネを応用したビジネスや新しいアイデアについても紹介しました。

あなたもAIエンジニアやプログラマーに転職して、AIメガネの開発に挑戦しましょう!

▼AIを使った副業・起業アイデアを紹介♪